本文是LLM系列的文章,针对《Decoupling Knowledge from Memorization:

Retrieval

摘要

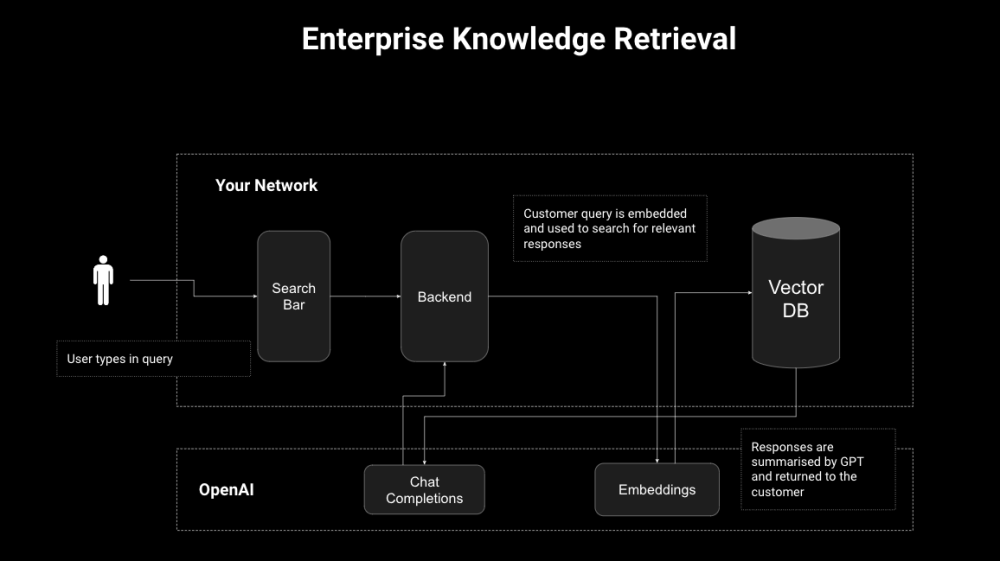

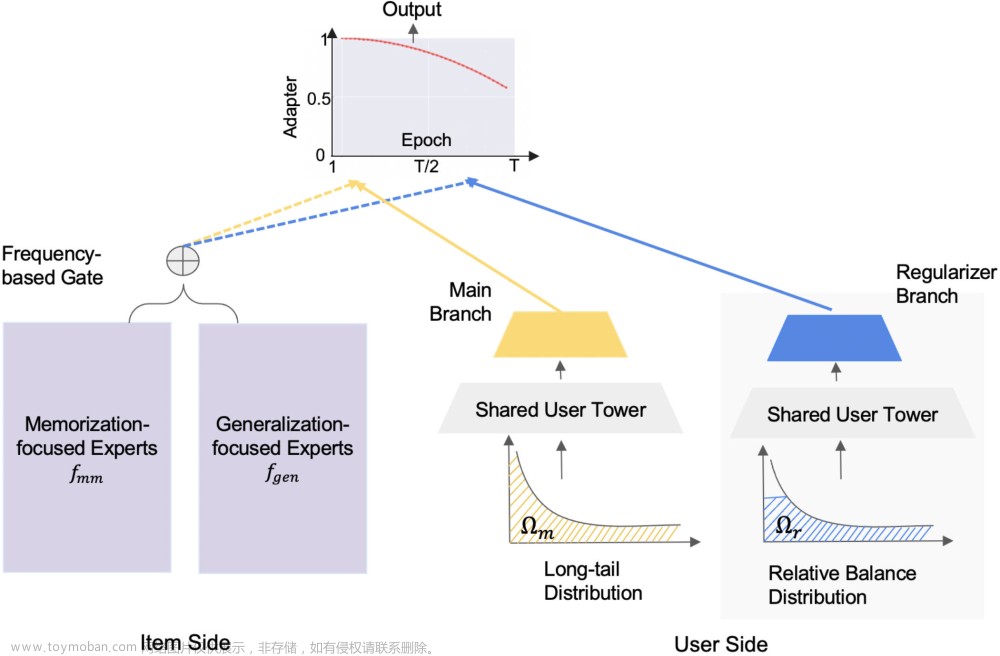

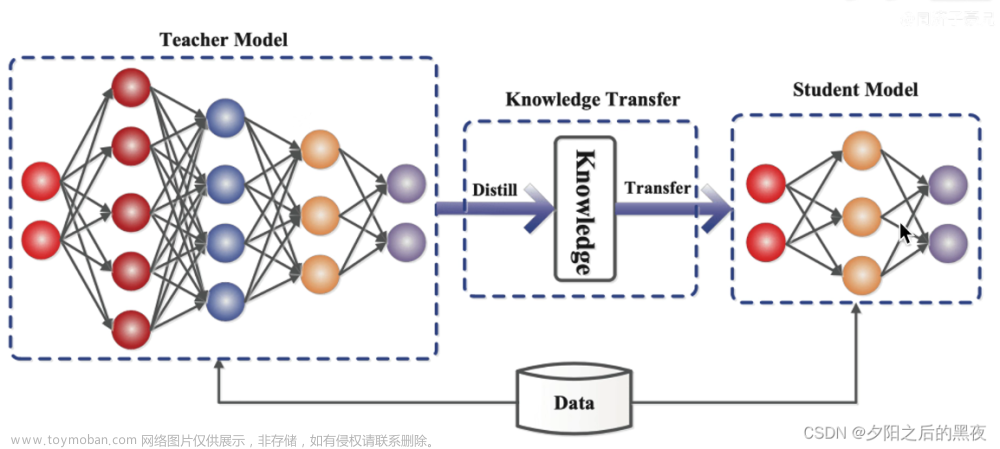

提示学习方法在仍然遵循基于参数的学习范式的同时,通过诱导更好的小样本表现,在自然语言处理中掀起了波澜;学习中的遗忘和死记硬背问题可能会遇到不稳定的泛化问题。具体来说,在完全监督的训练中,朴素的提示学习可能很难死记硬背地利用非典型实例,或者用低样本数据过度拟合浅层模式。为了缓解这些限制,我们开发了RETROPROMPT,其动机是将知识与记忆脱钩,以帮助模型在泛化和记忆之间取得平衡。与普通的提示学习相比,RETROPROPT从训练实例中构建了一个开卷知识库,并在输入、训练和推理过程中实现了检索机制,从而使模型能够从训练语料库中检索相关上下文作为增强的线索。大量的实验表明,RETROPROPT可以在小样本和零样本设置中获得更好的性能。此外,我们还进一步说明了我们提出的RETROPROPT可以在新的数据集上产生更好的泛化能力。对记忆的详细分析确实表明,RETROPROMPT可以减少语言模型对记忆的依赖;因此,提高了下游任务的泛化能力。文章来源:https://www.toymoban.com/news/detail-674322.html

1 引言

2 提示学习的前言

3 RETROPROMPT:检索增强的提示学习

4 实验

5 相关实验

6 结论与未来工作

我们提出了通过引入检索增强来将知识与记忆解耦的RETROPROPT,以进一步提高输入端提示学习的泛化能力以及模型训练和预测的整个过程。RETROPROPT是一种简单而有效的检索方法,它结合了神经演示、用于训练和预测的kNN指南。我们的广泛研究结果表明,它在小样本、零样本和全监督设置中优于其他演示增强提示方法和知识增强提示方法。分析记忆的本质,验证了知识与记忆脱钩的有效性。有趣的未来方向包括:1)应用于其他任务,如QA和NLG,2)探索用于无监督学习的噪声数据挖掘,3)进一步提高大型数据集的检索效率,等等。文章来源地址https://www.toymoban.com/news/detail-674322.html

到了这里,关于Decoupling Knowledge from Memorization: Retrieval-augmented Prompt Learning的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!