声明:仅供参考学习,参考,若有不足,欢迎指正

你是不是遇到过这种情况,在pc端上音乐无法下载,必须下载客户端才能下载?

那么,爬虫可以解决这个麻烦!继续实战利用request和xpath爬取网上音乐。

本文主要是在网页端下载音乐,如果你有客户端也可以,太高级的笔者也不会。这是一个基础皮毛的练习

分析网页

定位目标网址:(你也可以在浏览器打开某云之后随便进入一个歌单)

https://music.163.com/#/playlist?id=26467411

对于网页上的音乐在进行下载时,经常会弹出提示页面:请前往客户端下载!!!

非常讨厌了也是,好好的下载一首歌曲,非要弄得这么麻烦。甚至,有些音乐在下载了软件后,需要付费或者VIP,万恶的资本家。

本次实战就可以通过简单的爬虫解决以上问题,直接下载歌曲。

- 首先,检查—> Network —> 刷新

- 点击 文档(Doc),可以看到它的标头里面的请求网址为:

https://music.163.com/playlist?id=26467411 这跟最开始是不一样的。

这是因为我们所请求的网址并非是浏览器地址栏上的网址,通过这张截图,很清晰的发现我们所请求的网址是哪个了。

- 通过对每首歌曲打开,进行网页源代码分析不难发现,本网页的歌曲都有一个共同的特点:即前面的网址为 https://music.163.com/#/song?id= 加每首歌曲的 id 号。

然而,目前为止,我们仅仅是找到了些许规律,并没有找到歌曲的真正链接,要真正下载到每一首歌曲,还遥不可及。

音乐文件一般为mpeg,mp3,mpeg-4,midi,mwa,m4a等

到现在为止还没有请求音乐,当我们在进行点击播放时会发现:

当我们在进行播放音乐时,请求数量增多,说明该网页又重新进行了对网页的请求。通过重新查找发现(只需查看后面新的内容)这次有了一些 .m4a 文件。

当点击这些文件打开时会发现,有一个新的 Request URL:,当你将该网址复制在新的网页下进行打开,会出现如下图所示(打开时浏览器会自动进行下载该音乐)

结合上面的情况来说,我们是不是已经成功了呢?但很难过的告诉你,这个网址在短时间内打开,的确会有用,但是,它是有时间限制的,不信的话,你可以过五分钟(或许还不需要这么久)再重新打开该网址,试一下。

所以这种方式行不通,由于是初学者,我们就需要点外援了。

第二种方式

- 这里介绍一个新的URL:(不要问这个怎么来的)

http://music.163.com/song/media/outer/url?id=

在之前的分析中,我们发现了一个很重要的一点,便是这10首歌曲都是一个网址加每首歌曲的id所在的新页面。

我们有了上面的这个网址,便可以为所欲为了。你现在便可以立马复制上面的链接,在网页上找到一首歌曲的id号添加至网址后面进行打开(如:http://music.163.com/song/media/outer/url?id=36897723),是不是得到了如下的界面:

通过这个页面就可以直接下载。

批量爬取

首先,每首音乐可以通过这个网址 ➕ id 进行下载,所以,我们第一步便是想办法获取每首音乐的 id 。根据之前的分析,不难发现,每首音乐的 id 都在一个<a>标签内,我们只要获取这个<a>就可以了。

一步一步来开始写代码

- 根据真正的目标网址(注意真正的)获取源码信息

import requests

from lxml import etree

# 真实地址在Network--Doc

url = 'https://music.163.com/playlist?id=26467411'

# 请求(requests) 图片,视频,音频 content | 字符串 text

html_str = requests.get(url).text

print(html_str)

print(type(html_str)) # 字符串类型

result = etree.HTML(html_str)

- 从源码中用 xpath 找到每首歌的id和name

song_ids = result.xpath('//a[contains(@href,"/song?")]/@href') # 歌曲id

song_names = result.xpath('//a[contains(@href,"/song?")]/text()') # 歌名

# print(song_ids)

# print(song_names) #列表

for song_id,song_name in zip(song_ids,song_names):

print(song_id)

print(song_name)

整理一下

通过打印发现,前面多了一些 /song?id= ,这时,便使用下面这行代码,进行删减,仔细观察打印结果发现后面多了三个无用的,这三个必须删掉才行,不然在进行后面的 URL 拼接,肯定会报错,因为压根就找不到这样的一个网址。文章来源:https://www.toymoban.com/news/detail-675036.html

count_id = song_id.strip('/song?id=') # 去掉/song?id=

# print(count_id)

# 过滤含有“$”符号

if ('$' in count_id) == False:

print(count_id)

- 拼接URL后,在浏览器里打开上面的任意链接

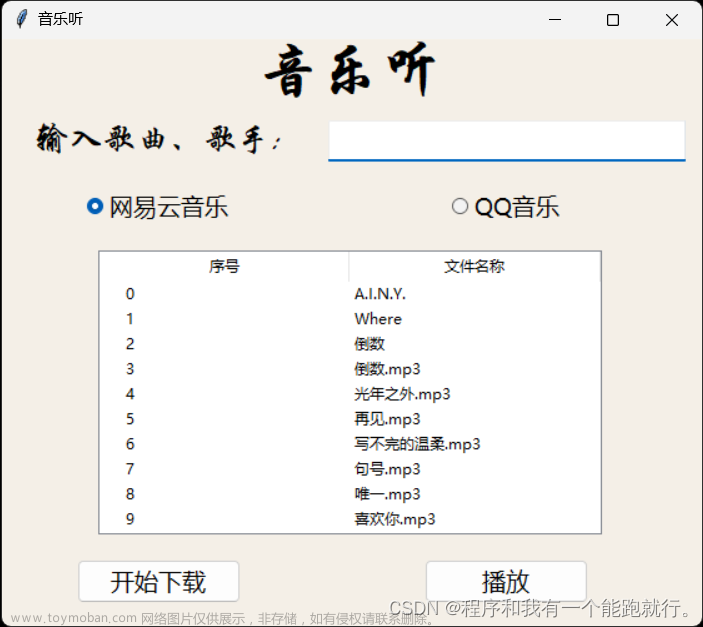

song_url,即可获取该音乐的链接,并进行下载。但是,我们最终的目的是让爬虫自动帮我们全部下载并进行保存至文件夹,利用 for 循环就可以啦

song_url = base_url + count_id # 拼接url

print(song_url)

mp3 = requests.get(song_url).content

# 保存数据

with open('yinyue/{}.mp3'.format(song_name),'wb') as file:

file.write(mp3)

如需完整代码,请自行查看。某云音乐爬取文章来源地址https://www.toymoban.com/news/detail-675036.html

到了这里,关于python爬虫实战零基础(3)——某云音乐的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!