问题

今天 Hive 导入 csv 文件时,开始时建表语句如下:

CREATE TABLE IF NOT EXISTS test.student (

name STRING COMMENT '姓名',

age STRING COMMENT '年龄',

gender STRING COMMENT '性别',

other_info STRING COMMENT '其他信息'

)

COMMENT '学生信息表'

ROW FORMAT DELIMITED

FIELDS TERMINATED BY ','

STORED AS TEXTFILE;

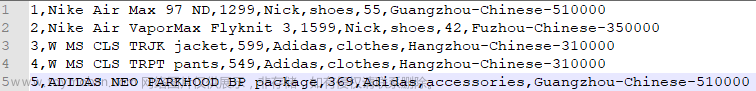

然后导入 csv 文件,发现数据串列了,查看数据发现是因为数据中包含逗号的问题,因为 csv 文件列分隔符就为逗号,所以直接导入到表中会使数据串列。

解决办法

查询资料发现是建表语句的问题,所以我们要需要在建表的时候指定列包围符号。如下:

CREATE TABLE IF NOT EXISTS test.student (

name STRING COMMENT '姓名',

age STRING COMMENT '年龄',

gender STRING COMMENT '性别',

other_info STRING COMMENT '其他信息'

)

COMMENT '学生信息表'

ROW FORMAT SERDE 'org.apache.hadoop.hive.serde2.OpenCSVSerde'

WITH SERDEPROPERTIES (

'separatorChar' = ',',

'quoteChar' = '"',

'escapeChar' = '\\'

)

STORED AS TEXTFILE;

使用 OpenCSVSerde 作为数据序列化程序,并通过 SERDEPROPERTIES 指定 separatorChar(分隔符)和 quoteChar(引号包围符号)以及 escapeChar (转义字符)的值。文章来源:https://www.toymoban.com/news/detail-675342.html

默认 csv 文件的分隔符、引号和转义字符(如果未指定)文章来源地址https://www.toymoban.com/news/detail-675342.html

DEFAULT_ESCAPE_CHARACTER \

DEFAULT_QUOTE_CHARACTER "

DEFAULT_SEPARATOR ,

到了这里,关于Hive 导入csv文件,数据中包含逗号的问题的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!