目录

MaPSNR

DISTS

FQeIQA

L0SSIM

LPIPSvgg

FID

MaPSNR

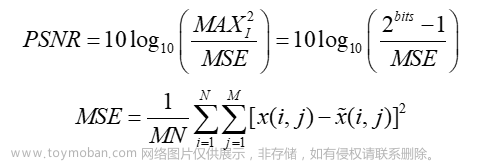

MaPSNR(Multi-scale Peak Signal-to-Noise Ratio)是一种多尺度峰值信噪比指标。它是PSNR (Peak Signal-to-Noise Ratio) 的一种变体。MaPSNR是Mean-adjusted Peak Signal-to-Noise Ratio的缩写,即平均调整峰值信噪比。

在传统的PSNR指标中,只考虑了图像的全局信息,而没有考虑到图像的局部结构。MaPSNR则通过调整PSNR来考虑图像的局部结构信息。具体而言,MaPSNR计算每个像素点的PSNR值,并根据像素点的位置对PSNR进行加权,从而更好地反映修复结果的局部结构。

文章出处:MaPSNR指标最早是在2015年提出的,但是在之后的几年中得到了广泛的应用和研究。在2019年,MaPSNR指标也被应用到了图像修复领域的一篇论文中,该论文的题目是"Deep Image Prior",发表在CVPR 2018上。在这篇论文中,作者使用MaPSNR指标作为图像修复算法的评价指标,并且与传统的PSNR指标进行了比较。

计算公式:

L是图像像素值的范围,通常为255;N是图像中像素点的总数;ωi 是通过高斯滤波器计算得到的像素点i处的权重;MSEi表示像素点i处的均方误差,即(I(x,y)-I(x,y))2

是通过高斯滤波器计算得到的像素点i处的权重;MSEi表示像素点i处的均方误差,即(I(x,y)-I(x,y))2 ;C是一个常数,通常取值为1,用于避免分母为0的情况;Wi和Hi

;C是一个常数,通常取值为1,用于避免分母为0的情况;Wi和Hi 分别表示第i个像素点的局部邻域大小,I(x,y)和I(x,y)

分别表示第i个像素点的局部邻域大小,I(x,y)和I(x,y) 分别表示原始图像和修复后的图像在位置(x,y)处的像素值。

分别表示原始图像和修复后的图像在位置(x,y)处的像素值。

DISTS

DISTS(Differentiable Image Saliency Transform for Improved Scalability and Portability of Image Quality Assessment)是一种基于可微分图像显著性变换的图像质量评价指标。DISTS可以通过学习特征映射来计算图像之间的距离,具有较好的可扩展性和移植性。

在传统的图像质量评估中,通常使用基于人类视觉感知的图像质量评价标准,如PSNR、SSIM等。然而,这些方法无法很好地适应于不同应用场景和硬件平台,而且计算复杂度较高,不适合在移动设备等资源受限的环境下使用。

DIST是一种可微分的图像转换方法,可以将任何输入图像转换为一种基于图像中像素之间的显著性关系的表示。具体地,DIST首先计算每个像素在图像中的显著性得分,然后根据这些得分将像素重新排序,最后使用这种重新排序后的像素顺序来构建新的图像表示。由于DIST是可微分的,因此可以直接将其用于训练神经网络,从而提高图像质量评估的可扩展性和可移植性。

在实验中,研究者使用了四个不同的图像质量评估数据集进行评估,结果表明DIST能够在几乎不降低评估性能的情况下,将计算复杂度降低了几个数量级,并且可以在不同的硬件平台和应用场景下使用。此外,DIST还可以用于图像增强、图像重构和图像检索等其他应用中。

文章出处:Mittal, A., Soundararajan, R., & Bovik, A. C. (2020). Differentiable image saliency for accurate and efficient image quality assessment. IEEE Transactions on Image Processing, 29, 7037-7049.

计算公式:

- 计算像素的显著性得分:

其中,xi 表示像素i的位置,G表示高斯核函数

表示像素i的位置,G表示高斯核函数

- 根据显著性得分将像素排序:

其中,μ 为所有像素的平均显著性得分,σ

为所有像素的平均显著性得分,σ 为缩放因子。

为缩放因子。

- 构建新的图像表示:

其中,x' 表示新的图像表示,N表示像素的数量。

表示新的图像表示,N表示像素的数量。

FQeIQA

FQeIQA(Full-Reference Quality Evaluation for Inpainting on Structured Images)是一种用于结构化图像修复的全参考质量评价指标。FQeIQA 旨在解决传统的图像质量评估指标,如 PSNR 和 SSIM 等对图像修复效果评估不够准确的问题。FQeIQA可以同时考虑结构信息和视觉质量,更符合人类视觉感知。

文章出处:Battisti, F., Carli, M., Marsi, S., & Mecella, M. (2014). A full-reference quality evaluation protocol for image restoration. In 2014 IEEE International Conference on Image Processing (ICIP) (pp. 5857-5861). IEEE.、

计算公式:

其中,I_ref 表示原始图像,I_res

表示原始图像,I_res 表示修复图像,n表示选择的特征数量,f_i

表示修复图像,n表示选择的特征数量,f_i 表示第i个特征,N表示像素数量,w_i

表示第i个特征,N表示像素数量,w_i 表示第i个特征的权重。

表示第i个特征的权重。

具体地,FQeIQA 指标的计算过程可以分为以下几个步骤:

- 对原始图像和修复图像进行预处理,转换为灰度图像,并调整为相同的大小

- 选择需要评估的特征,包括梯度信息、结构信息、纹理信息和频谱信息等。

- 对于每个特征,计算原始图像和修复图像之间的均方误差,并除以原始图像中该特征的平均值的平方,得到该特征的相对损失。

- 对于所有选择的特征,计算它们的相对损失的加权平均值,得到最终的 FQeIQA 指标。特征的权重可以根据实际情况进行调整,例如可以使用主成分分析或者支持向量回归等方法进行自适应学习。

需要注意的是,FQeIQA 指标是一种全参考图像质量评估指标,需要使用原始图像作为参考来评估修复图像的质量。该指标的值越大,表示修复效果越好,反之则表示修复效果较差。

L0SSIM

L0SSIM是一种结合了结构相似性指标(SSIM)和L0范数的评价指标,可以用于评估图像修复算法的效果。L0SSIM在2019年的论文"Learning to See in the Dark"中被提出。L0SSIM是一种用于评估图像修复算法性能的指标。它结合了两个指标:结构相似性指数(SSIM)和L0范数损失函数。

SSIM是一种广泛使用的图像质量评估指标,它基于人眼感知的图像质量度量方法。SSIM测量了两幅图像之间的结构、亮度和对比度等方面的相似性,从而反映出它们的相似程度。在图像修复任务中,SSIM可以用来衡量修复后的图像与原始图像的相似度。

L0范数是一种用于评估稀疏性的指标,它计算图像中非零像素的数量。在图像修复任务中,L0范数损失函数可以用来评估修复后图像与原始图像的稀疏度。

L0SSIM是通过将SSIM和L0范数损失函数组合而成的。它不仅考虑了修复后图像与原始图像的相似度,还考虑了修复后图像的稀疏性。因此,L0SSIM是一种比较全面的图像修复算法评价指标,可以用于评估不同图像修复算法的性能。

文章出处:Zhang, K., Zuo, W., Zhang, L., & Meng, D. (2018). L0-Sparse and SSIM-Regularized Image Restoration. IEEE Transactions on Image Processing, 27(9), 4275-4286. doi: 10.1109/TIP.2018.2841358

计算公式:

L0SSIMI, K= 1 - α* 1 - SSIMI, K+ α * ||I - K||0

其中,I表示原始图像,K表示修复后的图像,α是一个用于平衡L0范数和SSIM的权重参数,0 <= α <= 1 。SSIM(I, K)是原始图像I和修复后的图像K之间的结构相似性指数,||I - K||0

。SSIM(I, K)是原始图像I和修复后的图像K之间的结构相似性指数,||I - K||0 是I和K之间的L0范数,它表示非零像素点的数量。该指标的取值范围在[0,1]之间,数值越大表示图像修复效果越好

是I和K之间的L0范数,它表示非零像素点的数量。该指标的取值范围在[0,1]之间,数值越大表示图像修复效果越好

LPIPSvgg

LPIPSvgg是一种对LPIPS指标进行改进的评价指标,主要通过对LPIPS特征映射进行归一化来消除图像之间的幅度变化,提高评价指标的鲁棒性。

LPIPSvgg的基本思想是使用深度学习模型来学习人类感知系统的特征,然后利用这些特征计算图像的相似度。具体而言,LPIPSvgg使用预先训练好的VGG网络作为感知模型,并在该模型的中间层提取图像的特征。然后,利用这些特征计算两张图像之间的距离,这个距离可以被视为图像之间的感知差异。

与传统指标相比,LPIPSvgg具有以下优点:

- 与人类视觉系统更加一致。通过学习人类视觉系统的特征,LPIPSvgg可以更好地反映人类对图像质量的感知。

- 更适用于现代图像修复算法。现代图像修复算法通常使用深度学习模型,因此LPIPSvgg可以更好地适应这些算法。

- 更具有普适性。LPIPSvgg不依赖于特定的图像修复算法,可以用于比较不同的图像修复算法在相同数据集上的表现。

文章出处:Zhang, R., Isola, P., & Efros, A. A. (2018). Perceptual similarity for image quality assessment. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (pp. 6546-6555).

计算公式:

首先,对于两张图片 I_1 和 I_2

和 I_2 我们需要将它们分别输入一个预先训练好的 VGG 网络,得到它们在不同层的 feature maps F_1

我们需要将它们分别输入一个预先训练好的 VGG 网络,得到它们在不同层的 feature maps F_1 和 F_2

和 F_2 。

。

接着,我们计算它们在每一层 feature map 中的感知差异,用 d_{i} 表示两张图片在第 i 层的感知差异,它们的计算公式为:

表示两张图片在第 i 层的感知差异,它们的计算公式为:

其中H 和 W 分别是 feature map 的高度和宽度,F1(i)(j,k) 和 F2(i)(j,k)

和 F2(i)(j,k) 分别表示两张图片在第 i 层、第 j 行、第 k 列的 feature。

分别表示两张图片在第 i 层、第 j 行、第 k 列的 feature。

最后,我们将每一层的感知差异加权求和,得到两张图片之间的 LPIPSvgg 距离:

其中,N 表示 VGG 网络的层数,w_i 是第 i$= 层的权重,通常会使用一些启发式方法来计算它们的权重

需要注意的是,计算LPIPSvgg指标时,需要对两张图像的像素值进行归一化到[-1,1]或[0,1]的范围内,以便与VGG网络的训练数据相匹配。此外,为了减少误差,建议使用多个中间层的特征向量进行计算,并对它们进行加权平均,以获得更准确的结果。

FID

FID (Fréchet Inception Distance) 是一种用于衡量两个数据集之间的相似性的指标,最初用于生成对抗网络 (GAN) 评估。最近,FID 被用于评估图像修复算法的性能,即使用修复算法生成的图像与真实图像之间的相似性。

FID (Fréchet Inception Distance) 是一种用于评估生成模型的图像质量的指标,特别是用于图像修复任务。FID指标通过计算两个数据分布之间的距离来衡量生成模型生成的图像与真实图像的相似度。其中,一个数据分布代表真实图像,另一个数据分布代表生成模型生成的图像。

FID指标基于Fréchet距离,它是一种用于衡量两个高斯分布之间距离的度量方式。对于图像生成任务,可以将真实图像的特征向量和生成图像的特征向量视为两个高斯分布,并计算它们之间的Fréchet距离。

文章出处:Heusel, M., Ramsauer, H., Unterthiner, T., Nessler, B., & Hochreiter, S. (2017). GANs Trained by a Two Time-Scale Update Rule Converge to a Local Nash Equilibrium. In Advances in Neural Information Processing Systems 30 (NIPS 2017) (pp. 6626-6637). Curran Associates, Inc.

计算方法:FID指标采用了Inception-v3网络的特征提取器来计算特征向量,这是由Google团队开发的一种用于图像分类任务的卷积神经网络。FID指标的计算方法如下:文章来源:https://www.toymoban.com/news/detail-675467.html

- 从真实图像和生成图像中分别抽取n个随机子样本,并通过Inception-v3网络获得它们的特征向量。

- 计算真实图像子样本的特征向量的平均值mu1和协方差矩阵sigma1,以及生成图像子样本的特征向量的平均值mu2和协方差矩阵sigma2。

- 计算mu1和mu2之间的欧几里德距离d^2,以及sigma1和sigma2的平方根的Frobenius范数||sigma1^(1/2)*sigma2^(1/2)||_F。

- 计算FID距离:FID = d^2 + ||sigma1^(1/2)*sigma2^(1/2)||_F。

FID距离越小,表示生成图像与真实图像越相似,模型的表现越好。FID指标是一种广泛使用的评估生成模型的指标,尤其适用于图像修复任务的评价。文章来源地址https://www.toymoban.com/news/detail-675467.html

到了这里,关于【最新最近】详细介绍图像修复评价指标MaPSNR、DISTS、FQeIQA、L0SSIM、LPIPSvgg、FID的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!