介绍

SARSA(State-Action-Reward-State-Action)是一种强化学习算法,用于解决马尔可夫决策过程(MDP)中的问题。SARSA算法属于基于值的强化学习算法,用于学习最优策略。

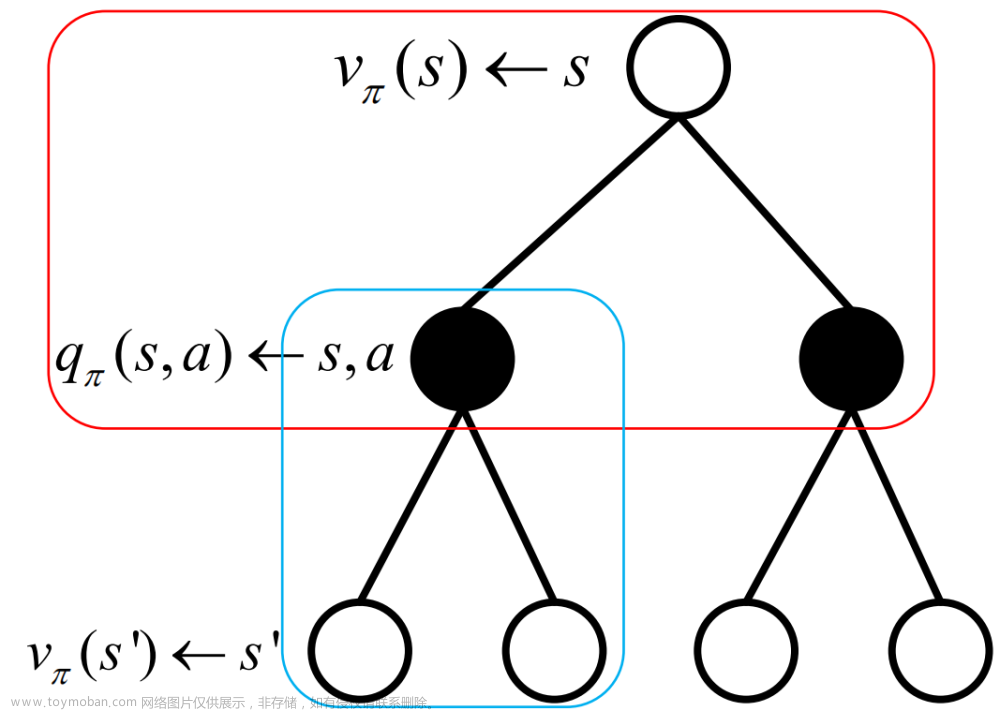

在SARSA算法中,智能体通过与环境进行交互来学习。它基于当前状态、选择的动作、获得的奖励、下一个状态和下一个动作来更新价值函数(或者动作值函数),并根据更新后的价值函数选择下一个动作。

SARSA算法的更新规则如下:

Q(s, a) = Q(s, a) + α * (r(s,a,s’) + γ * Q(s’, a’) - Q(s, a))

其中,Q(s, a) 表示在状态 s 执行动作 a 的动作值函数,α 是学习率,r 是即时奖励,γ 是折扣因子,s’ 是下一个状态,a’ 是在下一个状态下选择的动作。

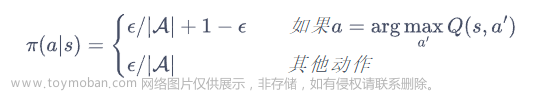

SARSA算法的核心思想是根据当前策略进行动作选择,并根据选择的动作和环境的反馈进行更新。它使用一种称为ε-greedy策略的方法,即以ε的概率选择一个随机动作,以1-ε的概率选择当前最优的动作。这样可以在探索和利用之间进行权衡,有助于智能体探索新的状态和动作,并最终学习到最优策略。

SARSA算法的步骤如下:

- 初始化动作值函数 Q(s, a) 为任意值;

- 选择初始状态 s;

- 根据当前策略选择动作 a;

- 执行动作 a,观察下一个状态 s’ 和即时奖励 r;

- 根据当前策略选择下一个动作 a’;

- 更新动作值函数:Q(s, a) = Q(s, a) + α * (r + γ * Q(s’, a’) - Q(s, a));

- 将状态更新为下一个状态:s = s’;

- 将动作更新为下一个动作:a = a’;

- 重复步骤3到8,直到达到终止状态。

通过不断与环境交互和更新动作值函数,SARSA算法能够逐步学习到最优策略,并在最优策略下获得最大的累积奖励。

示例代码

以下是一个简单的示例代码,演示了如何使用SARSA算法来解决一个简单的强化学习问题:文章来源:https://www.toymoban.com/news/detail-675514.html

import numpy as np

# 定义环境

num_states = 5

num_actions = 3

Q = np.zeros((num_states, num_actions)) # 动作值函数

rewards = np.array([[-1, 0, -1], # 状态0的奖励表

[-1, -1, 0], # 状态1的奖励表

[0, -1, -1], # 状态2的奖励表

[-1, 0, -1], # 状态3的奖励表

[-1, -1, 0]]) # 状态4的奖励表

gamma = 0.8 # 折扣因子

alpha = 0.1 # 学习率

epsilon = 0.1 # ε-greedy策略的ε值

# 定义SARSA算法

def sarsa(num_episodes):

for episode in range(num_episodes):

state = 0 # 初始状态

action = epsilon_greedy(state) # 初始动作

while state != num_states - 1: # 直到达到终止状态

next_state = action # 下一个状态为当前动作

next_action = epsilon_greedy(next_state) # 下一个动作

# 使用SARSA更新动作值函数

Q[state, action] += alpha * (rewards[state, action] + gamma * Q[next_state, next_action] - Q[state, action])

state = next_state

action = next_action

# ε-greedy策略

def epsilon_greedy(state):

if np.random.uniform(0, 1) < epsilon:

action = np.random.randint(num_actions) # 随机选择一个动作

else:

action = np.argmax(Q[state]) # 选择具有最大动作值的动作

return action

# 运行SARSA算法

sarsa(num_episodes=100)

# 输出结果

print("最优动作值函数:")

print(Q)

这个示例代码是一个简单的强化学习问题,具有5个状态和3个动作。在每个状态下,根据rewards矩阵给出的即时奖励,智能体通过SARSA算法逐步更新动作值函数Q。最后,输出最优的动作值函数Q。文章来源地址https://www.toymoban.com/news/detail-675514.html

到了这里,关于强化学习系列--时序差分学习方法(SARSA算法)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![强化学习基础篇[2]:SARSA、Q-learning算法简介、应用举例、优缺点分析](https://imgs.yssmx.com/Uploads/2024/02/468458-1.jpeg)