【Python学习笔记】记载解决Python报错HTTP Error 403: Forbidden的一波三折过程

当前进度:还没有解决,但是已经尝试了好几种办法,此处做个记录,也许能帮上忙。

本帖是整理回顾帖,不是教程帖,追求一个完美无缺必拿下答案的码友现在可以退出了。

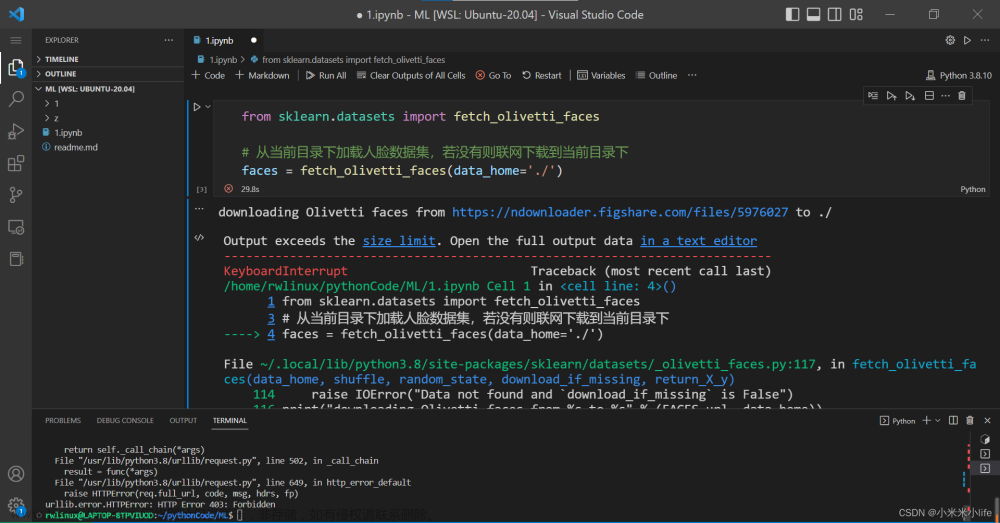

在跟网课老师敲代码的时候,加载sklearn新闻数据集fetch_20newsgroups()的时候,出错,报错HTTP Error 403: Forbidden。

(我看的网课链接:https://www.bilibili.com/video/BV1e14y1G7gC/?p=68&spm_id_from=pageDriver&vd_source=cdfd0a0810bcc0bcdbcf373dafdf6a82

个人认为是比较适合小白的人工智能入门教程

用到这个数据集的地方是第68p,10 数据集介绍)

经过多方搜索以后目前查到以下解决办法:

一、修改源代码文件

按照如下几个教程贴的步骤来即可,大致内容都差不多,个别代码多个一句两句,比如下面这段,不是每个教程都有:

https://blog.csdn.net/weixin_43656359/article/details/103758027?spm=1001.2014.3001.5506

教程帖子1(推荐,有源代码可复制)

https://blog.csdn.net/xiaotian127/article/details/86836571?spm=1001.2101.3001.6650.6&utm_medium=distribute.pc_relevant.none-task-blog-2%7Edefault%7EBlogCommendFromBaidu%7ERate-6-86836571-blog-128920936.235%5Ev38%5Epc_relevant_sort_base1&depth_1-utm_source=distribute.pc_relevant.none-task-blog-2%7Edefault%7EBlogCommendFromBaidu%7ERate-6-86836571-blog-128920936.235%5Ev38%5Epc_relevant_sort_base1&utm_relevant_index=7

教程帖子2

https://blog.csdn.net/weixin_45510412/article/details/128558799?spm=1001.2101.3001.6650.2&utm_medium=distribute.pc_relevant.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-2-128558799-blog-103758027.235%5Ev38%5Epc_relevant_sort_base1&depth_1-utm_source=distribute.pc_relevant.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-2-128558799-blog-103758027.235%5Ev38%5Epc_relevant_sort_base1&utm_relevant_index=5

教程帖子3

这个方法根据这几个评论区帖子的反馈都很有效,但我就是不行,我也很奇怪。之前为了将原神模型导入Unity的时候下了subline Text(现在都还记得应该改哪一串代码让Unity别报错,哈哈)

下面是MMD的改代码界面,顺带提一句免得忘了

但是我按照教程改了这个python代码以后并没有解决问题:

然后我就去换了方法二

二、氪金买专栏

CSDN有一位大佬的付费专栏提供解决方法,评论区反响很好

https://blog.csdn.net/weixin_43178406/article/details/128920936#comments_27735247

土豪请随意

但是我按这个脚本复制运行以后,确实下载了数据集,但是还是不能正常运行。

目前报错Unexpected exception formatting exception. Falling back to standard exception,我百度以后还没弄明白是怎么回事,把可能惹祸的Print注释掉也没用。

https://www.5axxw.com/questions/simple/irn34y

答疑网页

20230723二次编辑:

我对比以后发现网课老师和写专栏的这位老师的调用方式有所不同,我试了专栏老师的调用方式,现在可以正常读出数据集了:

图片分割线,果然氪金的就是靠谱啊……

解决这个数据集读入问题以后,print查看的时候还遇到一个小报错IOPub data rate exceeded,我搜了个解决方案:

https://blog.csdn.net/xucanlax/article/details/124462706

IOPub data rate exceeded

我亲自试了以后还是显示一样的内容,无所谓了……

**

三:本地下载

**

我找到几个教程帖,还是没有起作用。

1.

https://blog.csdn.net/m0_55196097/article/details/127839231?spm=1001.2014.3001.5506

重建dns缓存

我按照这个帖子的说法重建了dns缓存,也成功了,但一运行还是报错HTTP Error 403: Forbidden

2.

https://blog.csdn.net/weixin_45510412/article/details/128558799?spm=1001.2101.3001.6650.2&utm_medium=distribute.pc_relevant.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-2-128558799-blog-103758027.235%5Ev38%5Epc_relevant_sort_base1&depth_1-utm_source=distribute.pc_relevant.none-task-blog-2%7Edefault%7ECTRLIST%7ERate-2-128558799-blog-103758027.235%5Ev38%5Epc_relevant_sort_base1&utm_relevant_index=5

另一个帖子

3.

还有处理一个相似数据集的帖子,我看和我这个数据集不一样,就没有实操:

https://blog.csdn.net/m0_60465900/article/details/129748445?spm=1001.2014.3001.5506

lfw数据集

**

四:修改user agent

**

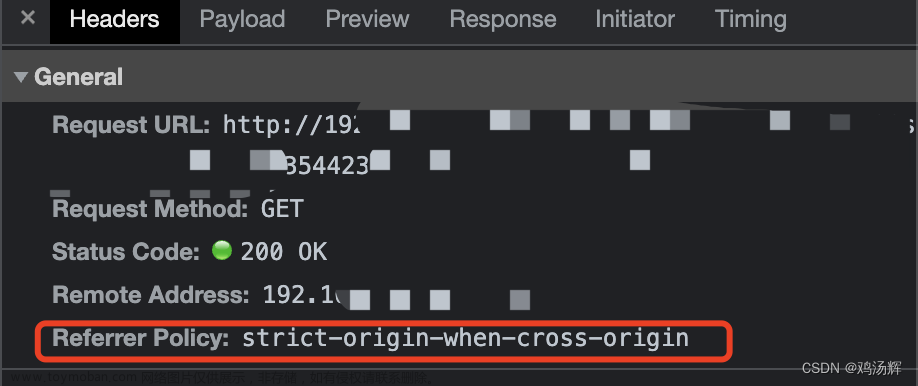

上网搜HTTP Error 403: Forbidden报错的时候有帖子说是爬虫引起的,需要改user agent。我是chrome浏览器,就需要搜一下对应的chrome浏览器怎么操作。

我搜了很多帖子,但还是没太明白怎么弄,找到检查以后的Network目录以后就卡住了,改桌面快捷方式的属性似乎也不对。

https://blog.csdn.net/qq_33218097/article/details/129783677

修改chrome浏览器属性

1.

**文章来源:https://www.toymoban.com/news/detail-678502.html

**

https://www.cnblogs.com/blueteer/p/16013249.html

在header请求中添加User-agent信息

鉴于我还不是太明白这块,我上万能的b站找了个爬虫知识相关的网课,打算学习一下再试。

https://www.bilibili.com/video/BV17K411G7sY/?spm_id_from=333.337.search-card.all.click&vd_source=cdfd0a0810bcc0bcdbcf373dafdf6a82

python爬虫必备知识点,代理请求数据

我觉得一般人应该到不了我这步,我属于是环境装得比较混乱才容易一波三折,上面那么多方法普通人最多试2个应该就解决了。

20230723:课程第一遍看完了,对于没有接触过爬虫的人来说是很好的入门教程,但是直接就一步到位到能爬数据集我觉得我还是做不到那个程度。我打算跟着教程再看一遍照着写代码,然后在搞懂这个视频的代码的基础上类比其他帖子和教程的内容继续学习。

第二遍看完以后,我还是不太会实操,从学习到实践还是有一定差距。文章来源地址https://www.toymoban.com/news/detail-678502.html

到了这里,关于【Python学习笔记】记载解决Python报错HTTP Error 403: Forbidden的一波三折过程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[Python3]爬虫HTTP Error 500错误,报错信息:urllib.error.HTTPError: HTTP Error 500: INTERNAL SERVER ERROR](https://imgs.yssmx.com/Uploads/2024/02/593027-1.png)