论文简介

-

作者

Huiqiang Xie

Zhijin Qin

Geoffrey Ye Liy

Biing-Hwang Juangy -

发表期刊or会议

《GLOBECOM》 -

发表时间

2020.12

动机:为什么作者想要解决这个问题?

随着新应用的发展,需要开发新的通信系统以提高通信的准确性和效率,作者通过考虑bit背后的语义来开发智能通信系统

文中对语义通信系统的解释:

所考虑的语义通信系统主要关注语义层面的信源编码和信道编码,其目的是提取数字比特背后的语义信息,而不是简单地压缩比特序列的长度,然后对语义信息进行编码,以确保接收者可以在失真后恢复原始语义信息

(即使提取出来bit背后的语义信息,还是要对语义信息编码,这不还是在传输bit吗,一定意义上确实不是简单的压缩了,是复杂的压缩,hhhh……)

贡献:作者在这篇论文中完成了什么工作(创新点)?

- 基于 Transformer提出了一种新颖的 DeepSC 框架,可以有效地从文本中提取语义信息。在该框架中,设计了

联合语义-信道编码来应对信道噪声和语义失真 - DeepSC的收发器由语义编码器、信道编码器、信道解码器和语义解码器组成。为了理解语义并同时最大化系统容量,接收器使用两个损失函数进行优化:交叉熵和互信息

说白了,就是设计一个网络,再设计损失函数的套路;换个网络岂不是又是创新了

规划:他们如何完成工作?

-

整体框架

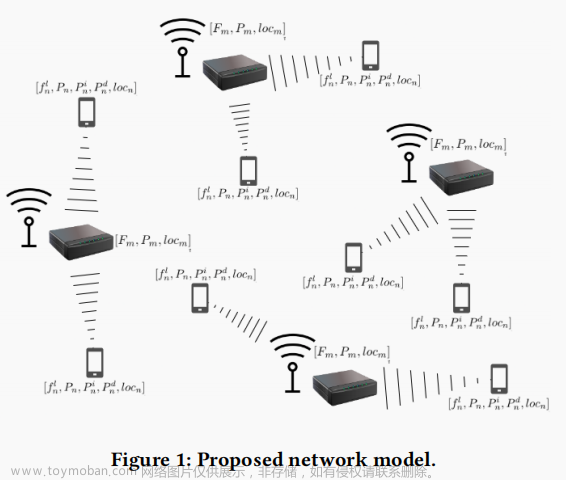

所考虑的系统模型由两个层次组成:语义层和传输层。语义层解决语义信息处理的编码和解码以提取语义信息;传输层保证语义信息能够在传输介质上正确交换。

(语义层,虚线框里;传输层,虚线框外;这个semantic channel是抽象出来的概念吧)

重要知识点:

对于编码器和解码器的端到端训练,信道必须允许反向传播。物理信道可以通过神经网络来建模。例如,简单的神经网络可用于对加性高斯白噪声 (AWGN) 信道、乘性高斯噪声信道和擦除信道进行建模。而对于衰落通道,则需要更复杂的神经网络。在本文中,为了简单起见,我们主要考虑 AWGN 信道。 -

神经网络框架

本文的框架有两个技术需要关注:

- 使用 DNN 联合设计发射器和接收器

通过在DL中采用自动编码器结构,将E2E系统中的发送器和接收器作为E2E重建任务进行联合优化 - 语义-信道联合编码

为了实现语义级别的成功恢复,我们联合设计了语义和信道编码,以保持 s ^ \hat s s^和 s s s之间的含义不变,这是通过新的 DNN 框架实现的

(语义-信道联合编码的意义就是为了保持 s ^ \hat s s^和 s s s之间的含义不变)

[个人理解,这两项技术是通过设计不同的loss函数实现的]

看一下神经网络的整体框架:

发射机由语义编码器和信道编码器组成,语义编码器用于从要传输的文本中提取语义特征,信道编码器用于生成符号以方便后续传输。语义编码器包括多个Transformer编码器层,信道编码器使用不同的全连接层;

AWGN 信道被解释为模型中的一层;

DeepSC 接收器将用于符号检测的信道解码器和用于文本估计的语义解码器组合在一起。信道解码器具有不同全连接层,语义解码器包括多个 Transformer 解码器层。

损失函数定义为: L total = L C E ( s , s ^ ; α , β , χ , δ ) + λ L M I ( X , Y ; T , α , β ) \mathcal{L}_{\text {total }}=\mathcal{L}_{\mathrm{CE}}(\mathbf{s}, \hat{\mathbf{s}} ; \boldsymbol{\alpha}, \boldsymbol{\beta}, \boldsymbol{\chi}, \boldsymbol{\delta})+\lambda \mathcal{L}_{\mathrm{MI}}(\mathbf{X}, \mathbf{Y} ; T, \boldsymbol{\alpha}, \boldsymbol{\beta}) Ltotal =LCE(s,s^;α,β,χ,δ)+λLMI(X,Y;T,α,β)

其中第一项是考虑句子相似性的损失函数,其目的是通过训练整个系统来最小化 s ^ \hat s s^和 s s s之间的语义差异(也就是语义-信道联合编码的loss,语义-信道联合编码面向的好像是整个通信过程)。第二个是互信息的损失函数,它最大化发射机训练期间实现的数据速率(也就是联合设计发射器和接收器的loss,联合设计发射器和接收器是X→channel→Y这一段)。

关于 L C E \mathcal{L}_{\mathrm{CE}} LCE和 L total \mathcal{L}_{\text {total }} Ltotal 具体介绍见论文II.A和II.B接下来我们要进行网络的训练:

由于损失函数不同,DeepSC 的训练过程分为两个阶段。

第一阶段是通过无监督学习训练互信息模型,损失函数为 L M I \mathcal{L}_{\mathrm{MI}} LMI,即联合优化发射器和接收器

第二阶段是以 L total \mathcal{L}_{\text {total }} Ltotal 为损失函数来训练整个系统( L C E \mathcal{L}_{\mathrm{CE}} LCE包含在 L total \mathcal{L}_{\text {total }} Ltotal 中,所以此过程也优化了语义-信道联合编码,猜测:之所以不把 L C E \mathcal{L}_{\mathrm{CE}} LCE单独拎出来作为loss训练,是因为 L total \mathcal{L}_{\text {total }} Ltotal 作为损失函数效果更好)

关于训练的具体流程,见论文III.A和III.B - 使用 DNN 联合设计发射器和接收器

理由:通过什么实验验证它们的工作结果

关于如何进行对比试验,具体见 论文 IV文章来源:https://www.toymoban.com/news/detail-679009.html

自己的看法

语义通信较为早期的文章,并未对语义做具体的解释,通读文章后,给人的感觉语通信就是用神经网络咔咔组合,什么语义-信道联合编码,什么联合设计收发器,就是神经网络。文章来源地址https://www.toymoban.com/news/detail-679009.html

到了这里,关于文献阅读:Deep Learning based Semantic Communications: An Initial Investigation的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!