目录

实现方案

1. 确定目标新闻源:

2. 确定关键词:

3. 使用网络爬虫获取新闻内容:

4. 提取和分析新闻文章:

5. 追踪新闻事件的发展进程:

6. 监测舆论反映:

7. 数据可视化:

完整代码示例

注意事项

1. 网站使用政策和合规性:

2. 网页解析和数据提取:

3. 爬虫频率和数据量:

4. API使用和限制:

5. 数据处理和存储:

6. 代码健壮性和异常处理:

7. 隐私和版权问题:

总结

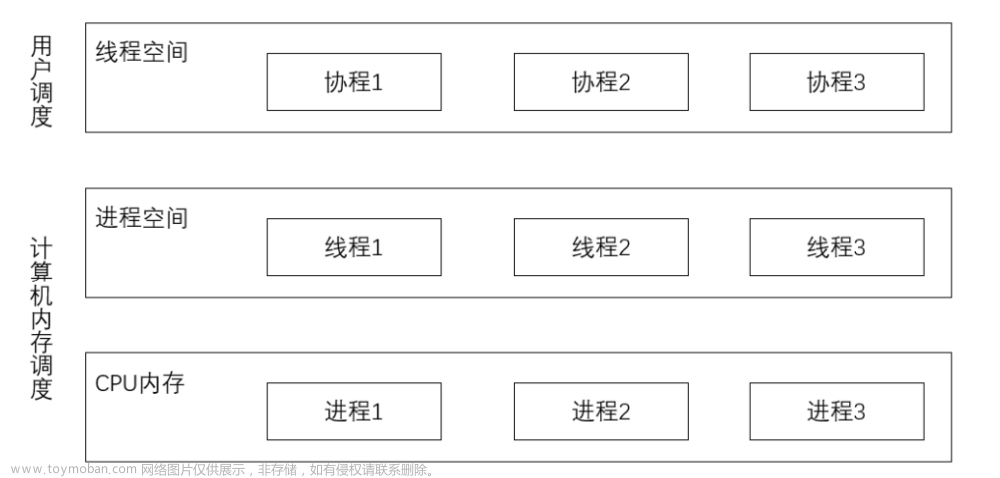

追踪新闻事件的发展进程和舆论反映对于我们了解时事动态和公众情绪至关重要。而借助Python爬虫和情感分析等技术,我们可以更高效地获取新闻内容、分析情感倾向,并了解舆论反应。那么如何使用Python来实现这一追踪新闻事件和舆论反映呢?

实现方案

要实现Python爬虫追踪新闻事件发展进程以及舆论反映,以下是一个可能的实现方案:

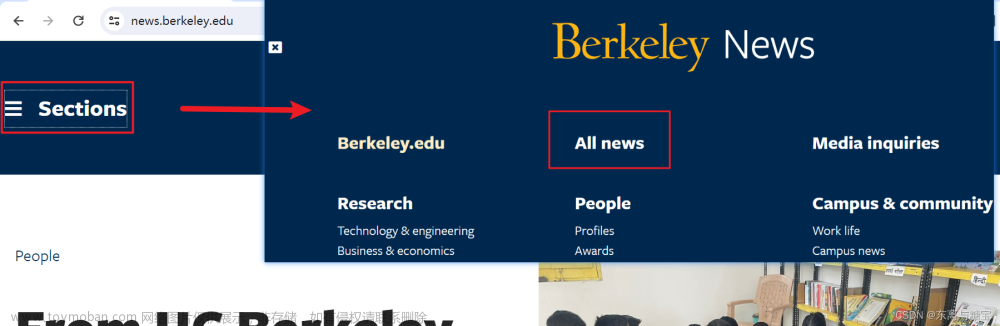

1. 确定目标新闻源:

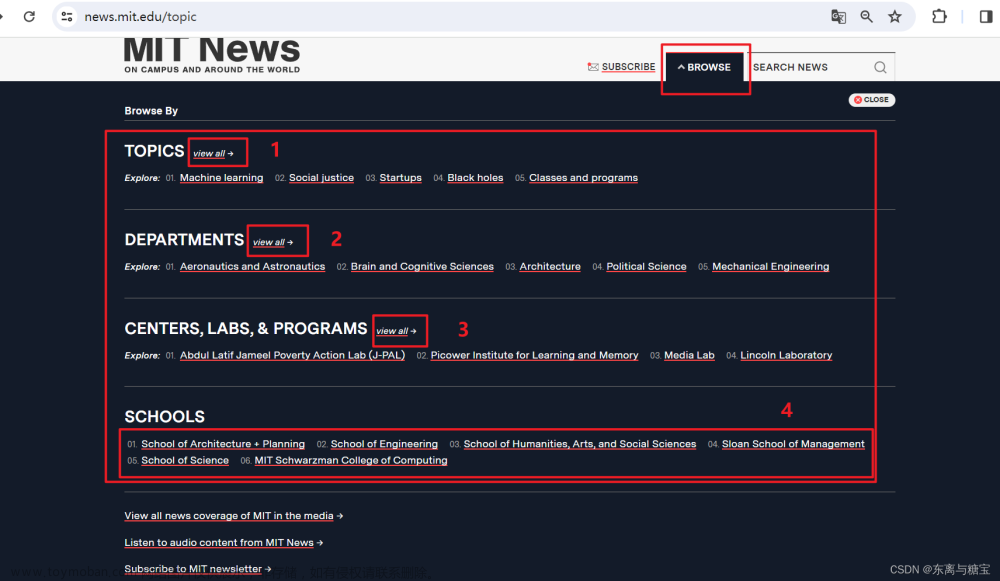

首先,你需要确定要追踪的新闻源。可以选择多个新闻网站、社交媒体平台和论坛等,以获取全面的信息。

target_news_sources = ['https://example.com/news', 'https://example2.com/news']

2. 确定关键词:

通过确定关键词或短语,来过滤和识别与特定事件相关的新闻和舆论。这些关键词应该是与事件相关、经常出现的关键词。

keywords = ['事件1', '舆论反映', '关键词']

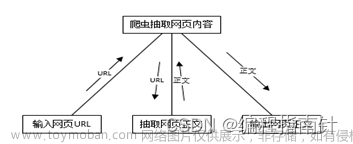

3. 使用网络爬虫获取新闻内容:

使用Python的爬虫库(例如BeautifulSoup或Scrapy)来抓取新闻站点上与关键词相关的新闻文章。可以查找标题、正文、标签等部分以获取新闻内容。

import requests

from bs4 import BeautifulSoup

def crawl_news_content(url):

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 根据页面结构,提取新闻标题、正文等信息

title = soup.find('h1').get_text()

content = soup.find('div', class_='article-content').get_text()

# 返回提取的新闻内容

return {

'title': title,

'content': content

}

news_content = []

for news_url in target_news_sources:

news_content.append(crawl_news_content(news_url))4. 提取和分析新闻文章:

对于每一篇抓取到的新闻文章,使用自然语言处理工具(例如NLTK或spaCy)来提取关键信息,如日期、标题、作者、摘要等。可以使用机器学习技术进行情感分析,识别舆论反映的情感倾向。

import nltk

from nltk.sentiment.vader import SentimentIntensityAnalyzer

nltk.download('vader_lexicon')

sia = SentimentIntensityAnalyzer()

def analyze_news_sentiment(news_content):

sentiment_scores = []

for news in news_content:

title = news['title']

text = news['content']

sentiment_score = sia.polarity_scores(text)

sentiment_scores.append({

'title': title,

'sentiment_score': sentiment_score

})

return sentiment_scores

news_sentiment_scores = analyze_news_sentiment(news_content)5. 追踪新闻事件的发展进程:

通过时间戳或日期,对抓取到的新闻进行排序和追踪,以了解事件的发展进程。可以将事件按照时间顺序显示,并提供关键信息的汇总,如新闻标题、链接、发布时间等。

sorted_news_content = sorted(news_content, key=lambda x: x['publish_time'])

for news in sorted_news_content:

title = news['title']

publish_time = news['publish_time']

print(f"新闻标题:{title}")

print(f"发布时间:{publish_time}")

print("---------------------------")6. 监测舆论反映:

分析抓取到的新闻中的评论、社交媒体上的讨论以及相关论坛等舆论渠道,跟踪和监测舆论反映,可以使用文本分类和聚类等技术来归纳和总结舆论的观点。

import tweepy

def monitor_public_opinion(keyword):

consumer_key = "your-consumer-key"

consumer_secret = "your-consumer-secret"

access_token = "your-access-token"

access_token_secret = "your-access-token-secret"

auth = tweepy.OAuthHandler(consumer_key, consumer_secret)

auth.set_access_token(access_token, access_token_secret)

api = tweepy.API(auth)

tweets = api.search(q=keyword, tweet_mode='extended', count=10)

opinions = []

for tweet in tweets:

opinions.append(tweet.full_text)

return opinions

public_opinions = monitor_public_opinion(keywords[0])7. 数据可视化:

为了更好地展示新闻事件的发展进程和舆论反映,可以使用Python中的数据可视化库(如Matplotlib或Plotly)来创建图表和可视化仪表板。

import matplotlib.pyplot as plt

def visualize_sentiment_scores(sentiment_scores):

titles = [score['title'] for score in sentiment_scores]

scores = [score['sentiment_score']['compound'] for score in sentiment_scores]

plt.figure(figsize=(10, 6))

plt.bar(titles, scores)

plt.xlabel('新闻标题')

plt.ylabel('情感分数')

plt.xticks(rotation=90)

plt.title('新闻情感分析')

plt.show()

visualize_sentiment_scores(news_sentiment_scores)需要注意的是,爬取网站信息和处理舆论有时会有一些法律和道德问题。在进行爬虫活动时,请确保遵守相关法律法规和网站的使用条款,并确保不会侵犯他人的隐私或采用恶意手段进行爬取操作。

完整代码示例

以下是一个完整的代码示例,展示了如何使用Python爬虫追踪新闻事件发展进程及舆论反映的实现。请注意,这只是一个基本示例,实际应用中可能需要根据具体情况进行优化和扩展。

import requests

from bs4 import BeautifulSoup

import nltk

from nltk.sentiment.vader import SentimentIntensityAnalyzer

import tweepy

import matplotlib.pyplot as plt

# Step 1: 确定目标新闻源

target_news_sources = ['https://example.com/news', 'https://example2.com/news']

# Step 2: 确定关键词

keywords = ['事件1', '舆论反映', '关键词']

# Step 3: 使用网络爬虫获取新闻内容

def crawl_news_content(url):

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 根据页面结构,提取新闻标题、正文等信息

title = soup.find('h1').get_text()

content = soup.find('div', class_='article-content').get_text()

# 返回提取的新闻内容

return {

'title': title,

'content': content

}

news_content = []

for news_url in target_news_sources:

news_content.append(crawl_news_content(news_url))

# Step 4: 提取和分析新闻文章

nltk.download('vader_lexicon')

sia = SentimentIntensityAnalyzer()

def analyze_news_sentiment(news_content):

sentiment_scores = []

for news in news_content:

title = news['title']

text = news['content']

sentiment_score = sia.polarity_scores(text)

sentiment_scores.append({

'title': title,

'sentiment_score': sentiment_score

})

return sentiment_scores

news_sentiment_scores = analyze_news_sentiment(news_content)

# Step 5: 追踪新闻事件的发展进程

sorted_news_content = sorted(news_content, key=lambda x: x['publish_time'])

for news in sorted_news_content:

title = news['title']

publish_time = news['publish_time']

print(f"新闻标题:{title}")

print(f"发布时间:{publish_time}")

print("---------------------------")

# Step 6: 监测舆论反映

def monitor_public_opinion(keyword):

consumer_key = "your-consumer-key"

consumer_secret = "your-consumer-secret"

access_token = "your-access-token"

access_token_secret = "your-access-token-secret"

auth = tweepy.OAuthHandler(consumer_key, consumer_secret)

auth.set_access_token(access_token, access_token_secret)

api = tweepy.API(auth)

tweets = api.search(q=keyword, tweet_mode='extended', count=10)

opinions = []

for tweet in tweets:

opinions.append(tweet.full_text)

return opinions

public_opinions = monitor_public_opinion(keywords[0])

# Step 7: 数据可视化

def visualize_sentiment_scores(sentiment_scores):

titles = [score['title'] for score in sentiment_scores]

scores = [score['sentiment_score']['compound'] for score in sentiment_scores]

plt.figure(figsize=(10, 6))

plt.bar(titles, scores)

plt.xlabel('新闻标题')

plt.ylabel('情感分数')

plt.xticks(rotation=90)

plt.title('新闻情感分析')

plt.show()

visualize_sentiment_scores(news_sentiment_scores)请注意,在实际应用中,需要根据具体网站的结构和数据源的不同,修改和优化爬取、数据分析、舆论监测和数据可视化等部分的代码。此外,还需要注意网站的使用政策、爬虫的合规性以及API的限制等问题。

注意事项

在使用Python爬虫追踪新闻事件和舆论反映时,有一些需要注意的地方如下:

1. 网站使用政策和合规性:

在爬取新闻网站数据之前,需要了解网站的使用政策,确保你的爬虫行为符合法律法规和网站的规定。有些网站可能会对爬虫行为进行限制或禁止。

2. 网页解析和数据提取:

根据目标网站的页面结构,使用适当的解析库(如BeautifulSoup)来解析HTML或XML,并提取所需的数据。注意不同网站的结构可能会有所不同,需要根据实际情况进行相应的处理。

3. 爬虫频率和数据量:

合理控制爬虫的频率,避免给网站带来很大的访问负荷。同时,注意合理限制数据的爬取数量,避免过度请求资源。

4. API使用和限制:

如果使用Twitter API等服务,一定要遵守API提供商的使用政策和限制,不要超过访问频率限制并且遵循其他相关限制。

5. 数据处理和存储:

根据实际需求,合理处理和存储爬取到的数据。可能需要对数据进行清洗、去重、去噪等处理,也可以选择将数据存储在数据库或文件中进行后续分析和使用。

6. 代码健壮性和异常处理:

尽量编写健壮的代码,处理可能的异常情况,如网络连接失败、页面结构发生变化等。适当添加异常处理机制,确保程序的稳定性和可靠性。

7. 隐私和版权问题:

新闻和舆论数据可能涉及个人隐私和版权问题。在使用和处理数据时,需要遵守相关法律法规,尊重他人的隐私和知识产权。

以上只是一些常见的注意事项,具体情况可能因应用场景和数据源的不同而有所差异。在实际使用中,建议仔细阅读相关网站的使用政策和合规要求,遵循法律法规,并确保你的爬虫行为符合伦理和道德规范。文章来源:https://www.toymoban.com/news/detail-679061.html

总结

通过爬取新闻网站、分析情感倾向以及监测社交媒体等步骤,我们能够更全面地了解事件发展和公众情绪。同时,我们也提到了一些需要注意的地方,如合规性、数据处理和隐私等问题。希望这个示例能提供一个起点,激发更多的创意和思考,以应用于实际的情景中。掌握这些技术,可以帮助我们更好地把握时事动态,了解公众声音,从而更好地做出决策和行动。文章来源地址https://www.toymoban.com/news/detail-679061.html

到了这里,关于Python爬虫追踪新闻事件发展进程及舆论反映的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!