前言

最近有一点点爬虫需求,想总结一下scrapy框架的一些基本使用方法,加深印象,自己一直习惯使用一些脚本文件运行爬虫,面对数据量非常大,稳定性要求比较高的,效率需求比较高的情况下还是用scrapy较为合适,scrapy是一个异步的框架,所有的请求都是阻塞的,虽然在单文件脚本中也可以实现,但是代码就非常的难看,难以维护,过了几天就会忘记复杂的流程,调试起来就非常的困难,scrapy我自己用得也不多,但是觉得它非常地优秀,有成熟的中间件支持,方便的下载器,稳定性效率非常地高,但是其中的运行流程也稍微有些复杂,难以理解,异步框架处理BUG调试非常的麻烦。

初始化scrapy

首选需要安装scrapy 和selenium框架。

pip install scrapy

pip install selenium初始化框架

scrapy startproject testSpider

依据参考接着进入文件夹,新建爬虫文件。

cd testSpider

scrapy genspider myspider example.com看看目录

selenium基本使用

selenium前言

今天只讲selenium的基本使用,scrapy框架的流程后面再总结,为什么要在在scrapy中使用selenium,因为有些目标站点的接口是通过分析非常难以复现的,通常会有一些混淆参数导致出现请求遇到拦截的情况,也就是碰到反爬虫措施了,需要分析Javascript代码,分析其中参数的意思,这种过程非常的复杂,工程量非常大,这也是目前高级爬虫的必备知识,需要一些Javascript逆向知识,例如行业中有非常著名的瑞数信息做了翻盘是属于顶尖的存在,专门在一些金融,政府网站上使用这种Javascript代码混淆技术,自己也是稍微了解了一点点。

通过selenium可以绕过一些关键的有反扒的接口,得到一些重要的信息。通常的情况就是使用selenium模拟有反爬措施的登录接口从而得到登录后cookie,然后登陆过后的接口就没有反爬措施。

下载驱动

使用selenium就需要配套的浏览器驱动。我配套的浏览器就是chrome,我自己的浏览器版本。

下载的版本:

然后我把浏览器驱动放在浏览器的目录,然后配置了环境变量:

关键代码

testSpider/spider/myspider.py就是关键代码,目前的代码如下:

import scrapy

class MyspiderSpider(scrapy.Spider):

name = 'myspider'

allowed_domains = ['example.com']

start_urls = ['http://example.com/']

def parse(self, response):

pass根据文章标题的需求我只需要使用在以上的文件进行编码就行了,加入要使用到其他的接口爬取方法就要去更改testSpider/setting.py里面的设置,如果感兴趣可以参考我之前的文章:使用Scrapy框架爬取V2ex看看程序员中秋节都在讨论啥

直接亮代码,拿七牛云的登录试了一下,因为感觉他比较简单,步骤较少,适合做教程分享,详细情况在注释中讲解:

import scrapy

from selenium.webdriver.chrome.options import Options

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.wait import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

class MyspiderSpider(scrapy.Spider):

name = 'myspider'

allowed_domains = ['portal.qiniu.com'] # 注意设置好允许爬取的网址列表,这里踩了坑,试了半天发现框架默认的解析器一直没有调用,要写网址的整合域名而不是单单一级域名。

start_urls = ['http://example.com/']

user_name = '********@**.com'

password = '********'

chorme_options = Options()

chorme_options.add_argument("--disable-gpu")

driver = webdriver.Chrome(options=chorme_options) # 初始化Chrome驱动

driver.implicitly_wait(20)

headers = {

'authority': 'portal.qiniu.com',

'accept': '*/*',

'accept-language': 'zh-CN,zh;q=0.9',

'cache-control': 'no-cache',

'referer': 'https://portal.qiniu.com/certificate/ssl',

'sec-ch-ua': '".Not/A)Brand";v="99", "Google Chrome";v="103", "Chromium";v="103"',

'sec-ch-ua-mobile': '?0',

'sec-ch-ua-platform': '"Windows"',

'sec-fetch-dest': 'empty',

'sec-fetch-mode': 'cors',

'sec-fetch-site': 'same-origin',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/103.0.5060.134 Safari/537.36',

} # header

cookie = {}

def __del__(self):

self.driver.close()

def parse(self, response, *args, **kwargs):

print('默认的解析器方法,接口请求内容:')

print(response.json())

def start_requests(self):

self.driver.get(url='https://sso.qiniu.com/') # 直接访问登录页

user_input = self.driver.find_element(By.ID, 'email') # 获取用户名输入框

user_input.send_keys(self.user_name) # 输入用户名

password_input = self.driver.find_element(By.ID, 'password') # 获取密码框

password_input.send_keys(self.password) # 输入密码

self.driver.find_element(By.ID, 'login-button').click() # 登录

try:

WebDriverWait(self.driver, 60).until(EC.visibility_of_element_located(

(By.CLASS_NAME, "user-plane-entry"))) # 等待网页跳转,超时等待60秒

except:

print('登陆超时,失败') # 等待超过了60

self.driver.quit()

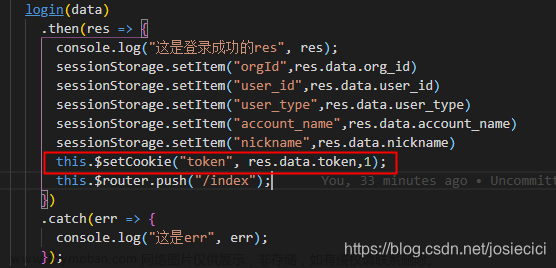

self.cookie = self.driver.get_cookies() # 获取cookie 此时是键值对

print(self.cookie)

print(self.headers)

yield scrapy.Request(url='https://portal.qiniu.com/api/gaea/billboard/list?status=1', callback=self.parse,

cookies=self.cookie,

headers=self.headers) # 迭代器 放入异步任务中请求从日志看看效果:

已经正确打印了接口返回的内容,假如直接请求接口会报错:

总结

在scrapy 中使用selenium是一个非常常见的情况,今天只稍微做一下简单的总结,以后碰到的难点会一一记下来分享出来,敬请期待。

最后:下方这份完整的软件测试视频教程已经整理上传完成,需要的朋友们可以自行领取【保证100%免费】

软件测试面试文档

我们学习必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有字节大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

文章来源:https://www.toymoban.com/news/detail-679674.html

文章来源:https://www.toymoban.com/news/detail-679674.html

全部资料获取

文章来源地址https://www.toymoban.com/news/detail-679674.html

文章来源地址https://www.toymoban.com/news/detail-679674.html

到了这里,关于在scrapy 使用selenium模拟登录获取cookie的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!