1. 背景

之前我们了解了VIT和transformer

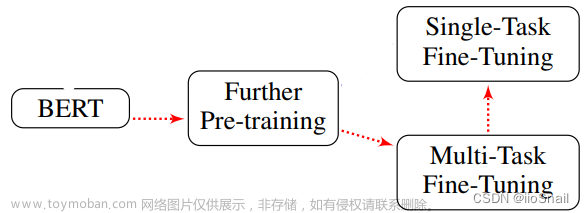

MAE 是基于VIT的,不过像BERT探索了自监督学习在NLP领域的transformer架构的应用,MAE探索了自监督学习在CV的transformer的应用

论文标题中的Auto就是说标号来自于图片本身,暗示了这种无监督的学习

2.方法

像是Bert一样,通过mask形成带掩码的语言模型,挖掉东西,然后让模型来估计

随机盖住一些块patch,然后预测出盖住的patch,预测这个patch里的所有像素

遮住更大的块的话可以让模型学习一些更好的表征

要注意这些模型的基本都很大

2.1 基本流程

(1)首先输入图像随机打成一个一个的块patch,随机遮住其中一些

(2)然后将未遮住的块送入Encoder编码器进行编码 形成特征,这里注意我们的编码器只需要处理未遮住的块,所以计算量要比全部处理更小

(3)和原来遮住的块叠加拼接 再送入decoder解码器恢复被遮住的块

实际使用中,只需要用编码器即可(不需要做掩码)编码器提取特征用于计算机视觉的下游任务

由于编码很重要,所以主要的计算量还是来自编码器

2.2 与VIT比较

(1)盖住更多的块,使得块与块之间的冗余没有那么高

(2)用一个transformer架构的解码器,直接还原原始像素信息,使得整个流程更加简单

(3)加上一些技术,如正则项技术,也可以在小一点的数据集上训练出来,使得训练更加鲁棒

3.实验

映射的维度

微调可以调整个全部的网络,也可以调最后一层,或者调网络中的部分层,微调哪些层文章来源:https://www.toymoban.com/news/detail-679848.html

尝试不同遮住率文章来源地址https://www.toymoban.com/news/detail-679848.html

到了这里,关于MAE 论文精读 | 在CV领域自监督的Bert思想的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![NLP文本匹配任务Text Matching [有监督训练]:PointWise(单塔)、DSSM(双塔)、Sentence BERT(双塔)项目实践](https://imgs.yssmx.com/Uploads/2024/02/659607-1.png)