记录一个比较典型的问题,先讲一下背景,有这么一个用java写的类

public class JavaClass0 implements Serializable {

private static String name;

public static JavaClass0 getName(String str) {

if (name == null) {

name=str;

}

return name;

}

...

}

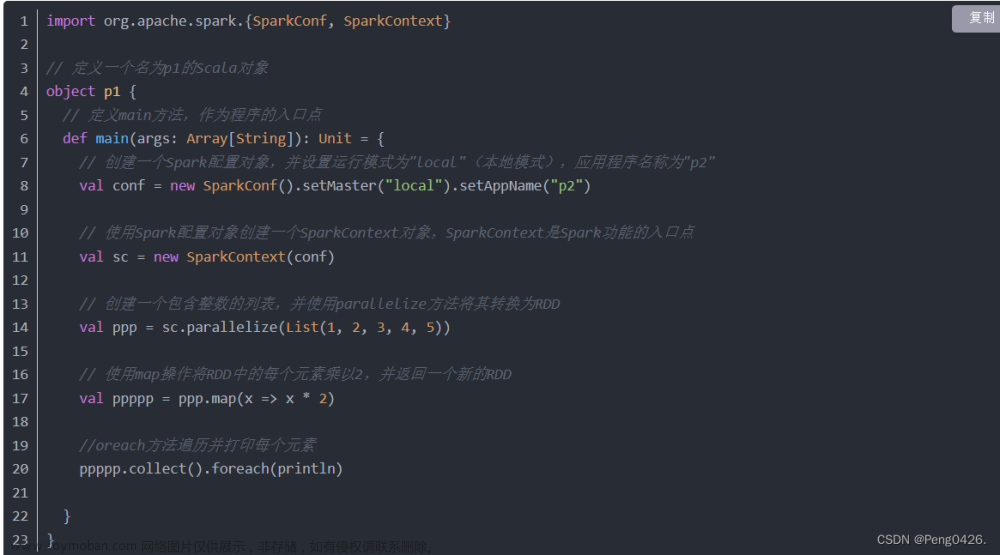

然后在spark中使用的时候:

//driver端

JavaClass0.getName("张三")//得到张三

JavaClass0.getName("李四")//得到张三

df.foreachPartition{//executor端

m=>

JavaClass0.getName("王五")//得到王五

JavaClass0.getName("钱六")//得到王五

}

原因:

scala的object对应的就是java的静态成员,可以反过来理解java的所有静态成员可被抽取成伴生对象(虽然现实中是scala最终编译成java)。以上面的JavaClass0 例子可理解为等价的scala代码为:

class JavaClass0 {

...

}

//伴生对象

object JavaClass0 {

private var name:String = null

getName(str:String) {

if (name == null) {

name=str

}

return name;

}

}

可以看到,JavaClass0并没有被传到executor中,而是重新初始化了一遍。事实也是如此。

Objects, as singletons, are never shipped to executors. There initialized locally, whenever objects is accessed for the first time.

object是不会被传递到executor的,他们在首次被访问的时候,在executor本地做初始化。只要executor的jvm不消亡,就不会再次初始化。文章来源:https://www.toymoban.com/news/detail-680883.html

参考

Sharing objects in Spark

Spark Object (singleton) serialization on executors

Java中static作用及用法详解文章来源地址https://www.toymoban.com/news/detail-680883.html

到了这里,关于【spark】java类在spark中的传递,scala object在spark中的传递的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!