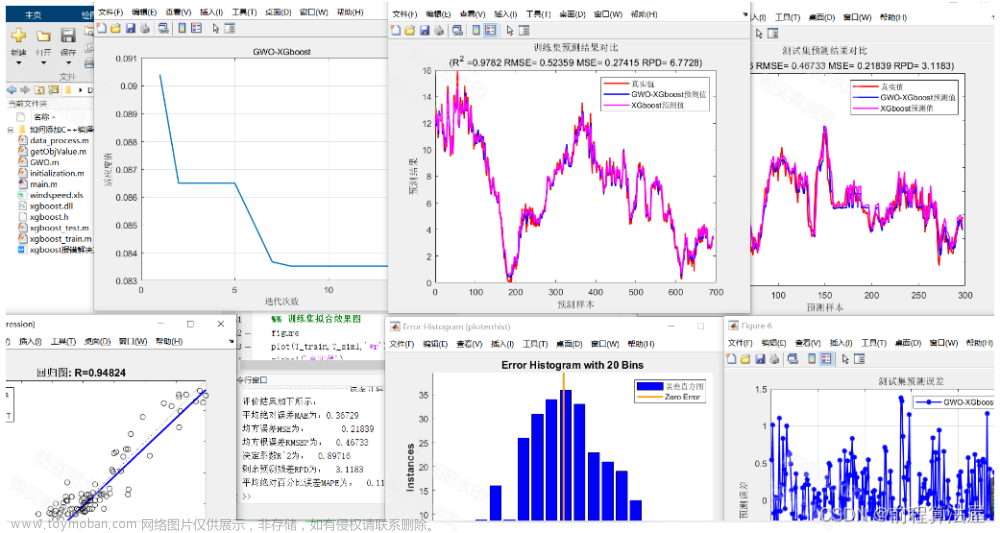

回归预测 | MATLAB实现GWO-ELM灰狼算法优化极限学习机多输入单输出回归预测(多指标,多图)

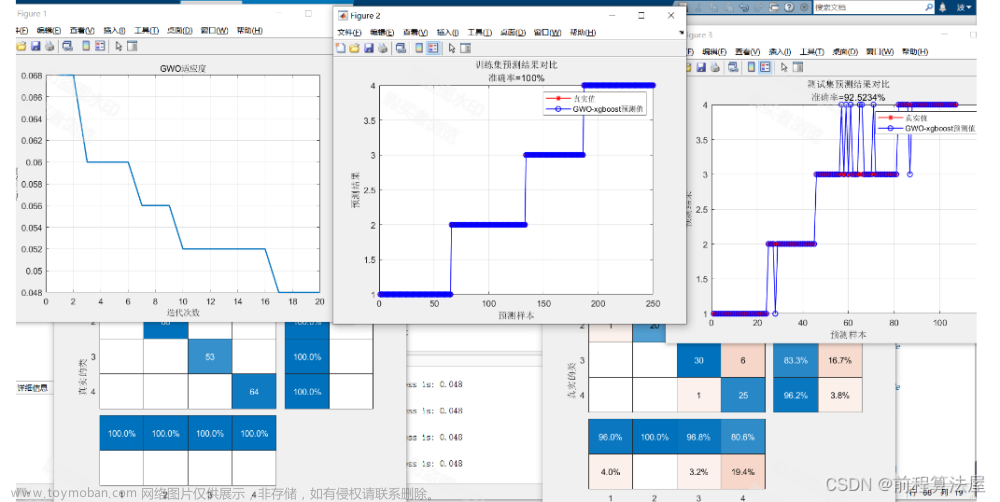

效果一览

基本介绍

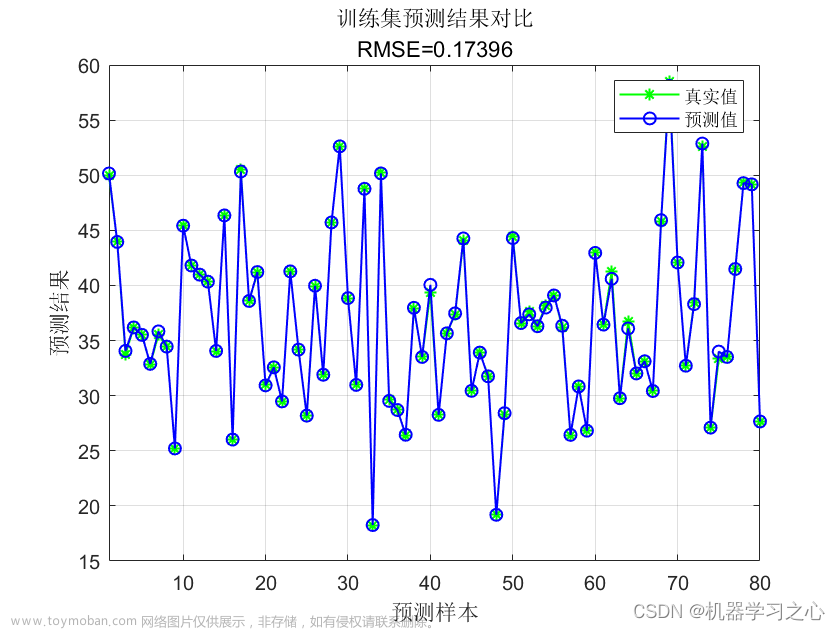

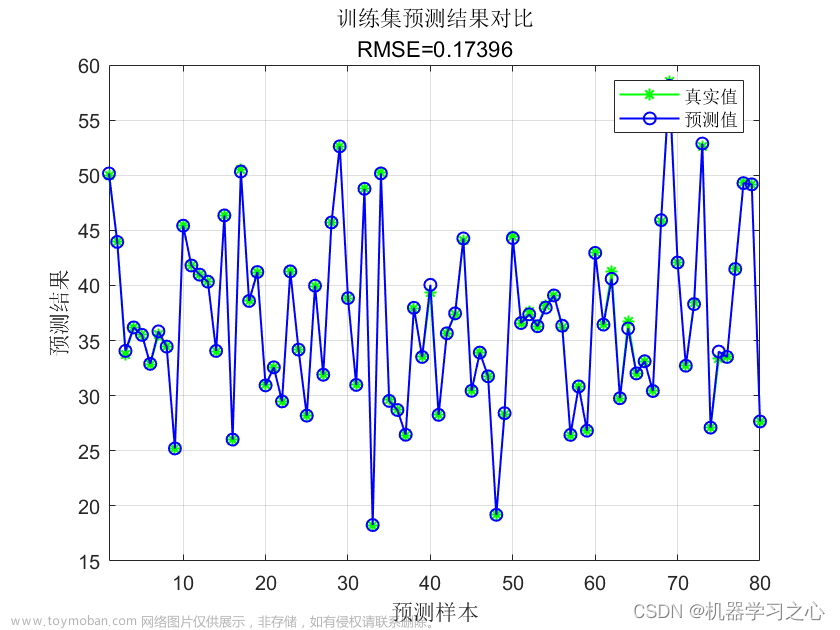

回归预测 | MATLAB实现GWO-ELM灰狼算法优化极限学习机多输入单输出回归预测(多指标,多图),输入多个特征,输出单个变量,多输入单输出回归预测;

多指标评价,代码质量极高;excel数据,方便替换,运行环境2018及以上。

灰狼算法(Grey Wolf Optimization,GWO)是一种基于群体智能的优化算法,灵感来源于灰狼的社会行为和狩猎策略。极限学习机(Extreme Learning Machine,ELM)则是一种机器学习算法,用于解决单隐藏层前馈神经网络的训练问题。将灰狼算法与极限学习机相结合,可以用于优化极限学习机的超参数选择,以提高其性能。根据问题的要求,初始化一定数量的灰狼个体作为初始种群。

设置极限学习机的随机权重和偏置。

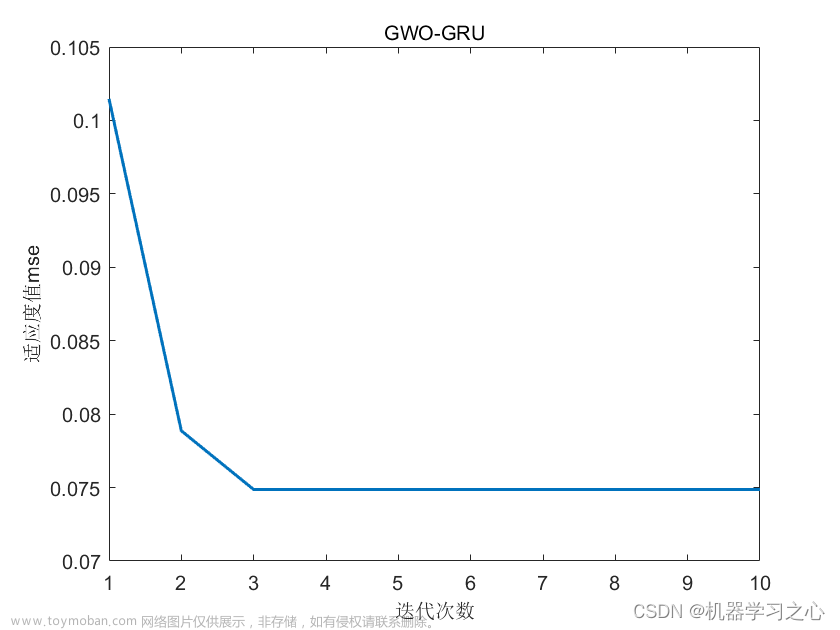

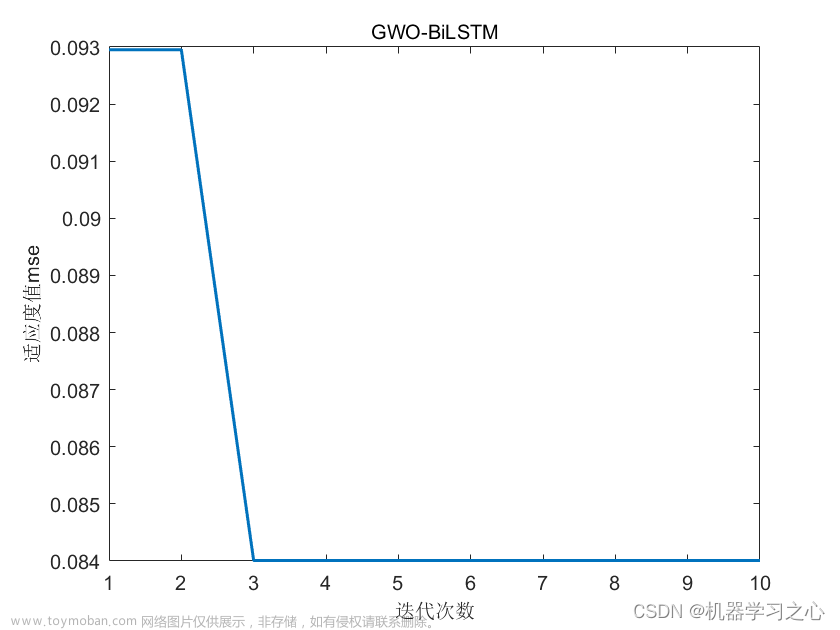

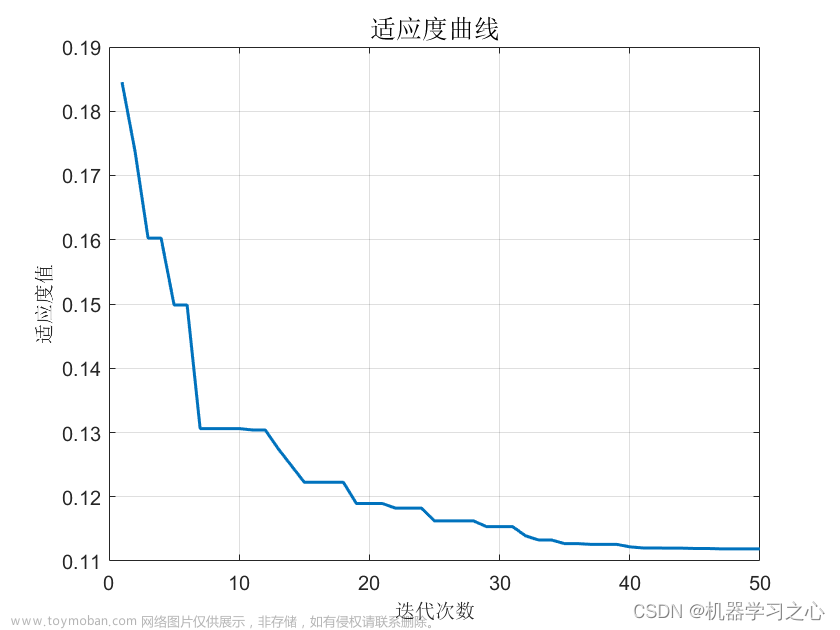

根据当前的极限学习机权重和偏置,利用训练数据计算模型在训练集上的适应度。

根据当前适应度值,更新每个灰狼的位置。较优的灰狼个体将会更有可能成为新的领导者。

利用更新后的灰狼位置,对极限学习机的超参数进行调整。

重复直到达到设定的停止条件(如达到最大迭代次数或收敛到一个满意的解)。

返回具有最佳适应度值的灰狼个体对应的极限学习机模型作为最优解。文章来源:https://www.toymoban.com/news/detail-682947.html

程序设计

- 完整源码和数据获取方式:私信回复GWO-ELM灰狼算法优化极限学习机多输入单输出回归预测(多指标,多图)。

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

%% 导入数据

res = xlsread('data.xlsx');

%% 划分训练集和测试集

temp = randperm(103);

P_train = res(temp(1: 80), 1: 7)';

T_train = res(temp(1: 80), 8)';

M = size(P_train, 2);

P_test = res(temp(81: end), 1: 7)';

T_test = res(temp(81: end), 8)';

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

%% 仿真测试

t_sim1 = sim(net, p_train);

t_sim2 = sim(net, p_test);

%% 数据反归一化

T_sim1 = mapminmax('reverse', t_sim1, ps_output);

T_sim2 = mapminmax('reverse', t_sim2, ps_output);

%% 均方根误差

error1 = sqrt(sum((T_sim1 - T_train).^2) ./ M);

error2 = sqrt(sum((T_sim2 - T_test ).^2) ./ N);

%% 相关指标计算

% 决定系数 R2

R1 = 1 - norm(T_train - T_sim1)^2 / norm(T_train - mean(T_train))^2;

R2 = 1 - norm(T_test - T_sim2)^2 / norm(T_test - mean(T_test ))^2;

disp(['训练集数据的R2为:', num2str(R1)])

disp(['测试集数据的R2为:', num2str(R2)])

% 平均绝对误差 MAE

mae1 = sum(abs(T_sim1 - T_train)) ./ M ;

mae2 = sum(abs(T_sim2 - T_test )) ./ N ;

disp(['训练集数据的MAE为:', num2str(mae1)])

disp(['测试集数据的MAE为:', num2str(mae2)])

% 平均相对误差 MBE

mbe1 = sum(T_sim1 - T_train) ./ M ;

mbe2 = sum(T_sim2 - T_test ) ./ N ;

disp(['训练集数据的MBE为:', num2str(mbe1)])

disp(['测试集数据的MBE为:', num2str(mbe2)])

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/129215161

[2] https://blog.csdn.net/kjm13182345320/article/details/128105718文章来源地址https://www.toymoban.com/news/detail-682947.html

到了这里,关于回归预测 | MATLAB实现GWO-ELM灰狼算法优化极限学习机多输入单输出回归预测(多指标,多图)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!