正文

relative positional embedding的一种实现方式是:先计算q和k的相对位置坐标,然后依据相对位置坐标从给定的table中取值。

以q和k都是7×7为例,每个相对位置有两个索引对应x和y两个方向,每个索引值的取值范围是[-6,6]。(第0行相对第6行,x索引相对值为-6;第6行相对第0行,x索引相对值为6;所以索引取值范围是[-6,6])。

这个时候可以构建一个shape为[13,13, head_dim]的table,则当相对位置为(i,j)时,

position embedding=table[i, j]

(i,j的取值范围都是[0, 12])具体可参考:有关swin transformer相对位置编码的理解

decomposed Relative Positional Embeddings的思想在于,分别计算x和y两个方向上计算相对位置坐标,并分别从两个table中取出对应的位置编码,再将两个方向的编码相加作为最终的编码。

以q为4×4和k是4×4为例,在x和y方向上,每个索引值的取值范围是[-3,3],所以需要构建两个shape为[7, head_dim]的table:

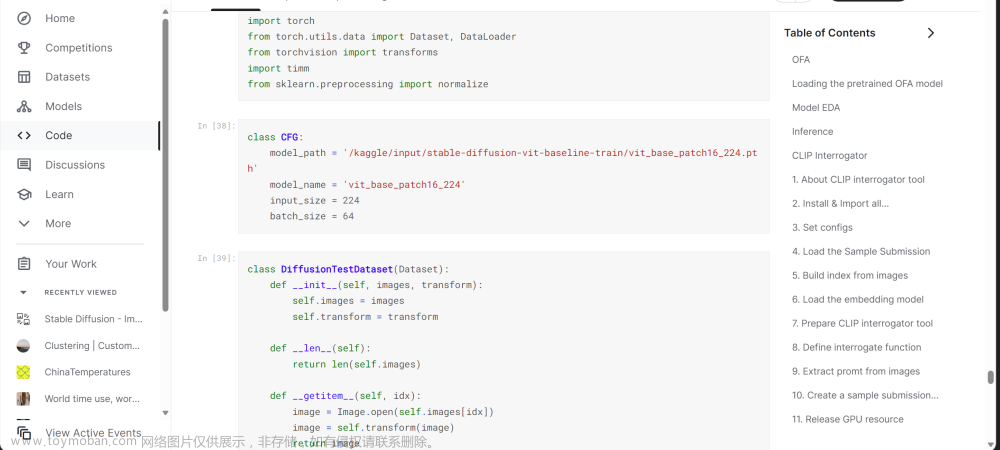

if use_rel_pos:

assert (

input_size is not None

), "Input size must be provided if using relative positional encoding."

# initialize relative positional embeddings

rel_pos_h = nn.Parameter(torch.zeros(2 * input_size[0] - 1, head_dim))

rel_pos_w = nn.Parameter(torch.zeros(2 * input_size[1] - 1, head_dim))

然后依据q和k的shape来计算每个方向上对应的相对位置编码:

def get_rel_pos(q_size: int, k_size: int, rel_pos: torch.Tensor) -> torch.Tensor:

# q_size和k_size分别为当前方向上,q和k的个数, rel_pos为当前方向上定义的table

q_coords = torch.arange(q_size)[:, None] # shape: [4, 1],给当前方向上每个q编号

k_coords = torch.arange(k_size)[None, :] # shape:[1, 4],给当前方向上每个k编号

relative_coords = (q_coords - k_coords) + (k_size - 1) # q_coords - k_coords就是当前方向上每个q相对于k的位置,加上k_size - 1是为了让相对位置非负

return rel_pos[relative_coords.long()] # 依据相对位置从预定义好的table中取值

依据q和每个方向上对应的位置编码来计算最终的编码:

q_h, q_w = q_size

k_h, k_w = k_size

Rh = get_rel_pos(q_h, k_h, rel_pos_h) # 获取h方向的位置编码,shape:[4, 4, head_dim]

Rw = get_rel_pos(q_w, k_w, rel_pos_w) # 获取w方向的位置编码,shape:[4, 4, head_dim]

B, _, dim = q.shape

r_q = q.reshape(B, q_h, q_w, dim)

rel_h = torch.einsum("bhwc,hkc->bhwk", r_q, Rh) # r_q与Rh在h方向矩阵乘

rel_w = torch.einsum("bhwc,wkc->bhwk", r_q, Rw)

# attn是自注意力机制计算得到的注意力图

attn = attn.view(B, q_h, q_w, k_h, k_w) + rel_h[:, :, :, :, None] + rel_w[:, :, :, None, :]

).view(B, q_h * q_w, k_h * k_w)

return attn

Reference

https://github.com/microsoft/Swin-Transformer文章来源:https://www.toymoban.com/news/detail-683328.html

https://blog.csdn.net/weixin_42364196/article/details/132477924文章来源地址https://www.toymoban.com/news/detail-683328.html

到了这里,关于decomposed Relative Positional Embeddings的理解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!