网络爬虫是一种自动获取网页内容的程序,它可以从互联网上的网站中提取数据并进行分析。本教程将带您逐步了解如何使用 Python 构建一个简单的网络爬虫。

注意:在进行网络爬虫时,请遵守网站的使用条款和法律法规,避免对目标网站造成不必要的负担。

步骤 1:设置环境

-

安装 Python:确保您的计算机上已经安装了 Python。您可以从官方网站 https://www.python.org/downloads/ 下载并安装最新版本的 Python。

-

安装必要的库:在命令行中运行以下命令安装所需的库。

pip install requests pip install beautifulsoup4

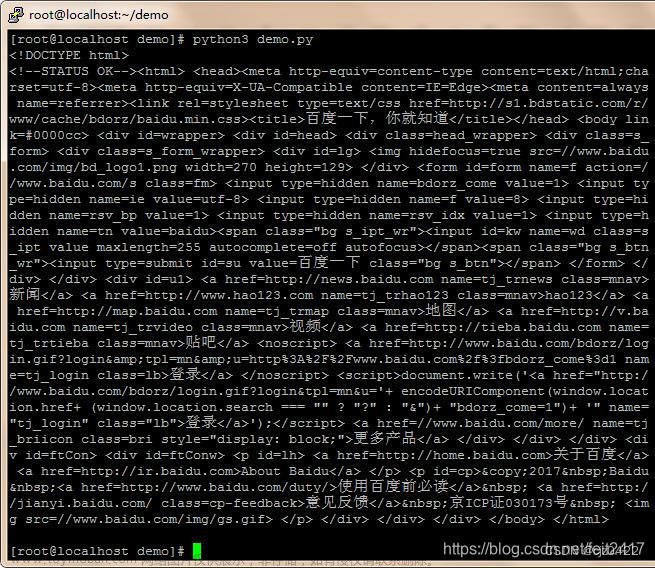

步骤 2:发送 HTTP 请求

使用 requests 库向目标网站发送 HTTP 请求,并获取网页内容。

import requests

url = "https://example.com" # 目标网站的 URL

response = requests.get(url)

if response.status_code == 200:

html_content = response.content

print(html_content)

else:

print("Failed to retrieve the page")

步骤 3:解析网页内容

使用 beautifulsoup4 库解析 HTML 内容,以便提取有用的信息。

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, "html.parser")

# 示例:提取页面标题

title = soup.title.text

print("Page title:", title)

步骤 4:提取信息

使用 BeautifulSoup 的方法来定位和提取您感兴趣的信息。

# 示例:提取所有链接

links = soup.find_all("a")

for link in links:

print(link.get("href"))

# 示例:提取特定元素的文本

paragraphs = soup.find_all("p")

for paragraph in paragraphs:

print(paragraph.text)

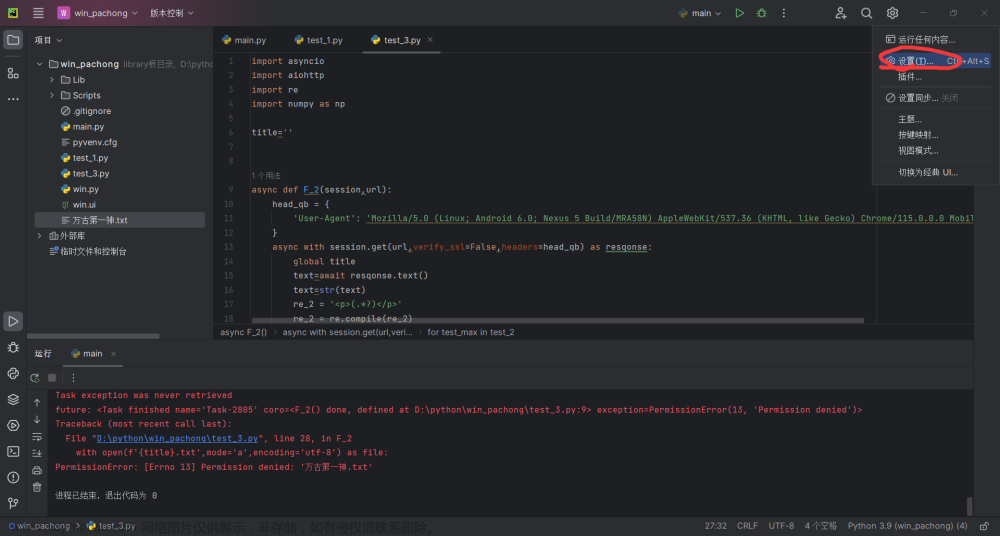

步骤 5:保存数据

将提取的数据保存到文件中,以便后续分析。

# 示例:将提取的文本内容保存到文件

with open("output.txt", "w", encoding="utf-8") as file:

for paragraph in paragraphs:

file.write(paragraph.text + "\n")

步骤 6:循环爬取多个页面

循环遍历多个页面,实现批量爬取数据。

# 示例:爬取多个页面的信息

base_url = "https://example.com/page/"

for page_num in range(1, 6):

url = base_url + str(page_num)

response = requests.get(url)

# 继续处理页面内容...

总结文章来源:https://www.toymoban.com/news/detail-683373.html

这只是一个简单的网络爬虫教程,涵盖了基本的步骤:发送请求、解析内容、提取信息和保存数据。在实际应用中,您可能需要处理更复杂的网站结构、处理异常情况、使用正则表达式等。请确保在爬取网站时遵循合适的道德和法律准则。文章来源地址https://www.toymoban.com/news/detail-683373.html

到了这里,关于一个简单的Python网络爬虫教程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!