前言

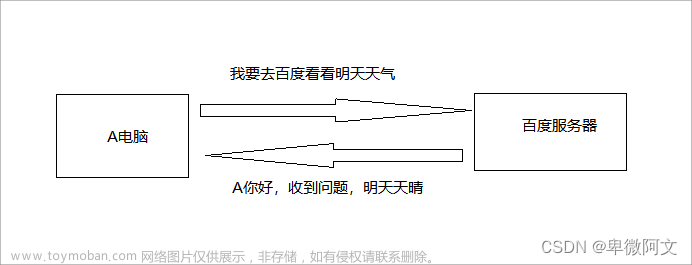

在进行爬虫开发时,代理IP池是一个非常重要的概念。代理IP池是指一个包含多个可用代理IP的集合,这些代理IP可以用来绕过网站的防爬虫策略,从而提高爬取数据的成功率。

在本文中,我们将介绍如何获取代理IP池,并且随机生成可用的代理IP。除此之外,我们还将以爬取微博热搜为例,介绍代理IP池的应用。

一、获取代理IP池

在获取代理IP池之前,我们需要先了解一些代理IP提供商的信息。代理IP提供商一般会提供API接口或者代理IP列表来供我们使用。

以站大爷为例,他们提供了一个API接口,在访问该接口时,可以随机获得一个可用的代理IP。使用Python来获取代理IP的代码如下:

```

import requests

def get_proxy():

url = 'http://http://www.zdopen.com/ShortProxy/GetIP/?api=202207291010568666&akey=ca950945aa6aa851×pan=1&type=1'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.text.strip()

return None

```get_proxy函数通过访问API接口来获取一个可用的代理IP。其中,url参数是API接口的请求地址,headers参数中包含了User-Agent信息,这是为了避免被网站识别为爬虫。

接下来,我们需要将这些代理IP保存起来,供后面使用。在本文中,我们使用Python的list列表来保存代理IP。示例代码如下:

```

proxy_list = []

for i in range(10):

proxy = get_proxy()

if proxy:

proxy_list.append(proxy)

```上面的代码中,我们使用get_proxy函数来获取10个代理IP,并且将它们添加到一个名为proxy_list的list列表中。

二、随机获取代理IP

在使用代理IP时,我们需要随机获取一个代理IP。这样可以避免使用同一个代理IP过于频繁,从而提高爬取数据的成功率。

使用Python来随机获取代理IP的代码如下:

```

import random

def get_random_proxy():

if proxy_list:

return random.choice(proxy_list)

return None

```上面的代码中,我们使用Python的random模块,随机选择一个代理IP。如果代理IP池中没有可用的代理IP,就返回None。

三、代理IP池的应用

下面我们来介绍一个使用代理IP池的示例程序。该程序需要爬取微博热搜,由于微博对频繁访问有限制,我们需要使用代理IP来完成任务。

首先,我们需要获取微博热搜的页面源码。我们使用requests库来访问页面,然后使用lxml库解析HTML文档,找到热搜关键词。代码如下:

```

import requests

from lxml import etree

def parse_page(url):

proxies = {'http': 'http://' + get_random_proxy(), 'https': 'https://' + get_random_proxy()}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

try:

response = requests.get(url, headers=headers, proxies=proxies)

if response.status_code == 200:

return response.text

except:

return None

def get_hot_search():

url = 'https://s.weibo.com/top/summary?cate=realtimehot'

html = parse_page(url)

if html:

results = []

tree = etree.HTML(html)

items = tree.xpath('//table[@class="data"][1]//tr[position()>1]')

for item in items:

rank = item.xpath('./td[@class="ranktop"]/text()')[0]

keyword = item.xpath('./td[@class="td-02"]/a/text()')[0]

hot = item.xpath('./td[@class="td-02"]/span/text()')[0]

results.append({'rank': rank, 'keyword': keyword, 'hot': hot})

return results

```上面的代码中,我们使用get_random_proxy函数来随机选择一个代理IP,并且使用requests库来访问微博热搜页面。其中,proxies参数指定了使用的代理IP。接着,我们使用lxml库解析HTML文档,找到热搜关键词。

最后,我们将找到的热搜关键词和热度保存在一个名为results的列表中。文章来源:https://www.toymoban.com/news/detail-683525.html

四、 总结

本文介绍了如何获取代理IP池,并且随机生成可用的代理IP。除此之外,我们还以爬取微博热搜为例,介绍代理IP池的应用。当我们使用代理IP池时,需要注意代理IP池的管理。例如,我们可以使用队列来管理代理IP,控制使用频率,从而降低被封禁的风险。文章来源地址https://www.toymoban.com/news/detail-683525.html

到了这里,关于python爬虫关于ip代理池的获取和随机生成的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!