在数据驱动的时代,获取准确、丰富的数据对于许多项目和业务至关重要。本文将介绍如何使用Python爬虫进行定制化开发,以满足个性化的数据需求,帮助你构建自己需要的数据集,为数据分析和应用提供有力支持。

1.确定数据需求和采集目标

在开始定制化开发之前,首先需要明确你的数据需求和采集目标。确定你需要采集的数据类型、来源和具体要求,例如网页内容、社交媒体信息、电子商务数据等。

2.选择合适的爬虫框架和工具

根据数据需求和采集目标,选择合适的Python爬虫框架和工具。常用的爬虫框架包括Scrapy、BeautifulSoup、Selenium等,它们提供了丰富的功能和工具,方便进行数据采集和处理。

3.分析目标网站和数据结构

在开始编写爬虫代码之前,需要仔细分析目标网站的页面结构和数据源。了解网页的HTML结构、数据交互方式和数据提取规则,为后续的爬虫开发提供指导。

4.编写定制化的爬虫代码

根据数据需求和分析结果,编写定制化的爬虫代码。使用选定的爬虫框架和工具,实现数据的抓取、解析和清洗。根据需要,可以添加处理反爬虫策略、使用代理IP、处理验证码等功能。

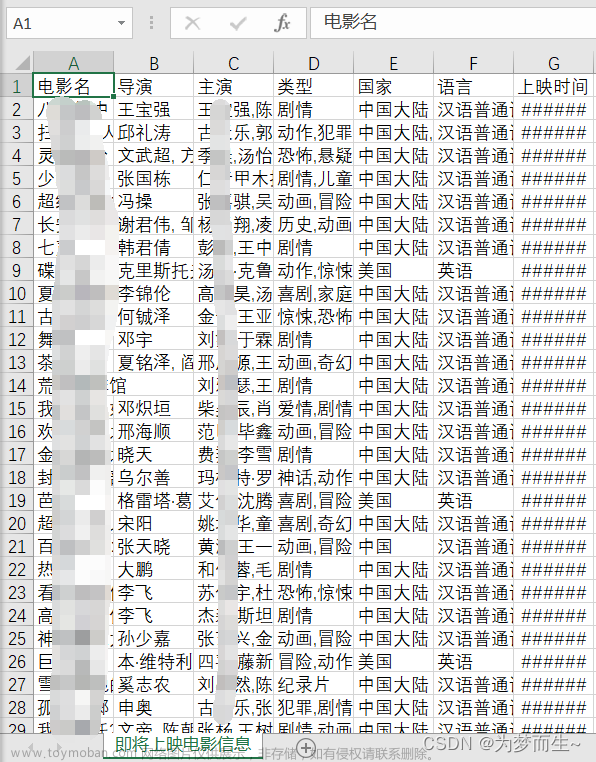

5.数据存储和管理

选择合适的数据存储方式,将采集到的数据进行存储和管理。可以使用数据库(如MySQL、MongoDB)、文件存储(如CSV、JSON)或云存储等方式,根据实际需求选择最适合的方案。

6.数据集维护和更新

定制化开发的数据集需要进行维护和更新,以保证数据的准确性和时效性。定期运行爬虫代码,获取最新的数据,并进行必要的数据清洗和更新操作。

7.数据集应用和分析

获得定制化的数据集后,你可以根据自己的需求进行数据分析和应用。使用数据分析工具(如Python的pandas、numpy库)进行数据处理和统计分析,为业务决策和项目实施提供支持。

通过以上步骤,你可以使用Python爬虫进行定制化开发,构建自己需要的数据集。这将为你的项目和业务提供准确、个性化的数据支持,帮助你取得更好的效果和成果。文章来源:https://www.toymoban.com/news/detail-683897.html

希望以上内容能够帮助你理解和实践使用Python爬虫定制化开发自己需要的数据集!如果你有任何问题或需要进一步的帮助,请随时提问。祝你的数据定制化开发项目取得成功!文章来源地址https://www.toymoban.com/news/detail-683897.html

到了这里,关于使用Python爬虫定制化开发自己需要的数据集的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!