前向传播(Forward Propagation)和反向传播(Back propagation)是深度学习中神经网络训练的两个关键步骤。

前向传播(Forward Propagation):

-

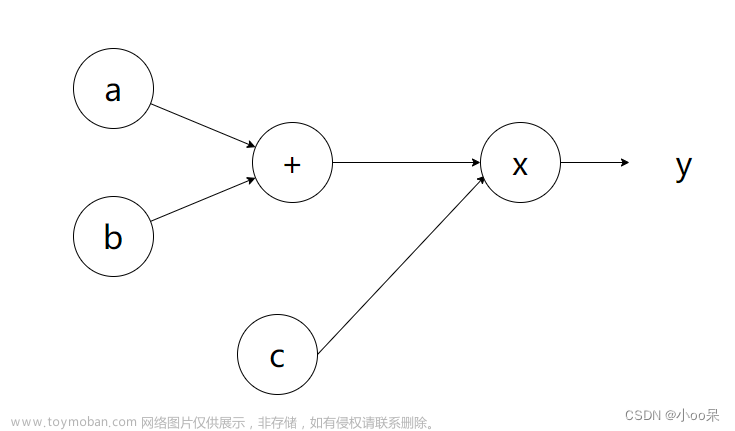

定义:前向传播是指从神经网络的输入层到输出层的过程,通过输入数据和当前的模型参数,计算网络的输出。

-

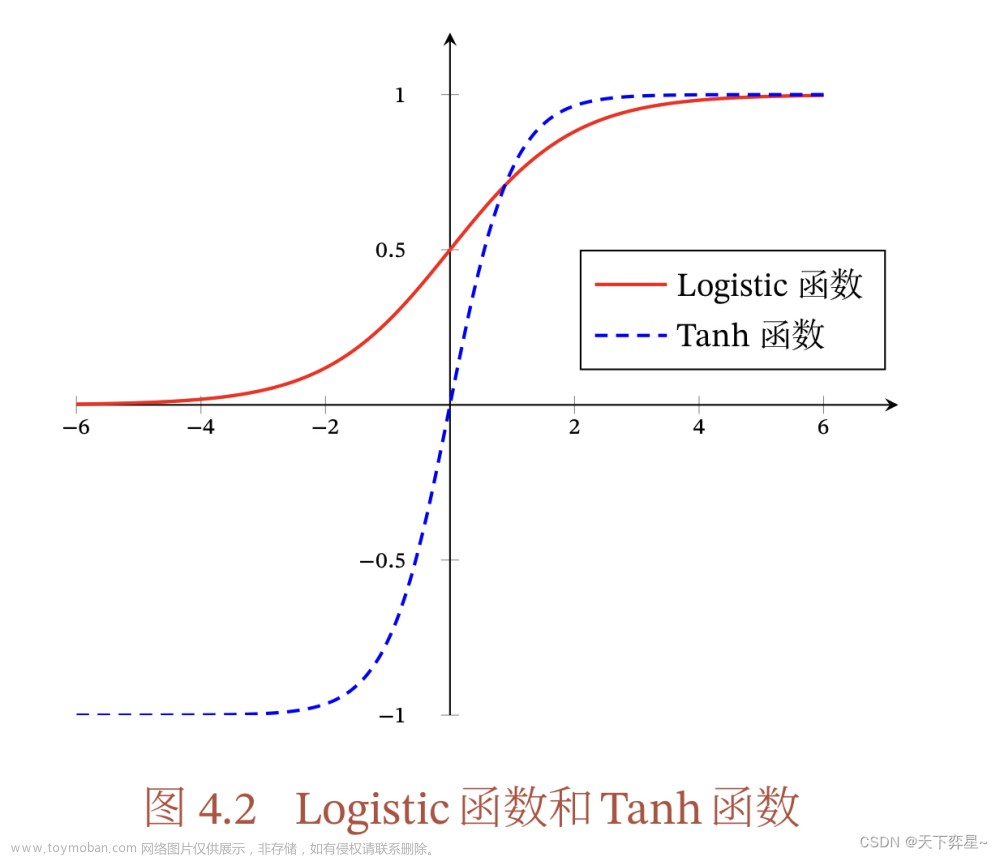

步骤:在前向传播中,数据从输入层经过各个中间层(隐层)的神经元,经过加权和激活函数的计算,传递到输出层,最终得到模型的预测输出。

-

目的:前向传播用于计算模型的预测值,以便与实际目标值进行比较,计算损失函数(误差)。

反向传播(Backpropagation):

-

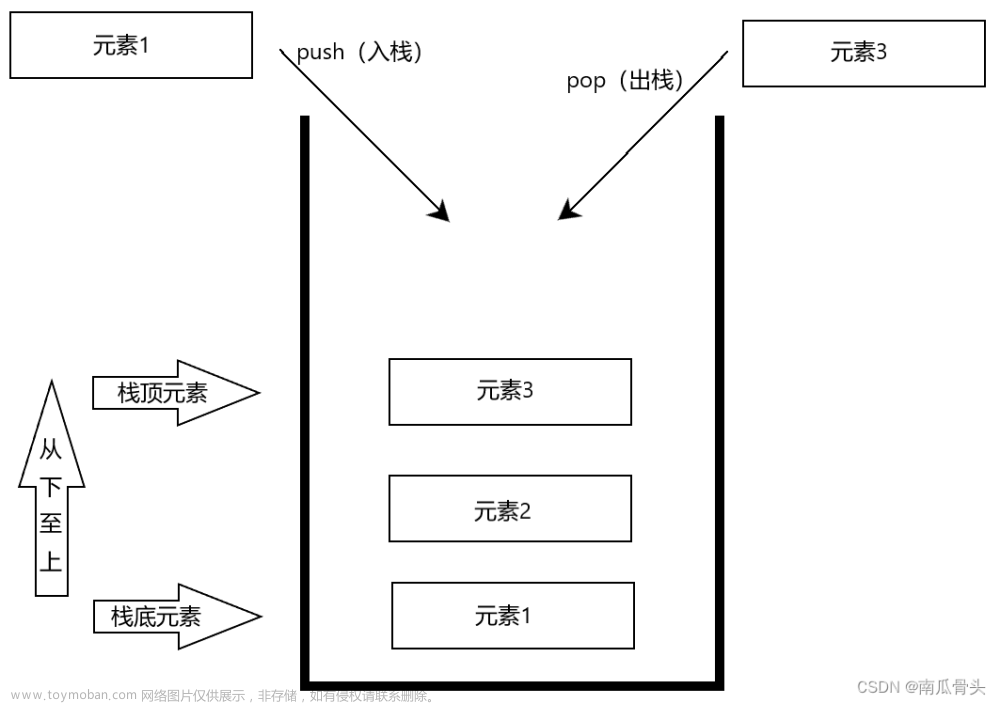

定义:反向传播是指在前向传播之后,通过计算损失函数对模型参数的梯度,从输出层反向传递梯度信息,以便更新模型参数。

-

步骤:反向传播通过链式法则计算梯度,从输出层开始,将损失函数对每个参数的梯度向后传递到每一层,以确定每个参数的梯度。

-

目的:反向传播的目的是计算模型参数的梯度,以便使用梯度下降等优化算法来更新参数,最小化损失函数,使模型更好地拟合训练数据。

关键要点:文章来源:https://www.toymoban.com/news/detail-684072.html

- 前向传播用于计算预测输出和损失函数。

- 反向传播用于计算参数梯度,以便进行参数更新。

- 反向传播是自动微分的一种形式,它有效地计算了损失函数对每个参数的偏导数。

- 反向传播是训练神经网络的基础,通过迭代前向传播和反向传播来优化网络参数,使其逐渐收敛到最优解。

- 深度学习框架(如TensorFlow、PyTorch)通常会自动处理前向传播和反向传播的计算,简化了模型训练的过程。

前向传播和反向传播是神经网络训练的核心过程,它们允许模型根据数据不断调整参数,以逐渐提高模型性能。文章来源地址https://www.toymoban.com/news/detail-684072.html

到了这里,关于机器学习之前向传播(Forward Propagation)和反向传播(Back propagation)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!