解压文件

复制bin目录

找到winutils-master文件hadoop对应的bin目录版本

全部复制替换掉hadoop的bin目录文件

复制hadoop.dll文件

将bin目录下的hadoop.dll文件复制到System32目录下

配置环境变量

修改hadoop-env.cmd配置文件

注意jdk装在非C盘则完全没问题,如果装在C盘则需要用路径替代符:\PROGRA~1\

如 :C:\PROGRA~1\Java\jdk1.8.0_162

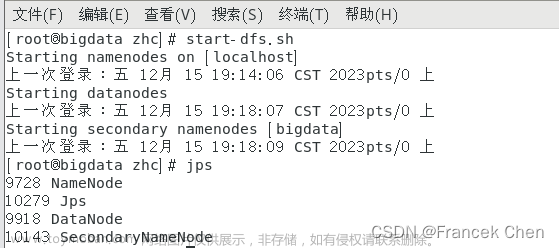

测试安装成功

在cmd中查看安装成功文章来源:https://www.toymoban.com/news/detail-684675.html

文章来源地址https://www.toymoban.com/news/detail-684675.html

文章来源地址https://www.toymoban.com/news/detail-684675.html

到了这里,关于Windows运行Spark所需的Hadoop安装的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!