1. 大型语言模型的不足之处

很多人使用OpenAI提供的GPT系列模型时都反馈效果不佳。其中一个主要问题是它无法回答一些简单的问题。

● 可控性:当我们用中文问AI一些关于事实的问题时,它很容易编造虚假答案。

● 实时性:而当你询问它最近发生的新闻事件时,它会干脆地告诉你它无法预测未来的情况。(它不知道 21 年之后的事情)

● 私域性:同时,有些信息和问题我们只想在机构内部使用,而不想对外开放。在这种情况下,我们希望能够利用OpenAI的大型语言模型的能力,但又需要限制这些能力只能在我们指定的数据范围内使用。

今天这一讲,我们将探讨解决这些问题的方法。

当我们问一个通识问题时,比如“鲁迅先生去日本学习医学的老师是谁”,使用ChatGPT这样的大型语言模型,它给出的答案可能是错误的: 文章来源:https://www.toymoban.com/news/detail-684868.html

文章来源:https://www.toymoban.com/news/detail-684868.html

而不是我们学过的正确答案藤野先生。这是因为大型语言模型的工作原理和训练数据有关。

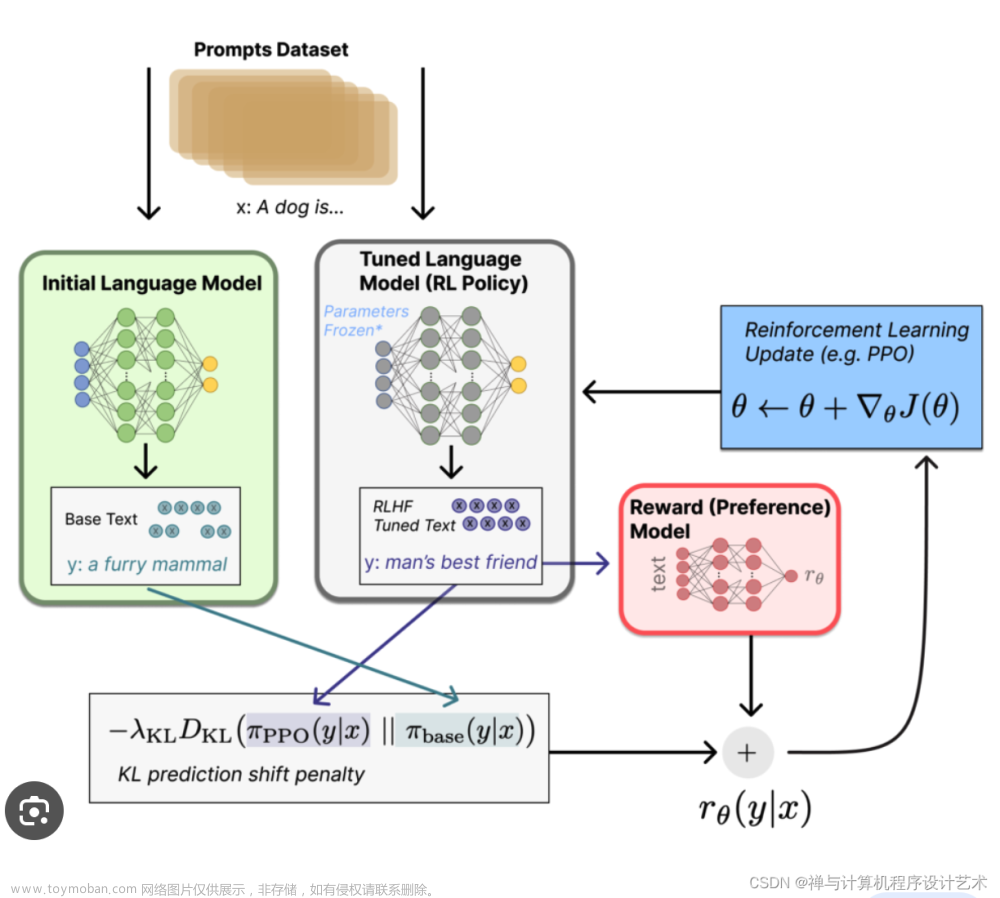

大型语言模型的工作原理是根据训练样本中文本的前后关系,通过前面的文本来预测接下来的文本。如果类似的文本组合出现频率越高,模型就会在训练过程中更准确地预测答案。但如果这样的文本组合很少出现,训练过程就会有些随机性,导致回答可能不准确。

而GPT-3.5这个模型里,虽然总的训练语料很多,但其中只有不到1%是中文。所以,当我们问很多中文相关的知识或常识性问题时,ChatGPT的回答可能会离谱。这是因为它在中文方面的知识不够充分。

当然,我们可以想到一个解决方法,那就是多找一些高质量的中文语料来重新训练一个新的模文章来源地址https://www.toymoban.com/news/detail-684868.html

到了这里,关于【大模型AIGC系列课程 2-2】大语言模型的“第二大脑”的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!