概要

是否还在为网页测试而烦恼?是否还在为重复的点击、等待而劳累?试试强大的

Selenium!让你的网页自动化测试变得轻松有趣!

一、Selenium库到底是什么?

Selenium 是一个强大的自动化测试工具,它可以让你直接操控浏览器,完成各种与网页交互的任务。通过使用 Python 的 Selenium 库,你可以高效地实现网页自动化测试,从而节省大量时间和精力。

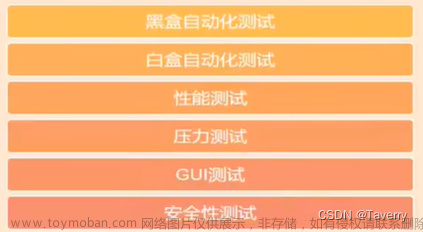

1.1 Selenium库的主要功能

-

自动化测试:可以实现对网站的自动化功能测试,比如点击按钮、输入文本、选择下拉菜单等。

-

网页爬虫:对于一些需要登录或者有反爬机制的网站,使用 Selenium 可以轻松应对。

-

自动化任务:如定时访问网站、自动提交表单等。

1.2 Selenium库的优势

-

支持多种编程语言:Python、Java、C#、Ruby 等。

-

支持多种浏览器:Chrome、Firefox、Edge、Safari 等。

-

跨平台:Windows、macOS、Linux。

-

社区活跃,持续更新维护。

二、Selenium库的安装与配置

2.1 安装Selenium库

在安装 Selenium 库之前,请确保已经安装了 Python。接下来,只需打开终端或命令提示符,输入以下命令即可安装 Selenium 库:

pip install selenium

2.2 配置浏览器驱动

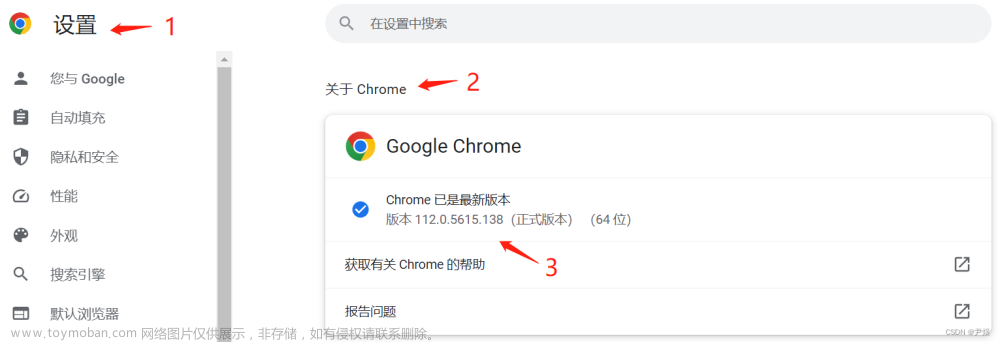

要使用 Selenium 控制浏览器,你还需要安装对应浏览器的驱动。这里以 Chrome 浏览器为例,其他浏览器驱动的安装方法类似。

-

下载 Chrome 驱动:搜 ChromeDriver 在下载页面选择与你的 Chrome 浏览器版本匹配的驱动。

-

解压下载的压缩包,将解压后的

chromedriver文件放置在一个可执行路径下,如/usr/local/bin(macOS、Linux)或C:\Windows(Windows)。

三、使用Selenium库进行基本操作

3.1 启动浏览器

导入 Selenium 的 webdriver 模块,然后实例化一个 Chrome 驱动对象,就可以启动 Chrome 浏览器了:

from selenium import webdriver

driver = webdriver.Chrome()

3.2 打开网页

使用 get 方法,传入目标网址,即可让浏览器打开该网址:

driver.get("https://www.baidu.com")

3.3 定位页面元素

Selenium 提供了多种定位页面元素的方法,如 find_element_by_id、find_element_by_name、find_element_by_class_name 等。这里以百度搜索框为例,使用 find_element_by_id 方法定位:

search_box = driver.find_element_by_id("kw")

3.4 操作页面元素

找到页面元素后,你可以对其进行各种操作,如输入文本、点击按钮等。这里以输入搜索关键词为例:

search_box.send_keys("Selenium")

3.5 提交表单

在搜索框输入关键词后,还需要点击“百度一下”按钮来提交表单。这里用 find_element_by_id 方法定位按钮,然后用 click 方法进行点击:

search_button = driver.find_element_by_id("su")

search_button.click()

3.6 等待页面加载

在进行自动化测试时,很多时候需要等待页面加载。Selenium 提供了两种等待方法:显式等待和隐式等待。

3.6.1 显式等待

显式等待会在指定时间内,不断尝试查找目标元素,直到找到为止。这里以等待搜索结果出现为例:

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

try:

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "content_left"))

)

except TimeoutException:

print("等待超时!")

3.6.2 隐式等待

隐式等待会在查找元素时,等待指定时间后再抛出异常。这里以等待搜索结果出现为例:

driver.implicitly_wait(10)

content_left = driver.find_element_by_id("content_left")

3.7 获取页面信息

获取页面的标题、URL、源代码等信息:

title = driver.title

url = driver.current_url

source = driver.page_source

print("标题:", title)

print("URL:", url)

3.8 关闭浏览器

完成所有操作后,别忘了关闭浏览器:

driver.quit()

四、Selenium库的高级应用

4.1 切换窗口

在进行自动化测试时,有时需要切换到新打开的窗口。这里以点击百度首页底部的 “关于百度” 链接为例,演示如何切换窗口:

from selenium.webdriver.common.keys import Keys

about_link = driver.find_element_by_link_text("关于百度")

about_link.send_keys(Keys.CONTROL + Keys.RETURN)

driver.switch_to.window(driver.window_handles[-1])

4.2 切换 Frame

有些网页会使用 Frame 嵌套页面,这时需要切换到对应的 Frame 才能操作其中的元素。切换 Frame 可以用 switch_to.frame 方法:

driver.switch_to.frame("frame_name")

切换回主页面可以用 switch_to.default_content 方法:

driver.switch_to.default_content()

4.3 执行 JavaScript 代码

有时候,你可能需要执行一些 JavaScript 代码来实现特定功能,比如滚动页面、修改元素属性等。这里以滚动页面为例:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

五、技术总结

通过本文的介绍,相信你已经掌握了 Selenium 库的基本知识,包括自动化测试、浏览器驱动、页面交互等。现在,你可以用 Python + Selenium 轻松搞定网页自动化测试啦!

文章来源地址https://www.toymoban.com/news/detail-685296.html

文章来源:https://www.toymoban.com/news/detail-685296.html

到了这里,关于Python爬虫框架之Selenium库入门:用Python实现网页自动化测试详解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!