推荐两篇博文

mapreduce 的工作原理:

图文详解 MapReduce 工作流程_mapreduce工作流程_Shockang的博客-CSDN博客

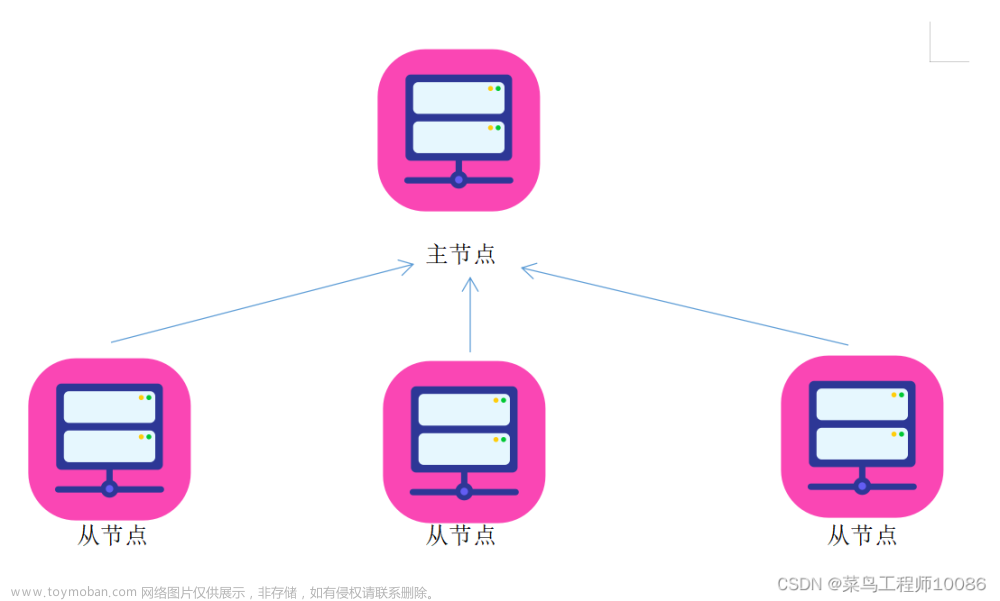

hdfs 上传文件的流程文章来源:https://www.toymoban.com/news/detail-685796.html

HDFS原理 - 知乎文章来源地址https://www.toymoban.com/news/detail-685796.html

到了这里,关于mapreduce 的工作原理以及 hdfs 上传文件的流程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!