1、概述

1)webUI依赖

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-runtime-web_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

2)调用StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(configuration);

3)可以通过configuration配置webUI的端口号

2、代码实现

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.datastream.DataStreamSink;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

public class LocalWebUI {

public static void main(String[] args) throws Exception {

// 创建本地执行环境,并设置 webUI 参数

Configuration configuration = new Configuration();

configuration.setInteger("rest.port", 8081);

// 创建一个带 webUI 的本地执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(configuration);

// 从端口接入数据

DataStreamSource<String> lines = env.socketTextStream("localhost", 8888);

// 使用map方法对输入的单词转为大写

SingleOutputStreamOperator<String> uppered = lines.map(line -> line.toUpperCase());

DataStreamSink<String> print = uppered.print();

env.execute();

}

}

3、执行结果

1)输入测试数据

nc -lk 8888

hello

控制台输出执行结果

HELLO

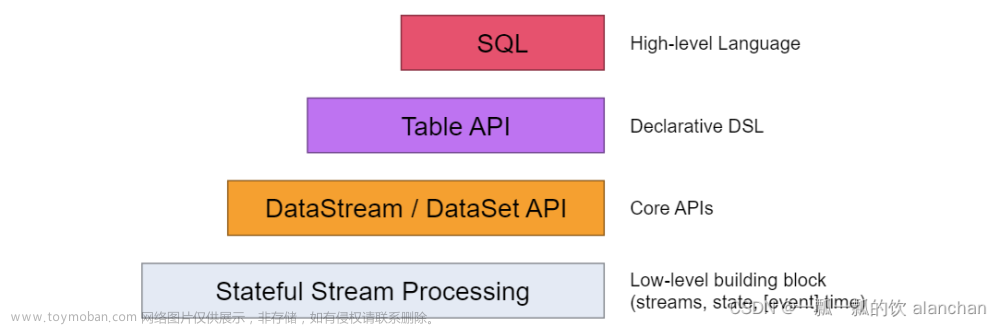

2)localhost:8081查看webUI文章来源:https://www.toymoban.com/news/detail-685883.html

文章来源地址https://www.toymoban.com/news/detail-685883.html

文章来源地址https://www.toymoban.com/news/detail-685883.html

到了这里,关于十三、Flink使用local模式执行任务 并开启Flink的webUI的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!