随着越来越多的人意识到他们通过他们经常访问的无数应用程序和网站共享了多少个人信息,数据保护和隐私一直在不断讨论。看到您与朋友谈论的产品或您在 Google 上搜索的音乐会迅速作为广告出现在您的社交媒体提要中,这不再那么令人惊讶。这让很多人感到担忧。

最近的政府举措,如欧盟的《通用数据保护条例》(GDPR),旨在保护个人的数据隐私,其核心概念是“被遗忘的权利”。

坏消息是,通常很难撤销已经在线共享的内容或正确删除此类数据。例如,Facebook最近推出了一款“Off-Facebook Activity”工具(以前称为“Clear History”),该公司表示,该工具使用户能够删除第三方应用程序和网站与Facebook共享的数据。但正如《麻省理工科技评论》(MIT Technology Review)所指出的那样,“这有点误导——Facebook并没有从第三方删除任何数据,它只是将其与自己的数据脱钩。

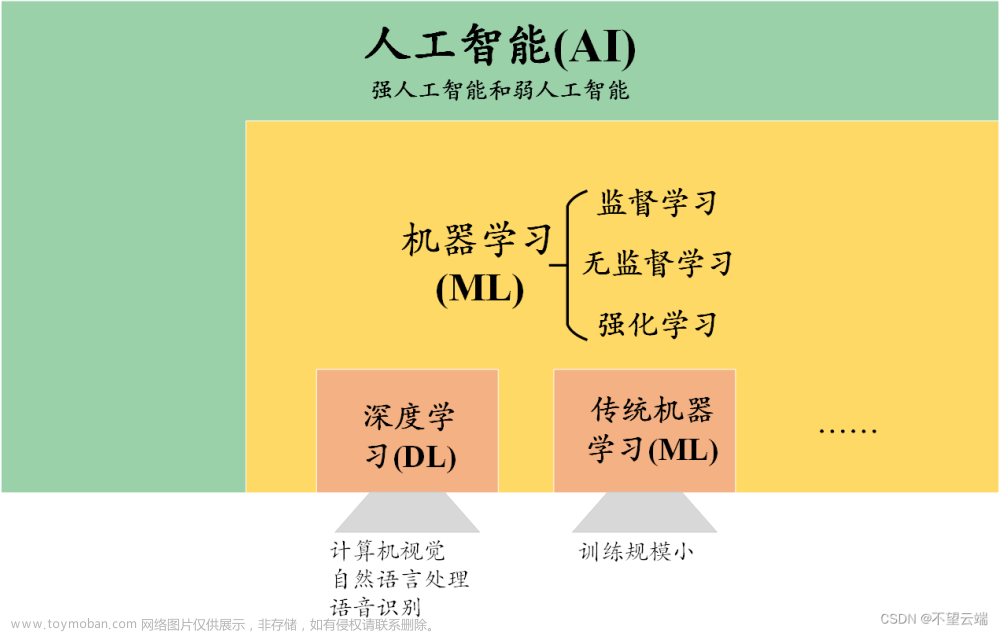

机器学习(ML)越来越被视为加剧了这一隐私问题。数据是驱动 ML 应用程序的燃料,这可能包括收集和分析个人电子邮件甚至医疗记录等信息。一旦输入ML模型,这些数据就可以永久保留,使用户面临各种隐私泄露的风险。

从研究人员的角度来看,一个问题是,如果数据点实际上从 ML 训练集中移除,则可能需要从头开始重新训练下游模型。

在一篇新论文中,来自多伦多大学,矢量研究所和威斯康星大学麦迪逊分校的研究人员提出了SISA训练,这是一种新框架,通过减少删除数据点时需要计算的更新数量来帮助模型“忘记”信息。

“ML在个人数据上的应用规模空前,促使我们研究如何在ML系统中有效地实施这种被遗忘的权利,”研究人员在论文Machine Unlearning中解释道。

让模型忘记某些知识需要使某些特定的训练点对模型的贡献为零。但数据点通常是相互依赖的,很难独立删除。现有数据还会持续使用新添加的数据来优化模型。

一种解决方案是了解各个训练点如何对模型参数更新做出贡献。但正如之前的研究表明,这种方法只有在学习算法按照学习开始之前确定的顺序查询数据时才实用。因此,如果对数据集进行自适应查询(这意味着给定的查询取决于过去所做的任何查询),这种方法将变得更具挑战性,因此很难扩展到深度神经网络等复杂模型。

因此,研究人员提出了一个名为分片、隔离、切片和聚合(SISA)训练的框架,他们提出可以通过对现有管道进行最少的修改来实现。

在SISA培训期间,培训时间A 首先被划分为多个分片,以便每个训练点仅包含在少量分片中——理想情况下是单个分片。然后在每个分片上隔离训练模型,这限制了任何一个数据点对在包含该点的分片上训练的模型的影响。最后,当请求取消学习训练点时,只需要重新训练受影响的模型。这个过程还减少了实现忘却的重新训练时间,因为每个分片当然都比整个训练集小。

每个分片也可以进一步划分为切片,这些切片可以在训练期间逐步呈现。研究人员在引入每个新切片之前保存模型参数的状态,这允许他们从最后一个已知参数状态开始重新训练,该状态不包括要取消学习的点。切片进一步有助于大幅减少模型忘记数据所需的时间。

研究人员在来自不同应用领域的两个数据集上评估了SISA。结果显示,仅通过分片,该框架在Purchase数据集上就将再培训过程加快了3.13倍,在街景门牌号数据集上加快了1.66倍。根据该论文,通过进一步的切片,可以在两台机器上实现额外的加速。

通过展示SISA加速模型解学和在不同场景中泛化的能力,研究人员希望为ML中的实用数据治理提供解决方案,并帮助缓解日益增长的个人数据问题。文章来源:https://www.toymoban.com/news/detail-686079.html

论文《Machine Unlearning》发表在arXiv上。文章来源地址https://www.toymoban.com/news/detail-686079.html

到了这里,关于机器学习:争取被遗忘的权利的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!