目录

持续监控商品价格步骤

1. 选择合适的爬虫库:

2. 选择目标网站:

3. 编写爬虫代码:

4. 设定监控频率:

5. 存储和展示数据:

6. 设置报警机制:

7. 异常处理和稳定性考虑:

可能会遇到的问题

1. 网站反爬虫机制:

2. 页面结构变化:

3. 数据采集速度:

4. 数据存储和处理:

5. 网络连接问题:

6. 法律和道德问题:

7. 更新和维护:

总结

当监控商品价格变得越来越重要时,使用爬虫技术持续跟踪商品价格成为了一种常见的方法。无论是对于价格敏感的消费者还是对于商业运营者来说,及时了解商品的价格波动可以帮助做出更明智的决策。

持续监控商品价格步骤

要用Python爬虫实现对商品价格的持续监控,可以按照以下步骤进行操作:

1. 选择合适的爬虫库:

可以选择使用Scrapy、BeautifulSoup、Selenium等库来编写爬虫代码。这些库提供了不同层次和功能的抓取和解析工具,可以根据实际需求选择合适的库。

import requests

2. 选择目标网站:

确定要监控的商品所在的网站,并了解该网站的页面结构和数据获取方式。

3. 编写爬虫代码:

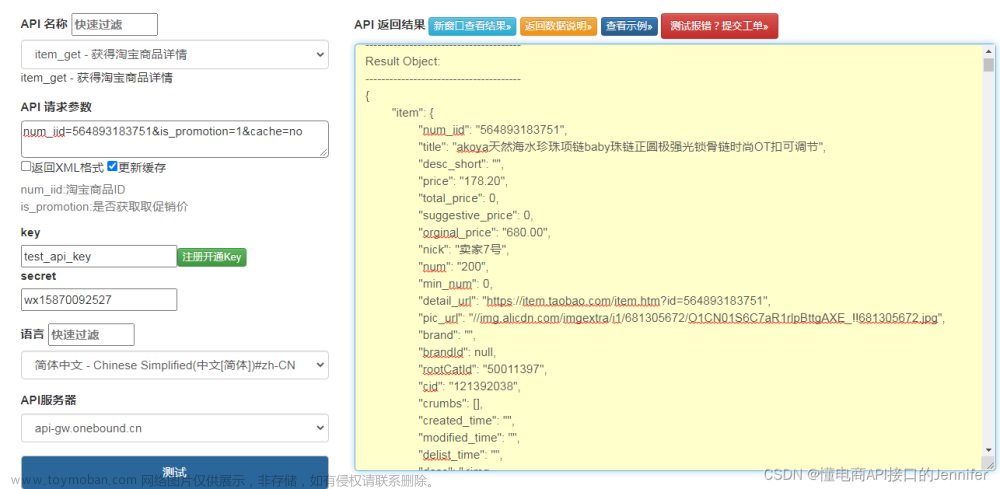

根据目标网站的页面结构,编写爬虫代码来获取商品的价格。可以通过解析网页源代码、调用API接口或者模拟用户操作等方式来获取价格信息。

def get_product_price(url):

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"}

response = requests.get(url, headers=headers)

# 解析网页内容,提取商品价格

# 这里假设价格位于<span id="price" class="product-price">$50.00</span>这样的HTML元素中

# 使用正则表达式或BeautifulSoup库来提取价格信息

# 以下是使用正则表达式的示例代码

import re

pattern = r'<span id="price" class="product-price">(.+?)</span>'

match = re.search(pattern, response.text)

if match:

price = match.group(1)

return price

else:

return None4. 设定监控频率:

确定监控的频率,例如每隔一段时间运行一次爬虫代码来获取最新的价格。可以使用定时任务或者无限循环的方式来实现定期执行爬虫脚本的功能。

import time

while True:

# 获取商品价格

price = get_product_price("https://www.amazon.com/product-url")

if price:

print(f"当前价格:{price}")

else:

print("无法获取价格")

# 暂停一段时间,例如每隔1小时运行一次

time.sleep(3600)5. 存储和展示数据:

将获取的价格数据存储到数据库、CSV文件或其他数据存储形式中,以便后续分析和展示。可以使用第三方库如Pandas和Matplotlib进行数据处理和可视化展示。

6. 设置报警机制:

根据需求,可以设置价格变动的阈值,当价格超出阈值时触发报警机制,例如发送邮件或推送通知。

import smtplib

# 定义发送邮件的函数

def send_email(to_email, subject, body):

from_email = "your_email@example.com"

password = "your_password"

message = f"Subject: {subject}\n\n{body}"

with smtplib.SMTP("smtp.example.com", 587) as server:

server.starttls()

server.login(from_email, password)

server.sendmail(from_email, to_email, message)

# 在主循环中添加判断和报警逻辑

while True:

price = get_product_price("https://www.amazon.com/product-url")

if price:

print(f"当前价格:{price}")

# 如果价格小于100美元,发送邮件报警

if float(price) < 100:

send_email("recipient@example.com", "商品价格报警", f"当前价格低于100美元:{price}")

else:

print("无法获取价格")

time.sleep(3600)7. 异常处理和稳定性考虑:

在爬取过程中,要注意异常处理和稳定性的考虑。例如,要处理网页加载失败、数据解析错误等异常情况,并设置适当的重试机制和错误日志记录。

需要注意网站的反爬虫策略,尊重网站的数据使用规则,遵守合法合规的爬虫行为。

可能会遇到的问题

在使用Python爬虫持续监控商品价格时,可能会遇到以下一些常见问题:

1. 网站反爬虫机制:

有些网站可能会采取反爬虫策略,例如通过验证码、频率限制、动态网页等方式来防止爬虫程序的访问。解决方法可能包括使用代理IP、设置请求头、模拟用户行为等手段来绕过反爬虫机制。

2. 页面结构变化:

网站页面的结构可能会随着时间变化而发生变动,可能会导致之前编写的爬虫代码无法正确获取数据。解决方法包括定期检查和更新爬虫代码,使用灵活的解析方法来适应页面变化。

3. 数据采集速度:

如果爬取速度过快,可能会给目标网站造成负担或触发反爬虫机制。可以通过设置适当的请求间隔、限制并发请求数量等方式来平衡数据采集速度和对网站的影响。

4. 数据存储和处理:

随着时间的推移,爬取到的数据量会逐渐增加,可能需要考虑合适的存储和处理方式,例如使用数据库管理数据、定期清理过期数据等。

5. 网络连接问题:

在爬取过程中,可能会遇到网络连接异常、超时等问题,需要适当处理这些异常情况,并设置重试机制来增加程序的稳定性。

6. 法律和道德问题:

在进行任何爬取活动时,务必遵守法律法规和网站的使用协议,尊重网站的隐私和数据使用规则。确保只获取允许获取的数据,并避免给网站和其他用户带来困扰或损害。

7. 更新和维护:

持续监控商品价格是一个长期的任务,需要进行定期的代码更新和维护,以适应网站变化和数据需求的变化。

以上是一些可能遇到的问题,具体情况会根据目标网站和实际应用场景的不同而有所不同。在实际操作中,可以根据问题的具体特点进行相应的调试和解决。文章来源:https://www.toymoban.com/news/detail-686366.html

总结

我们从选择爬虫库、编写爬虫代码、设置监控频率开始,逐步实现了持续监控商品价格的功能。同时,我们也讨论了在实际应用中可能会遇到的问题,如网站反爬虫机制、页面结构变化等,并给出了相应的解决方法。文章来源地址https://www.toymoban.com/news/detail-686366.html

到了这里,关于如何用Python爬虫持续监控商品价格的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[双指针] (三) LeetCode LCR 179. 查找总价格为目标值的两个商品 和 15. 三数之和](https://imgs.yssmx.com/Uploads/2024/02/744012-1.png)