opencl中的事件概念

当谈到OpenCL中的事件时,它们代表了执行的各个阶段或操作的状态信息。通过使用事件,您可以跟踪和管理内核执行以及内存操作的进度和顺序。以下是与OpenCL事件相关的关键概念:

-

创建事件:您可以使用

clCreateUserEvent或clCreateUserEventWithProperties函数手动创建事件,或者使用OpenCL API执行其他操作时自动创建事件。 -

内核执行事件:当您将内核提交到命令队列进行执行时,会返回一个事件对象,您可以利用该事件对象来跟踪内核执行的状态。

-

等待事件:可以使用

clWaitForEvents或clWaitForEventsWithTimeout函数来阻塞程序直到指定的事件完成。这对于确保内核执行顺序以及依赖关系非常重要。 -

事件回调:您可以通过向事件注册回调函数来异步通知应用程序事件的完成。事件完成后,将调用回调函数,这对于处理异步任务非常有用。

-

事件状态查询:使用

clGetEventInfo函数可以查询事件的状态信息,例如事件是否完成、事件开始和结束的时间等。这些信息对于性能分析和调试很有帮助。

请注意,OpenCL事件是针对并行执行和异步操作优化的工具。了解事件的相关知识可以帮助您更好地管理和优化OpenCL程序的执行流程和性能。

事件队列

在openCL的命令队列执行中,提供相应的事件机制,以控制内核函数执行的时序。在 clEnqueueNDRangeKernel() 函数中提供了 event_wait_list 和 event两个参数,前一个参数是事件队列,表示要等到队列中所有事件都触发后,才真正开始执行当前内核函数;后一个是单个事件,表示当前内核函数执行完成后触发。

事件的同步机制

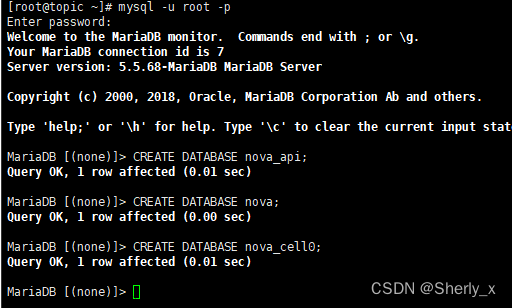

// 立即执行内核函数 filter_A

cl_event event_a = NULL;

err_code = clEnqueueNDRangeKernel(cmd_queue_, kernel_filterA_,

2, // 数据的维度: 二维数据

NULL, global_work_size, local_work_size, 0,

NULL, &event_a);

// 立即执行内核函数 filter_B

cl_event event_b = NULL;

err_code = clEnqueueNDRangeKernel(cmd_queue_, kernel_filterB_,

2, // 数据的维度: 二维数据

NULL, global_work_size, local_work_size, 0,

NULL, &event_b);

// 设置等待事件列表

cl_event wait_events[2];

wait_events[0] = event_a;

wait_events[1] = event_b;

// 执行内核函数 filter_sum

// 需要等前两个内核函数都执行完成,event_a 和 event_b两个事件都被触发后才真正执行。

cl_event event_sum = NULL;

err_code = clEnqueueNDRangeKernel(cmd_queue_, kernel_filterSum_,

2, // 数据的维度: 二维数据

NULL, global_work_size, local_work_size,

2, wait_events, &event_sum);

// 等待 filter_sum执行完成

// 在函数clWaitForEvents中,参数num_events表示等待的事件数量。它指定了要等待的事件数组中的事件数量。在您的例子中,clWaitForEvents(1, &filter_sum)中的参数1表示只等待一个事件,即filter_sum事件。

//这意味着执行clWaitForEvents函数的线程将一直等待,直到filter_sum事件完成或取消。一旦filter_sum事件完成,线程将继续执行后续的代码。

clWaitForEvents(1, &filter_sum);

// 释放所有事件对象

clReleaseEvent(event_a);

clReleaseEvent(event_b);

clReleaseEvent(event_sum);

宿主机内存

(host memory):这个内存区域只对宿主机可见。与有关宿主机的大多数细

节问题一样,OpenCL只定义了宿主机内存与OpenCL对象和构造如何交互。

全局内存

(global memory):这个存储区域允许读、写所有工作组中的所有工作项。工

作项可以读、写全局内存中一个内存对象的任何元素。读、写全局内存可能会缓存

这取决于设备的容量。

常量内存

(constant memory):全局内存的这个内存区域在执行一个内核期间保持不变

宿主机分配并初始化放在常量内存中的内存对象。这些对象对于工作项是只读的。

局部内存

(localmemory):这个内存区域对工作组是局部的。这个内存区域可以用来分

配由该工作组中所有工作项共享的变量。它可以实现为 OpenCL 设备上的专用内存区

域。或者,局部内存区域也可以映射到全局内存的区段 (section)

私有内存

(private memory):这个内存区域是一个工作项私有的区域。一个工作项私有

内存中定义的变量对其他工作项不可见。

内存的分布图示

这些内存区域以及它们与平台和执行模型的关系见图。工作项在处理单元上运行,有其自己的私有内存。工作组在一个计算单元上运行,与该组中的工作项共享一个局部内存区域。OpenCL设备内存利用宿主机来支持全局内存。

在OpenCL中,主要有以下几种类型的内存:

- 全局内存(Global Memory):全局内存是最常用的内存类型,可在多个内核之间进行数据交换。它可以通过

__global修饰符定义,并通过cl_mem类型的指针进行访问。

__kernel void myKernel(__global float* data) {

// 访问全局内存,全局内存作为参数,就是都能访问并改写

float value = data[0];

// ...

}

- 常量内存(Constant Memory):常量内存用于存储只读的全局数据,可以通过

__constant修饰符定义。常量内存对于频繁读取的全局数据非常有用,并可以提高访问效率。

__constant float constantData[10];

__kernel void myKernel() {

// 访问常量内存

float value = constantData[0];

// ...

}

- 局部内存(Local Memory):局部内存用于存储每个工作项(线程)所需的私有数据,可以通过

__local修饰符定义。局部内存仅在工作组(工作项组成的组)内共享。

// 创建内核程序

const char* source = "__kernel void myKernel(__local float* localData) { \

// 在局部内存中定义局部数组

__local float localArray[128]; \

// ... \

}";

此外,还有私有内存(Private Memory)和图像内存(Image Memory)等特殊类型的内存。

私有内存是每个工作项(线程)私有的存储空间,用于存储临时变量和计算中的中间结果,默认情况下,所有局部变量都存储在私有内存中。

__kernel void myKernel() {

// 私有内存中的局部变量

float value;

// ...

}

内存一致模型的概念

内存一致性模型 (Memory Consistency Model) 是指在并行计算中多个处理器(或线程)之间共享内存时,对于读写操作的排序和可见性所做的规定。简而言之,它定义了多个处理器之间如何看到和交互共享内存中的数据。

在并行计算中,不同处理器的指令可能以不同的顺序执行,由于处理器之间的乱序执行和内存缓存等特性,会导致对共享内存的读写操作出现意想不到的结果。

内存一致性模型的目标是提供一种在多处理器系统上更直观、可理解和容易编程的内存访问模型。它规定了并发程序的行为,保证在多个处理器上的程序执行结果与按照程序顺序按照编写时的预期相同。

不同的内存一致性模型对于读写操作的排序和可见性规则有不同的定义,例如顺序一致性、弱一致性和松散一致性等。每个模型都有不同的权衡和适用场景,开发者需要根据具体的应用需求选择适合的内存一致性模型。

重要的是要意识到,内存一致性模型仅适用于共享内存并行计算模型,而对于分布式计算、消息传递和其他模型,通常存在不同的一致性模型和机制。

乱序执行

乱序执行(Out-of-Order Execution)是一种处理器执行指令的技术,其目的是提高指令级并行性和执行效率。传统上,处理器按照指令在程序中的顺序依次执行,但乱序执行允许处理器在程序中乱序地执行指令,只要保证最终执行结果与按照程序顺序执行的结果一致即可。

乱序执行的主要思想是将指令解耦合(decouple)成独立的微操作(micro-operations),并且通过利用硬件资源,如运算单元和内存子系统的并行性,重新调度和执行这些微操作,以最大限度地提高指令的并行执行效率。

乱序执行技术背后的原理是依赖于两个观察结果:数据依赖性和控制依赖性。数据依赖性指令之间的依赖关系,必须保证先后执行的正确顺序;而控制依赖性则是指条件分支指令(如if语句),根据分支的结果来确定下一条指令的执行顺序。

通过乱序执行技术,处理器可以检测到数据依赖性和控制依赖性,并根据实际情况进行指令重排序和并行执行,以充分利用硬件资源提高执行效率,但仍然保持程序的语义一致性。文章来源:https://www.toymoban.com/news/detail-688372.html

需要注意的是,乱序执行技术在处理器内部实现,对于外部看来,程序的执行结果应该与顺序执行的结果相同,即保证处理器对外部是透明的,并且符合指令集架构(ISA)的语义规范。文章来源地址https://www.toymoban.com/news/detail-688372.html

到了这里,关于【高性能计算】opencl语法及相关概念(三)事件,内存的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!