个人简历

·个人信息·____________________________________________________________

姓 名: 性 别:

年 龄: 工作经验:

学 历: 本科 (全日制) 专 业: 计算机科学与技术

籍 贯: 英语水平:

电 话: E-mail:

·求职意向·____________________________________________________________

目标薪资:面议

工作职位:大数据开发工程师

求职状态:离职

·IT技能·____________________________________________________________

一、大数据技术

1、能够搭建Hadoop并熟练使用相关技术HDFS、Yarn、MapReduce、Flume、Sqoop;

2、掌握Mapreduce作业调度原理,深入理解Mapreduce运算原理与Shuffle过程;

3、熟悉Spark工作流程,会使用Spark Sql进行数据处理和能够使用SparkStreaming进行流式计算;

4、能够使用消息中间件Kafka进行数据缓存;

5、掌握Zookeeper工作原理,并能够借助Zookeeper搭建HadoopHA集群、SparkHA;

6、熟悉全文检索Lucene、Elasticsearch;

7、能够使用反向代理Nginx进行请求的动静分离与服务器的负载均衡;

8、了解Storm架构,能使用Storm进行实时计算。

二、数据库相关技术

1、能够使用Hive和Hbase进行海量数据的分析处理;

2、能够操作MySQL数据库进行数据的存储;

3、熟悉MongoDB和Redis的使用。

三、编程语言

1、能够使用Java进行编程;

2、能够使用Scala进行Spark操作;

3、了解Shell脚本编程;

4、了解Python的基本使用。

四、其他

1、能够使用Spring、SprngMVC、SpringBoot、MyBatis等框架搭建项目;

2、熟悉Linux常用命令;

3、熟悉使用GitHub、Maven等开发工具。文章来源:https://www.toymoban.com/news/detail-688795.html

·工作经历·____________________________________________________________

2017年4月-2019年3月

公司行业:计算机软件 工作职位:大数据开发工程师

工作职责:

1、主要负责大数据分布式存储;

2、离线数据来源的分析,实时数据的计算;

3、数据采集、清洗等方案的设计。

·项目经验·____________________________________________________________

项目一:

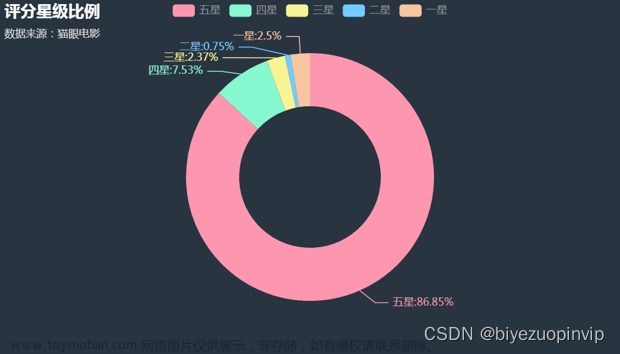

草民电影网数据分析 开发周期 2018年8月-2019年2月

技术实现:

Hadoop+Flume+Kafka+Mycat+Hive+Spark+SparkMLlib+

Redis+MongoDB+Elaticaserch

项目职务:大数据开发工程师

项目简介:

该项目是为电影网站进行收视统计,在用户观看的各类电视剧、电影节目中为了便于我们掌握用户哪个电视剧与电影更受观众欢迎,我们可以通过一些用户的观看情况进行监测,求出各类热门的电视剧与电影,实时的统计每天注册的人数。

项目职责:

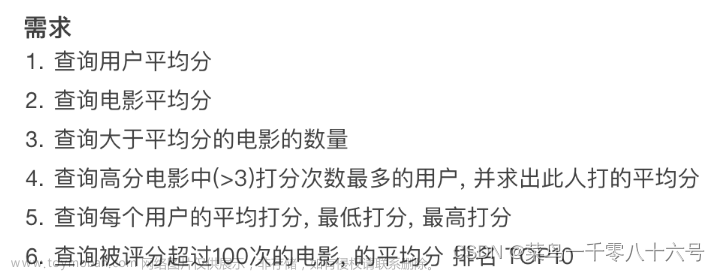

1、负责参与网站指标离线统计分析:如电影的平均得分统计、每个类别优质电影统计、最热们电影统计、优质电影统计等;

2、对数据进行采集,将数据清洗存入到Hdfs中;

3、利用Spark MLlib中的协同过滤ALS算法计算用户电影推荐矩阵、电影相似度矩阵;

4、使用ES计算出基于内容的推荐结果等。

技术要点:

1、Flume监控日志数据传输给Kafka;

2、Hadoop和ES分别从Kafka中拉取数据并进行实时的清洗入库;

3、利用SparkSql从Hadoop中拉取数据进行离线数据分析计算;

4、利用Spark Streaming从Kafka中拉取数据实时计算;

5、使用Spark MLlib的ALS推荐算法分析给用户推荐离线视频;

6、使用公司提供的算法流程计算实时推荐视频。

项目二:

游戏数据指标分析 开发周期 2018年4月-2018年8月

技术实现:

Hadoop+Zookeeper+Sqoop+Mycat+Hive+Kafka+Flume+Spark+Redis+Nginx+Hbase

项目职务:大数据开发工程师

项目简介:

通过对游戏数据的各项指标的分析,可以帮助游戏运维者了解玩家的行为和需求,通过玩家反馈的信息可以不断地矫正游戏中出现的问题,从而让游戏健康稳定的可持续运营。

项目职责:

1、统计活跃玩家:DAU、WAU、MAU、DAU/MAU,玩家等级、地区、年龄、性别维度分布;

2、统计忠实玩家(7、14、30持续在线)

3、统计玩家留存:次日、周及月留存玩家,玩家留存条件下等级,游戏次数、是否付费等

4、统计玩家流失(7、14、30持续不在线),当日回流玩家、流失玩家流失前等级、游戏次数、是否付费等情况。

技术要点:

1、Kafka从Nginx中获取数据;

2、使用Flume从Kafka拉取数据到Hdfs清洗入库;

3、利用SparkSql从Hdfs中拉取数据进行数据离线计算;

4、SparkStreaming从Kafka中拉取数据实时计算。

项目三:

周边游客流量数据分析 开发周期 2017年11月-2018年4月

技术实现:

Hadoop+Flume+Kafka+Hive+Mycat+Spark+Redis

项目职务:大数据开发工程师

项目简介:

该客流量分析系统是为周边游网站进行景区的客流量、热门景点进行环境分析、客源市场洞察、营销主题分析,经过分析得到的数据给前端进行显示,从而可以为网站提供日常决策支撑,比如某些旅游景点的人气很高的话,就可以为该景点做更多的推荐介绍。

项目职责:

数据的清洗操作;

离线指标的一些计算比如:

1、指定路线的年客流量统计;

2、交通方式月、年的人次统计;

3、成熟客源市场分析-地市、省份排名;

4、成熟景区市场分析-地市、省份排名;

5、成熟景区出入比分析-省份、城市排名;

6、潜在客源市转化率分析-地市排名。

技术要点:

1、使用Flume监控日志存入到Hdfs;

2、利用MR对数据进行清洗入库;

3、使用Sparksql从数据仓库中读取数据对数据进行分析;

4、Flume直接发送数据给Kafka,Sparkstream对接Kafka进行实时的计算。

·自我评价·____________________________________________________________

1、熟悉hadoop分布式存储,能利用自己写的MR程序去解决问题;

2、良好的学习和沟通组织能力;

3、技术上具备较好的独立完成模块和解决问题的能力;

4、适应能力好,能承受较强的工作压力,能够快速的融入团队;

5、对前沿技术比较敏感,非常乐于研究大数据相关的技术。文章来源地址https://www.toymoban.com/news/detail-688795.html

到了这里,关于真实大数据简历模版(四)【大数据-2年经验】电影网数据分析的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!