前言

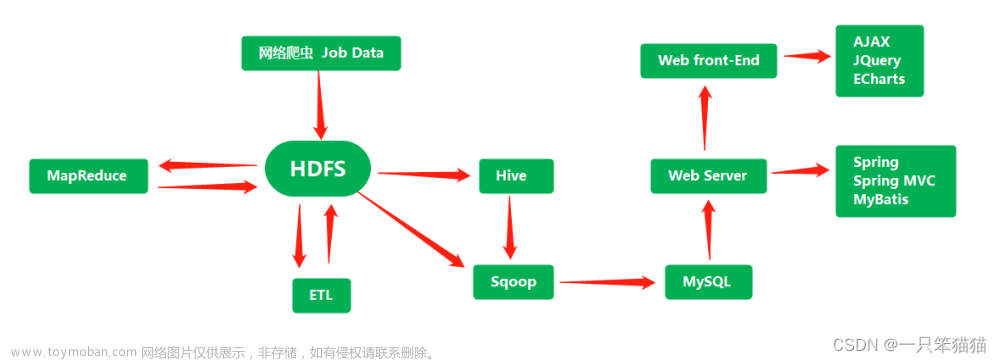

本节内容我们主要介绍一下大数据数据采集框架flume的安装部署,Flume 是一款流行的开源分布式系统,用于高效地采集、汇总和传输大规模数据。它主要用于处理大量产生的日志数据和事件流。Flume 支持从各种数据源(如日志文件、消息队列、数据库等)实时采集数据,并将其传输到目标存储或分析平台。Flume 采用基于拓扑结构的架构,可以通过配置多个组件(称为 Agent 或者节点)来实现数据的流动和处理。Agent 可以按照特定的方式连接,形成流式数据管道。Flume 的设计是基于事件驱动的,它将数据处理视为事件的流动。每个事件都被包装在一个可传输的容器中,沿着拓扑结构传递和转换。Flume 具有高度的容错性和可靠性,当发生故障或错误时,它能够自动恢复并保证数据不丢失。Flume 提供了丰富的配置选项,可以根据特定需求定义数据采集、转换和传输的逻辑。它还支持自定义插件来扩展功能。Flume 可以通过增加节点、调整拓扑结构和配置集群来实现水平扩展和负载均衡,以处理大规模的数据流。Flume 与其他大数据生态系统(如Hadoop、Spark等)无缝集成,可以方便地将采集到的数据传输到这些系统进行存储、处理和分析。

正文

-

上传flume安装包到服务器

- 解压flume安装包到/opt/module目录

- 命令:tar -zxvf apache-flume-1.9.0-bin.tar.gz -C /opt/module

- 修改apache-flume-1.9.0-bin名称为apache-flume-1.9.0

- 命令:mv apache-flume-1.9.0-bin/ apache-flume-1.9.0

- 将lib文件夹下的guava-11.0.2.jar删除以兼容Hadoop3.1.3

- 命令: rm guava-11.0.2.jar

- 分发apache-flume-1.9.0安装包到hadoop102和hadoop103服务器

- 验证flume是否安装成功

- 命令:bin/flume-ng

出现如下内容代表flume已经安装完毕

文章来源:https://www.toymoban.com/news/detail-689667.html

结语

至此,关于flume的安装部署到这里就结束了,更多关于flume的内容,我们下期见。。。。。。文章来源地址https://www.toymoban.com/news/detail-689667.html

到了这里,关于(十九)大数据实战——Flume数据采集框架安装部署的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!