在这篇文章中,我们将探讨Python爬虫中常见的代理池实现和优化方法。在爬取网站数据时,为防止被目标网站封禁IP,我们通常会使用代理IP进行访问。一个高效且稳定的代理池可以帮助我们轻松应对各种反爬策略。

首先,我们来了解一下代理池的基本概念:

-代理池:代理池是一个存储代理IP和端口的容器。它可以帮助我们在请求目标网站时自动切换代理,降低被封禁的风险。

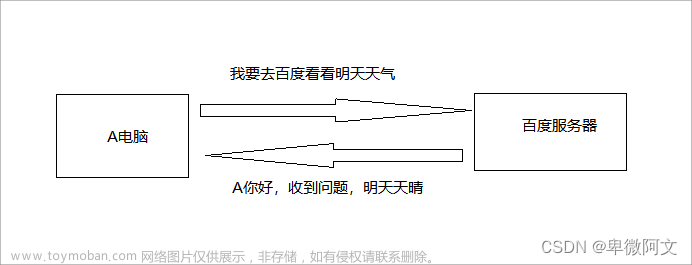

-代理IP:代理IP是指充当中间人的服务器,它可以将我们的请求转发给目标网站,从而隐藏我们真实的IP地址。

接下来,让我们探讨一下如何在Python中实现一个简单的代理池:

1.收集代理IP:首先,我们需要从免费或付费的代理提供商获取代理IP。我们可以编写一个爬虫程序,定期从这些网站抓取最新的代理IP,并存储到数据库或文件中。

2.验证代理IP:由于代理IP的质量参差不齐,我们需定期验证代理IP的有效性。我们可以编写一个验证程序,通过访问一些可靠的网站(如httpbin.org)来检测代理IP是否可用。

3.实现代理池:们可以使用Python的Flask框架搭建一个简单的RESTful API,提供获取代理IP和验证代理IP的接口。以下是一个简单的示例:

`

``python

from flask import Flask,jsonify

import random

app=Flask(__name__)

proxies=['123.45.67.89:8080','234.56.78.90:8080']

app.route('/get_proxy')

def get_proxy():

proxy=random.choice(proxies)

return jsonify({'proxy':proxy})

if __name__=='__main__':

app.run()

```

4.使用代理池:在爬虫程序中,我们可以使用requests库搭配代理池来发送请求。以下是一个简单的示例:文章来源:https://www.toymoban.com/news/detail-690350.html

```python

import requests

def get_proxy():

response=requests.get('http://localhost:5000/get_proxy')

return response.json()['proxy']

def fetch(url):

proxy=get_proxy()

proxies={'http':f'http://{proxy}','https':f'https://{proxy}'}

response=requests.get(url,proxies=proxies)

return response.text

url='http://example.com'

content=fetch(url)

print(content)

```

最后,我们来讨论一下如何优化代理池:

1.定期更新代理IP:为了保持代理池的有效性,我们需要定期从代理提供商获取最新的代理IP,并删除失效的代理IP。

2.优化验证策略:我们可以根据代理IP的响应时间、成功率等指标对代理IP进行评分,并优先使用高分代理IP。

3.并发验证:为了提高验证效率,我们可以使用多线程或多进程并发验证代理IP。

4.异常处理:在爬虫程序中,我们需要处理各种网络异常(如超时、连接失败等),并在遇到异常时自动切换代理IP。

实现和优化一个高效且稳定的代理池对于应对网站的反爬策略至关重要,希望本文能对您在实际项目中更好地使用代理池有所帮助。文章来源地址https://www.toymoban.com/news/detail-690350.html

到了这里,关于Python爬虫常见代理池实现和优化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!