搭建单机 Hadoop 和 Spark 环境可以学习和测试大数据处理的基础知识。在 Windows 操作系统上搭建这两个工具需要一些配置和设置,下面是一个详细的教程:

注意: 在开始之前,请确保你已经安装了 Java 开发工具包(JDK),并且已经下载了 Hadoop 和 Spark 的最新版本。你可以从官方网站或镜像站点获取它们。

步骤 1:安装和配置 Java

-

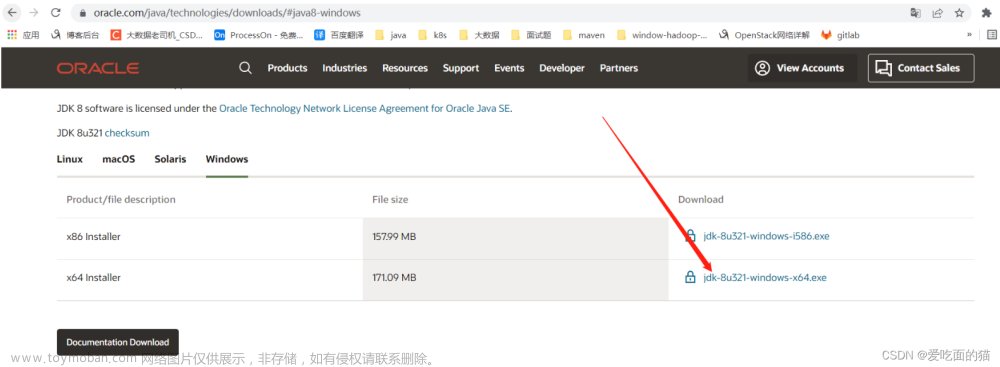

下载并安装 Oracle JDK 或 OpenJDK 的最新版本。你可以从 Oracle 官网或 OpenJDK 的官方网站下载。

-

设置系统环境变量:文章来源:https://www.toymoban.com/news/detail-691147.html

- 在 Windows 桌面上,右键点击 “此电脑” 并选择 “属性”。

- 点击 “高级系统设置”。

- 在 “高级” 选项卡下,点击 “环境变量” 按钮。

- 在 “系统变量” 部分,点击 “新建”。

- 输入变量名为

JAVA_HOME,变量值为你的 Java 安装路径,通常为C:\Program Files\Java\jdk1.x.x_xxx。 - 在 “系统变量” 中找到 “Path” 变量,点击 “编辑”。

- 在变量值的末尾添加

;%JAVA_HOME%\bin并保存。

添加 %JAVA_HOME%\bin 和 .;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.ja文章来源地址https://www.toymoban.com/news/detail-691147.html

到了这里,关于2 | Window 搭建单机 Hadoop 和Spark的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!