1.hive下载:Index of /dist/hive/hive-1.2.1

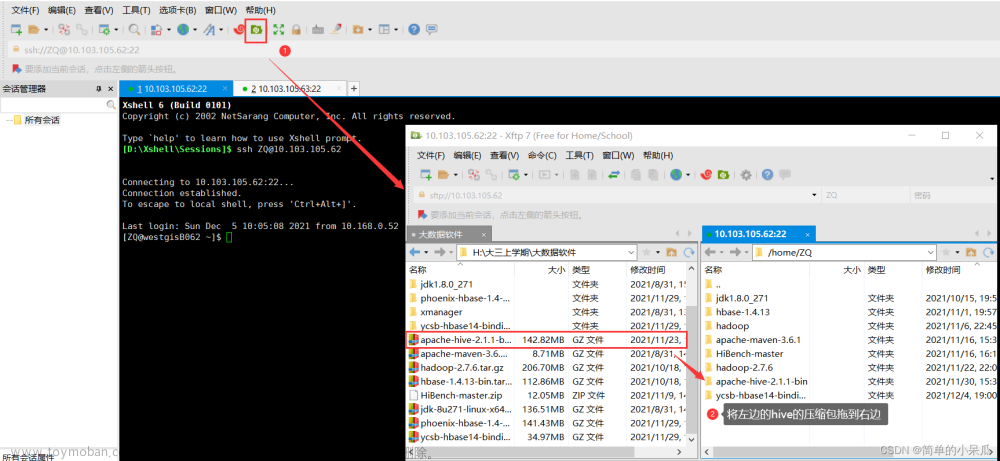

或者上传安装包至/opt/software:rz或winscp上传

2.解压

cd /opt/software

tar -xzvf apache-hive-1.2.1-bin.tar.gz -C /opt/servers/

3.重命名

mv apache-hive-1.2.1-bin hive

4.配置环境变量

vi /etc/profile

export HIVE_HOME=/opt/servers/hive

export PATH=$PATH:$HIVE_HOME/bin

source /etc/profile

5.修改hive-env.sh配置文件,配置Hadoop环境变量

cd /opt/servers/hive/conf

cp hive-env.sh.template hive-env.sh

vi hive-env.sh

//添加如下信息

export JAVA_HOME=/opt/servers/jdk

export HADOOP_HOME=/opt/servers/hadoop

export HIVE_HOME=/opt/servers/hive

export HIVE_CONF_DIR=/opt/servers/hive/conf

6.添加hive-site.xml配置文件,配置MySQL相关信息

vi hive-site.xml

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<configuration>

<property>

#指定HDFS内hive数据临时文件存放目录。启动hive,HDFS即自动创建

<name>hive.exec.scratchdir</name>

<value>/user/hive/tmp</value>

</property>

<property>

#指定HDFS内hive数据存放目录。HDFS自动创建

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<property>

#指定hive查询日志本地存放目录

<name>hive.querylog.location</name>

<value>/user/hive/log</value>

</property>

## 配置 MySQL 数据库连接信息

<property>

<!-- 元数据库的链接地址 mysql -->

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://hadoop01:3306/hive?createDatabaseIfNotExist=true&characterEncoding=UTF-8&useSSL=false&serverTimezone=GMT</value>

</property>

<property>

<!-- 指定mysql驱动 -->

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<!-- 指定mysql用户名 -->

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<!-- 指定mysql密码 请输入自己的MySQL连接密码 -->

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

</configuration>

启动集群

start-all.sh

7.在hdfs 中创建下面的目录 ,并且授权

hdfs dfs -mkdir -p /user/hive/warehouse

hdfs dfs -mkdir -p /user/hive/tmp

hdfs dfs -mkdir -p /user/hive/log

hdfs dfs -chmod -R 777 /user/hive/warehouse

hdfs dfs -chmod -R 777 /user/hive/tmp

hdfs dfs -chmod -R 777 /user/hive/log

8.上传mysql驱动

cd /opt/servers/hive/lib

传mysql驱动

创建临时目录:

mkdir /opt/servers/hive/tmp

9. 初始化MySQL数据库

cd /opt/servers/hive/bin

schematool -dbType mysql -initSchema

(schemaTool completed出现这一句说明成功)

{若运行schematool -dbType mysql -initSchema 显示没有找到命令则大概率是环境变量有问题}

{

若运行schematool -dbType mysql -initSchema 没有成功

1.看Navicat for MySQL是否可以连接mysql

2.在mysql命令窗口中查看是否有hive这个库

show databases;

drop database hive;(有就要删除掉)

}

10.查看现在的hadoop中的HDFS存了什么

hadoop fs -lsr /

11.进入hive并创建一个测试库和测试表

[root@hadoop01 conf]$ hive

hive> create database hive1;

hive> show databases;

12.查看mysql的hive数据库变化

[root@hadoop01 conf]$ mysql -u root -p

切换成hive数据库并查看DBS表

mysql> use hive;

mysql> select * from DBS;

13.复制hive到hadoop02和hadoop03

scp -r /opt/servers/hive/ hadoop02:/opt/servers/

scp -r /opt/servers/hive/ hadoop03:/opt/servers/

14.在hadoop01服务器上启动hiveserver2

hiveserver2

15.在hadoop02上执行

cd /opt/servers/hive

bin/beeline

beeline> !connect jdbc:hive2://hadoop01:10000

Enter username for jdbc:hive2://hadoop01:10000: root文章来源:https://www.toymoban.com/news/detail-692584.html

Enter password for jdbc:hive2://hadoop01:10000: ***文章来源地址https://www.toymoban.com/news/detail-692584.html

到了这里,关于我的私人笔记(安装hive)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!