导语

标签是一种用于描述和分类博客内容的元数据,它可以帮助读者快速找到感兴趣的主题,也可以提高博客的搜索引擎优化(SEO)。然而,手动为每篇博客文章添加合适的标签是一件费时费力的工作,有时候也容易遗漏或重复。本文将介绍如何使用Puppeteer这个强大的Node.js库来构建一个博客内容的自动标签生成器,它可以根据博客文章的标题和正文内容,自动提取出最相关的标签,并保存到数据库中。

概述

Puppeteer是一个Node.js库,它提供了一个高级API来控制Chrome或Chromium浏览器。使用Puppeteer,我们可以实现各种浏览器自动化任务,例如网页抓取、网页截图、网页测试、PDF生成等。Puppeteer的核心功能是创建一个Browser对象,它代表了一个浏览器实例,然后通过Browser对象创建一个或多个Page对象,它代表了一个浏览器标签页。通过Page对象,我们可以对网页进行各种操作,例如导航、点击、输入、等待等。

为了构建一个博客内容的自动标签生成器,我们需要使用Puppeteer来完成以下步骤:

- 启动一个浏览器实例,并设置代理IP和User-Agent等选项,以提高爬虫效果和防止被目标网站屏蔽。

- 创建一个浏览器标签页,并打开目标博客网站的首页。

- 获取首页上所有博客文章的链接,并保存到一个数组中。

- 遍历数组中的每个链接,打开对应的博客文章页面,并获取文章的标题和正文内容。

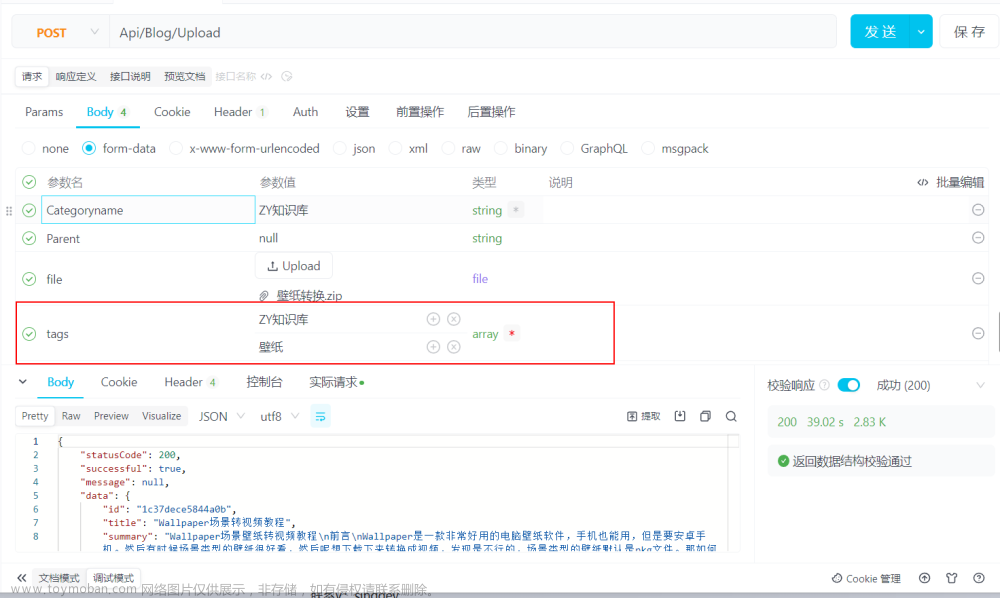

- 使用一个第三方API(例如[Text Analysis API])来对文章的标题和正文内容进行自然语言处理(NLP),并返回最相关的标签。

- 将文章的链接、标题、正文内容和标签保存到数据库中(例如[MongoDB])。

- 关闭浏览器实例,并结束程序。

正文

下面我们来具体看看如何使用Puppeteer来实现上述步骤。

1. 启动浏览器实例

首先,我们需要安装Puppeteer这个Node.js库,可以使用npm命令:

npm install puppeteer

然后,在我们的JavaScript文件中,我们需要引入Puppeteer模块,并使用puppeteer.launch()方法来启动一个浏览器实例。这个方法接受一个可选的配置对象作为参数,我们可以在这里设置代理IP等选项。例如,我们可以使用亿牛云提供的爬虫代理IP服务,它可以帮助我们隐藏真实IP地址,并提供不同地区和运营商的IP资源。我们只需要在亿牛云爬虫代理官网注册一个账号,并获取相应的域名、端口、用户名和密码,然后在puppeteer.launch()方法中设置args属性和headless属性即可。args属性是一个数组,用于传递给浏览器进程的命令行参数。其中--proxy-server参数用于设置代理服务器地址,格式为protocol://username:password@host:port。headless属性是一个布尔值,用于设置是否以无头模式运行浏览器,即是否显示浏览器界面。如果设置为false,则可以看到浏览器的操作过程,方便调试。我们还可以设置userAgent属性,用于设置浏览器的用户标识字符串,以模拟不同的浏览器和设备类型。例如,我们可以使用[User-Agent Switcher]这个Chrome扩展程序来获取不同的用户标识字符串,并随机选择一个作为参数。下面是一个示例代码:

// 引入Puppeteer模块

const puppeteer = require('puppeteer');

// 定义亿牛云爬虫代理的域名、端口、用户名和密码

const proxyHost = 'http://www.16yun.cn';

const proxyPort = '8100';

const proxyUser = '16YUN';

const proxyPass = '16IP';

// 定义一个用户标识字符串数组

const userAgents = [

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Safari/537.36',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/14.1.2 Safari/605.1.15',

'Mozilla/5.0 (iPhone; CPU iPhone OS 14_7_1 like Mac OS X) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/14.0 Mobile/15E148 Safari/604.1',

'Mozilla/5.0 (Linux; Android 11; SM-G998B) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Mobile Safari/537.36'

];

// 随机选择一个用户标识字符串

const userAgent = userAgents[Math.floor(Math.random() * userAgents.length)];

// 启动一个浏览器实例,并设置亿牛云爬虫代理

(async () => {

const browser = await puppeteer.launch({

args: [`--proxy-server=${proxyUser}:${proxyPass}@${proxyHost}:${proxyPort}`],

headless: false,

userAgent: userAgent

});

})();

2. 创建浏览器标签页,并打开目标博客网站的首页

启动浏览器实例后,我们可以使用browser.newPage()方法来创建一个新的浏览器标签页,并返回一个Page对象。然后,我们可以使用page.goto()方法来打开目标博客网站的首页,并等待页面加载完成。这个方法接受一个URL字符串作为参数,以及一个可选的配置对象,其中可以设置waitUntil属性,用于指定何时认为页面导航完成。我们可以设置为networkidle2,表示当网络连接数小于等于2时,认为页面导航完成。下面是一个示例代码:

// 创建一个新的浏览器标签页,并返回一个Page对象

const page = await browser.newPage();

// 定义目标博客网站的首页URL

const blogUrl = 'https://example.com';

// 打开目标博客网站的首页,并等待页面加载完成

await page.goto(blogUrl, {waitUntil: 'networkidle2'});

3. 获取首页上所有博客文章的链接,并保存到一个数组中

打开目标博客网站的首页后,我们可以使用page.$$eval()方法来获取首页上所有博客文章的链接,并保存到一个数组中。这个方法接受两个参数,第一个参数是一个选择器字符串,用于指定要匹配的元素;第二个参数是一个回调函数,用于对匹配到的元素进行操作,并返回结果。例如,我们可以使用CSS选择器a.post-link来匹配所有包含博客文章链接的a元素;然后在回调函数中,我们可以使用Array.from()方法来将匹配到的元素转换为数组

4. 遍历数组中的每个链接,打开对应的博客文章页面,并获取文章的标题和正文内容

获取到首页上所有博客文章的链接后,我们可以使用for...of循环来遍历数组中的每个链接,然后使用page.goto()方法来打开对应的博客文章页面,并等待页面加载完成。然后,我们可以使用page.$eval()方法来获取文章的标题和正文内容,并保存到一个对象中。这个方法接受两个参数,第一个参数是一个选择器字符串,用于指定要匹配的元素;第二个参数是一个回调函数,用于对匹配到的元素进行操作,并返回结果。例如,我们可以使用CSS选择器h1.post-title来匹配文章的标题元素;然后在回调函数中,我们可以使用element.textContent属性来获取元素的文本内容,并返回结果。同理,我们可以使用CSS选择器div.post-content来匹配文章的正文内容元素,并返回结果。下面是一个示例代码:

// 定义一个空数组,用于存放所有博客文章的信息

const posts = [];

// 遍历数组中的每个链接

for (const link of links) {

// 打开对应的博客文章页面,并等待页面加载完成

await page.goto(link, {waitUntil: 'networkidle2'});

// 获取文章的标题和正文内容,并保存到一个对象中

const post = await page.$eval('h1.post-title', element => {

return {

title: element.textContent, // 获取元素的文本内容

content: element.nextElementSibling.textContent // 获取元素的下一个兄弟元素(正文内容元素)的文本内容

};

});

// 将对象添加到数组中

posts.push(post);

}

5. 使用一个第三方API来对文章的标题和正文内容进行自然语言处理,并返回最相关的标签

获取到所有博客文章的标题和正文内容后,我们可以使用一个第三方API来对文章的标题和正文内容进行自然语言处理,并返回最相关的标签。这里我们可以使用[Text Analysis API]这个免费的API服务,它提供了多种自然语言处理功能,例如情感分析、关键词提取、实体识别、摘要生成等。我们可以使用它提供的关键词提取功能,来根据文章的标题和正文内容,自动提取出最相关的标签,并返回一个数组。为了使用这个API服务,我们需要先在[Text Analysis API]官网注册一个账号,并获取一个API密钥(API Key)。然后,我们可以使用Node.js内置的[http]模块来发送HTTP请求,并处理响应结果。下面是一个示例代码:

// 引入http模块

const http = require('http');

// 定义Text Analysis API的URL和API密钥

const apiUrl = 'http://api.meaningcloud.com/topics-2.0';

const apiKey = '0123456789abcdef0123456789abcdef';

// 定义一个函数,用于发送HTTP请求,并返回一个Promise对象

function request(options, data) {

return new Promise((resolve, reject) => {

// 创建一个HTTP请求对象

const req = http.request(options, res => {

// 定义一个空字符串,用于存放响应数据

let body = '';

// 监听data事件,将响应数据拼接到字符串中

res.on('data', chunk => {

body += chunk;

});

// 监听end事件,将字符串转换为JSON对象,并调用resolve函数

res.on('end', () => {

resolve(JSON.parse(body));

});

});

// 监听error事件,调用reject函数

req.on('error', err => {

reject(err);

});

// 将请求数据写入请求对象中

req.write(data);

// 结束请求

req.end();

});

}

// 定义一个函数,用于对文章的标题和正文内容进行自然语言处理,并返回最相关的标签

async function getTags(title, content) {

// 定义请求选项,包括请求方法、请求头和请求路径

const options = {

method: 'POST',

headers: {

'Content-Type': 'application/x-www-form-urlencoded'

},

path: apiUrl

};

// 定义请求数据,包括API密钥、语言、文章标题和文章正文内容

const data = `key=${apiKey}&lang=en&txt=${title} ${content}&tt=a`;

// 发送HTTP请求,并等待响应结果

const response = await request(options, data);

// 定义一个空数组,用于存放最相关的标签

const tags = [];

// 判断响应结果的状态码是否为0,表示成功

if (response.status.code === '0') {

// 遍历响应结果中的实体数组,提取每个实体的名称,并添加到标签数组中

for (const entity of response.entity_list) {

tags.push(entity.form);

}

}

// 返回标签数组

return tags;

}

6. 将文章的链接、标题、正文内容和标签保存到数据库中

获取到所有博客文章的链接、标题、正文内容和标签后,我们可以将它们保存到数据库中,以便后续的使用和分析。这里我们可以使用[MongoDB]这个免费的开源数据库,它是一种基于文档的数据库,适合存储JSON格式的数据。为了使用[MongoDB],我们需要先在[MongoDB]官网注册一个账号,并创建一个云数据库集群(Cluster)。然后,我们可以使用[MongoDB Node.js Driver]这个Node.js库来连接和操作数据库。为了使用这个库,我们需要先安装它,可以使用npm命令:

npm install mongodb

然后,在我们的JavaScript文件中,我们需要引入MongoDB模块,并使用MongoClient类来创建一个客户端对象。然后,我们可以使用client.connect()方法来连接数据库,并返回一个Promise对象。这个方法接受一个URL字符串作为参数,用于指定数据库的地址和配置选项。我们可以在[MongoDB]官网获取到这个URL字符串,并替换其中的用户名和密码。然后,在Promise对象的回调函数中,我们可以使用client.db()方法来获取一个数据库对象,并指定数据库的名称;然后使用db.collection()方法来获取一个集合对象,并指定集合的名称。集合相当于关系型数据库中的表,用于存储文档(Document)。然后,我们可以使用collection.insertMany()方法来将所有博客文章的信息作为文档插入到集合中,并返回一个Promise对象。这个方法接受一个数组作为参数,数组中的每个元素都是一个文档对象。最后,在Promise对象的回调函数中,我们可以打印出插入结果,并关闭数据库连接。下面是一个示例代码:

// 引入MongoDB模块

const { MongoClient } = require('mongodb');

// 定义MongoDB的URL字符串

const mongoUrl = 'mongodb+srv://username:password@cluster0.example.com/mydb';

// 创建一个客户端对象

const client = new MongoClient(mongoUrl);

// 连接数据库,并返回一个Promise对象

client.connect().then(() => {

// 获取一个数据库对象,并指定数据库名称

const db = client.db('mydb');

// 获取一个集合对象,并指定集合名称

const collection = db.collection('posts');

// 将所有博客文章的信息作为文档插入到集合中,并返回一个Promise对象

collection.insertMany(posts).then(result => {

// 打印出插入结果

console.log(result);

// 关闭数据库连接

client.close();

});

});

7. 关闭浏览器实例,并结束程序

完成所有操作后,我们可以使用browser.close()方法来关闭浏览器实例,并结束程序。文章来源:https://www.toymoban.com/news/detail-695714.html

结语

本文介绍了如何使用Puppeteer这个强大的Node.js库来构建一个博客内容的自动标签生成器,它可以根据博客文章的标题和正文内容,自动提取出最相关的标签,并保存到数据库中。这样,我们就可以省去手动为每篇博客文章添加合适的标签的工作,也可以提高博客的搜索引擎优化(SEO)。文章来源地址https://www.toymoban.com/news/detail-695714.html

到了这里,关于使用Puppeteer构建博客内容的自动标签生成器的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!