一、前言

在进行网络爬虫的开发过程中,有许多限制因素阻碍着爬虫程序的正常运行,其中最主要的一点就是反爬虫机制。为了防止爬虫程序在短时间内大量地请求同一个网站,网站管理者会使用一些方式进行限制。这时候,代理IP就是解决方案之一。

本文主要介绍如何在爬虫程序中使用代理IP以应对反爬虫机制,以及如何进行访问控制,保障程序的正常运行。

二、什么是代理IP

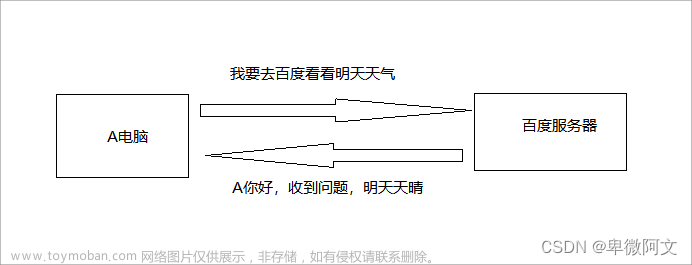

代理IP即为代理服务器的IP地址,在爬虫程序中,我们可以使用代理IP来隐藏真实的IP地址,从而达到访问网站的目的。使用代理IP可以解决以下问题:

- 突破访问限制:有些网站会限制某些地区的访问,使用代理IP可以突破这些限制。

- 绕过反爬虫机制:有些网站会根据同一IP访问频率的高低来判断是否为爬虫行为,使用代理IP可以隐藏真实IP地址,从而防止被封禁或检测。

- 提高访问速度:使用代理IP可以使得请求被代理服务器缓存,从而提高访问速度。

三、如何获取代理IP

有许多免费或收费的代理IP提供商,我们可以在这些网站上获取代理IP,这里推荐一个:

站大爷代理ip:https://www.zdaye.com

获取代理IP后,我们需要进行有效性检测、筛选和存储,以确保代理IP的可用性。

下面是一个Python代码示例,可以实现对代理IP的有效性检测并存储可用的代理IP:

import requests

import time

def check_proxy(proxy):

"""

检测代理IP的有效性

:param proxy: 代理IP

:return: True or False

"""

proxies = {

'http': proxy,

'https': proxy,

}

try:

response = requests.get('https://www.baidu.com/', proxies=proxies, timeout=5)

if response.status_code == 200:

return True

else:

return False

except:

return False

def save_proxy(ip, port, protocol='http'):

"""

存储可用代理IP

:param ip: IP地址

:param port: 端口号

:param protocol: 协议类型

:return: None

"""

with open('proxies.txt', 'a+', encoding='utf-8') as f:

f.write('{}://{}:{}\n'.format(protocol, ip, port))

def main():

for page in range(1, 11): # 获取前10页的代理IP

url = 'https://www.zdaye.com/nn/{}'.format(page)

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/89.0.4389.82 Safari/537.36'

}

response = requests.get(url, headers=headers)

if response.status_code == 200:

html = response.text

proxy_list = html.split('\n')

for proxy in proxy_list:

if proxy:

ip = proxy.split(':')[0]

port = proxy.split(':')[1]

if check_proxy(proxy):

save_proxy(ip, port)

if __name__ == '__main__':

main()

print('Done!')上述代码使用了requests库来请求代理IP网站,获取到代理IP后进行有效性检测,并将可用的代理IP存储到本地文件中。

四、如何应用代理IP

在爬虫程序中使用代理IP,可以使用requests库提供的proxies参数,示例代码如下:

import requests

def get_page(url, proxy):

"""

使用代理IP请求网页

:param url: 网页url

:param proxy: 代理IP

:return: 网页内容

"""

proxies = {

'http': proxy,

'https': proxy,

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/89.0.4389.82 Safari/537.36'

}

try:

response = requests.get(url, headers=headers, proxies=proxies, timeout=10)

if response.status_code == 200:

return response.text

else:

return None

except:

return None

def main():

url = 'https://www.baidu.com/'

proxy = 'http://121.69.46.218:9000'

page = get_page(url, proxy)

print(page)

if __name__ == '__main__':

main()上述代码使用了requests库提供的proxies参数,将代理IP传入访问请求中,从而实现了使用代理IP请求网页的功能。

五、如何进行访问控制

在使用代理IP进行访问时,我们需要进行访问控制,以确保程序的正常运行。具体来说,我们可以通过以下方式进行访问控制:

- 控制请求频率:通过设置时间间隔、请求次数等方式,控制爬虫的访问速度,避免给网站带来过大的压力。

- 轮流使用代理IP:通过存储多个可用的代理IP,并轮流使用它们,以分散访问压力。

- 随机使用代理IP:从可用代理IP池中随机选择一个进行使用,增加反爬虫的难度。

下面是一个Python代码示例,可以实现访问控制并轮流使用代理IP:

import requests

import time

def get_proxy():

"""

从代理IP池中取出一个代理IP

:return: 代理IP

"""

proxy_list = []

with open('proxies.txt', 'r', encoding='utf-8') as f:

for line in f:

proxy = line.strip()

proxy_list.append(proxy)

return proxy_list[0]

def check_proxy(proxy):

"""

检测代理IP的有效性

:param proxy: 代理IP

:return: True or False

"""

proxies = {

'http': proxy,

'https': proxy,

}

try:

response = requests.get('https://www.baidu.com/', proxies=proxies, timeout=5)

if response.status_code == 200:

return True

else:

return False

except:

return False

def save_proxy(ip, port, protocol='http'):

"""

存储可用代理IP

:param ip: IP地址

:param port: 端口号

:param protocol: 协议类型

:return: None

"""

with open('proxies.txt', 'a+', encoding='utf-8') as f:

f.write('{}://{}:{}\n'.format(protocol, ip, port))

def rotate_proxy():

"""

从代理IP池中轮流取出一个代理IP

:return: 代理IP

"""

proxy_list = []

with open('proxies.txt', 'r', encoding='utf-8') as f:

for line in f:

proxy = line.strip()

proxy_list.append(proxy)

while True:

for proxy in proxy_list:

yield proxy

def main():

proxy_generator = rotate_proxy()

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/89.0.4389.82 Safari/537.36'

}

for i in range(10): # 控制访问次数

proxy = next(proxy_generator)

while not check_proxy(proxy): # 检测代理IP是否可用

proxy = next(proxy_generator)

try:

url = 'https://www.baidu.com/'

response = requests.get(url, headers=headers, proxies={'http': proxy, 'https': proxy}, timeout=10)

if response.status_code == 200:

print(response.text)

except:

pass

time.sleep(1) # 控制请求间隔

if __name__ == '__main__':

main()

print('Done!')上述代码使用了生成器和yield语句实现了轮流取出可用代理IP的功能,并增加了时间间隔控制,确保爬虫程序不会过于频繁地请求。同时,代码也实现了对代理IP的有效性检测,确保使用的代理IP都是可用的。文章来源:https://www.toymoban.com/news/detail-696158.html

六、总结

本文主要介绍了如何在爬虫程序中使用代理IP进行反爬虫机制的应对,以及如何进行访问控制,保障程序的正常运行。实现代理IP使用和访问控制需要理解网络爬虫的原理和反爬虫机制,同时应当遵守网站的访问规则,以确保不会对网站造成过大的负担。文章来源地址https://www.toymoban.com/news/detail-696158.html

到了这里,关于【Python爬虫笔记】爬虫代理IP与访问控制的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!