解决过拟合问题是机器学习和深度学习中关键的任务之一,因为它会导致模型在训练数据上表现良好,但在未见数据上表现不佳。以下是一些解决过拟合问题的常见方法:

-

增加训练数据:

增加更多的训练数据可以帮助模型更好地捕捉数据的真实分布,减少过拟合的可能性。如果可行,收集更多的数据通常是解决过拟合的最佳方法。 -

简化模型:

减小模型的复杂性,例如减少神经网络中的层数或神经元数量,可以降低过拟合风险。选择一个更简单的模型结构可以使模型更容易泛化到新数据。 -

正则化:

使用正则化技术,如L1正则化和L2正则化,以限制模型参数的大小。这有助于防止模型在训练数据上学习到噪声或不必要的细节。 -

丢弃法(Dropout):

在神经网络中引入丢弃层,随机地关闭一部分神经元,以减少神经网络对特定神经元的依赖性。这有助于防止神经网络过度拟合。 -

交叉验证:

使用交叉验证来评估模型的性能。这可以帮助您更好地了解模型在未见数据上的表现,并可能识别出过拟合问题。 -

特征选择:

选择最相关和最有信息量的特征,以减小输入数据的维度。删除不相关或冗余的特征有助于降低模型的复杂性。 -

集成学习:

使用集成学习方法,如随机森林或梯度提升树,可以将多个模型的预测结果结合起来,以提高模型的泛化性能。 -

早停法(Early Stopping):

在训练过程中监测模型在验证集上的性能,并在性能不再改善时停止训练,以防止模型在训练数据上过度拟合。 -

数据增强:

对训练数据进行随机变换、旋转、翻转等操作,以扩充训练数据集,有助于提高模型的泛化能力。 -

深度监督:

在深度神经网络中添加额外的监督任务,以引导模型学习更有用的特征表示,减少过拟合。

通常,解决过拟合问题需要根据具体情况采用多种方法的组合,这取决于数据、模型和任务的特点。选用合适的方法可以帮助提高模型的性能并减小过拟合的影响。

一、正则化:

1、 正则化(Regularization)是机器学习和统计建模中的一种技术,用于减小模型的复杂性,防止过拟合(Overfitting)的发生。过拟合是指模型在训练数据上表现得非常好,但在新的、未见过的数据上表现较差的情况。

正则化的目标是通过对模型的参数或权重进行一定的约束,以限制模型在训练数据上的拟合能力,从而提高模型在未见数据上的泛化能力。常见的正则化方法包括以下两种:

-

L1 正则化(Lasso 正则化):L1正则化通过在损失函数中添加参数的绝对值之和,通常表示为λ * ∑|θi|,其中θi是模型的权重参数,λ是正则化强度超参数。L1正则化有助于稀疏特征选择,可以将一些不重要的特征的权重归零,从而减小模型的复杂性。

-

L2 正则化(Ridge 正则化):L2正则化通过在损失函数中添加参数的平方和,通常表示为λ * ∑θi^2,同样,θi是模型的权重参数,λ是正则化强度超参数。L2正则化有助于减小参数的大小,防止参数过大,从而减小模型的过拟合风险。

这些正则化方法可以单独使用,也可以结合使用,形成L1和L2的混合正则化,通常称为弹性网络(Elastic Net)。正则化方法的选择取决于具体的问题和数据集,以及模型的性能需求。

总之,正则化是一种用于改善机器学习模型泛化能力的重要技术,它有助于防止模型在训练数据上过度拟合,提高模型在未见数据上的性能。

二、正则化和权重衰退:

正则化和权重衰减是在机器学习和深度学习中用于控制模型复杂性和防止过拟合的两种相关但不完全相同的概念。

-

正则化(Regularization):

- 正则化是一种广泛的概念,旨在通过添加额外的约束或惩罚项来限制模型的复杂性。

- 正则化可应用于各种机器学习模型,包括线性回归、逻辑回归、支持向量机和深度神经网络等。

- 常见的正则化方法包括L1正则化和L2正则化,它们分别通过添加权重的绝对值和平方和的项来约束模型参数。

- 正则化有助于减小模型的方差,防止过拟合,提高在未见数据上的泛化性能。

-

权重衰减(Weight Decay):

- 权重衰减是一种特定于神经网络的正则化方法,通常用于深度学习模型。

- 在神经网络中,权重衰减等效于L2正则化,它通过将模型的损失函数中的权重的平方和添加到目标函数中,以限制权重的大小。

- 相对于其他正则化方法,权重衰减更常用于神经网络训练。

- 权重衰减有助于控制神经网络的复杂性,减少过拟合风险,使模型的权重趋向于较小的值。

虽然正则化和权重衰减的目标都是减小过拟合风险,但正则化是一个更通用的概念,可以应用于多种机器学习模型,而权重衰减是特定于神经网络的正则化技术。在深度学习中,通常使用权重衰减作为一种有效的正则化方法,以控制神经网络的参数大小,提高泛化性能。

三、正则化与丢弃法:

正则化(Regularization)和丢弃法(Dropout)都是用于防止神经网络过拟合的技术,但它们的机制和应用方式不同。

-

正则化(Regularization):

- 正则化是一种广义的概念,旨在通过对模型参数的添加约束来减小模型的复杂性,从而防止过拟合。

- 常见的正则化方法包括L1正则化和L2正则化,它们通过在损失函数中添加额外的项,分别是权重参数的绝对值和平方和,来对模型的参数进行约束。

- 正则化的目标是降低模型在训练数据上的拟合程度,以提高在未见数据上的泛化能力。

-

丢弃法(Dropout):

- 丢弃法是一种特定于神经网络的正则化技术,其目标是通过在训练期间随机关闭一部分神经元(节点)来减小神经网络的复杂性。

- 在每个训练迭代中,丢弃法将一些神经元的输出设置为零,以模拟神经元的“丢弃”,这些丢弃的神经元在该迭代中不参与前向传播和反向传播。

- 丢弃法强制神经网络在不依赖于特定神经元的情况下学习,从而减少了神经网络对某些特定特征的依赖,提高了模型的鲁棒性和泛化性能。

虽然正则化和丢弃法都旨在减小过拟合风险,但它们的操作方式和应用范围不同。正则化可以应用于各种机器学习模型,并通过限制参数的大小来减小模型复杂性,而丢弃法是一种特定于神经网络的技术,通过在训练期间随机关闭神经元来减少网络复杂性。在实践中,通常会将这两种技术结合使用,以更有效地控制神经网络的过拟合问题。

简单说,系统性减少权重大小,然后把一些权重特别小的节点丢弃(dropout)

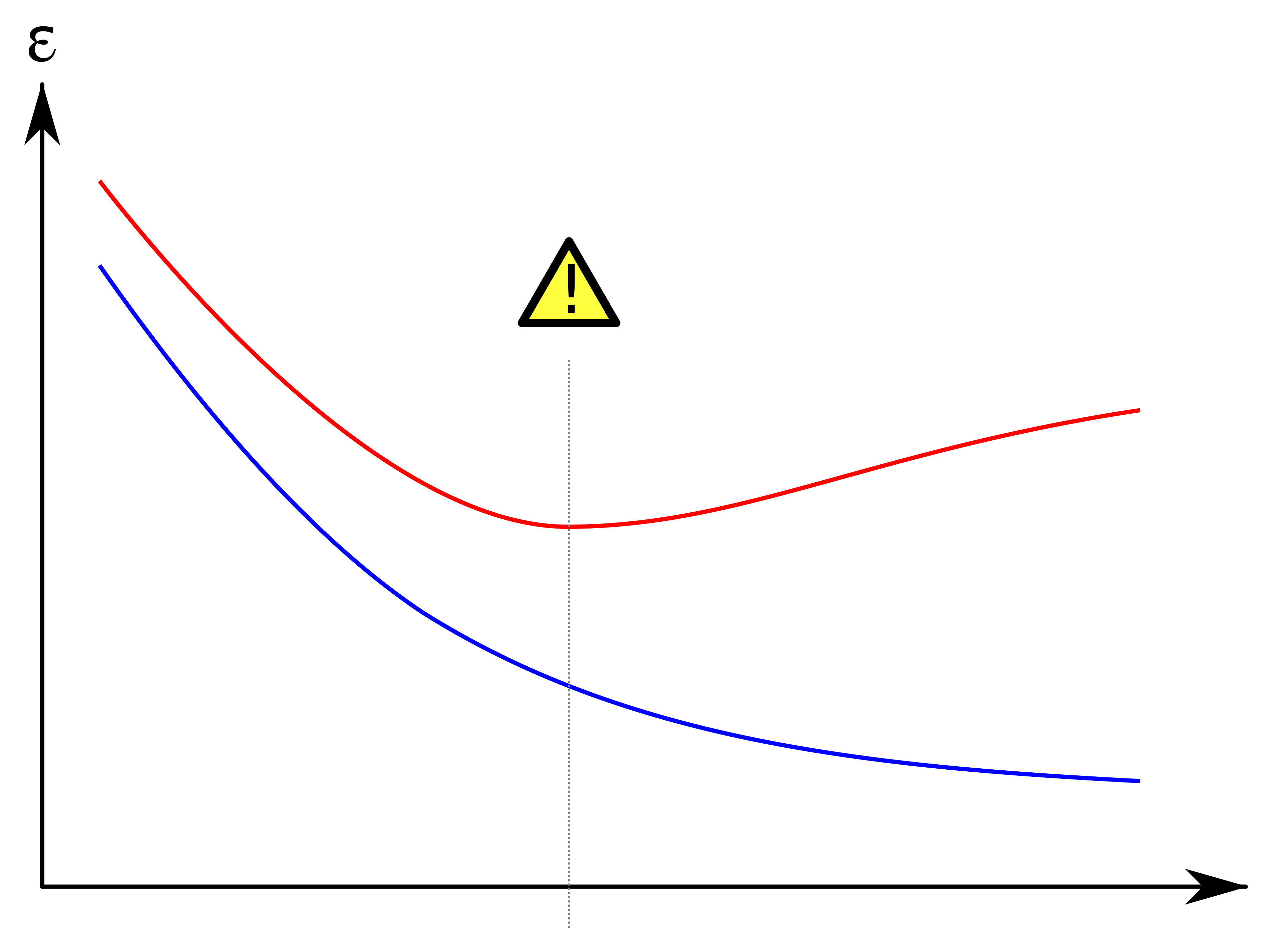

1、过拟合是指:模型在训练数据上的拟合比潜在分布中更接近的现象

2、模型是一个函数,每个函数有不同的复杂度。

3、简单说,就是复杂度越低的函数,且能解决问题,是更好的!

具体来说,模型(函数)复杂度与过拟合之间的关系:统计学家认为,表达力有限(复杂度 更低)但仍能很好地解释数据地模型可能更有实际用途。例如华罗庚推广的优选法,原有的研究更加复杂,但推广的方法极为简单。

4、那么如何调整函数复杂度呢?我们有调整函数复杂度的(更细粒度)工具:范数和权重衰减。文章来源:https://www.toymoban.com/news/detail-696793.html

5、通过函数与零的距离来度量函数的复杂度。L2正则化文章来源地址https://www.toymoban.com/news/detail-696793.html

到了这里,关于深度学习学习笔记——解决过拟合问题的方法:权重衰减和暂退法,与正则化之间的关系的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!