SQL API:Spark SQL 允许使用标准 SQL 语句来查询和分析数据。用户可以通过 SparkSession 执行 SQL 查询,并将结果返回为 DataFrame。这使得熟悉 SQL 的用户能够方便地使用 Spark SQL 进行数据处理。文章来源:https://www.toymoban.com/news/detail-698828.html

示例 1: 基本查询

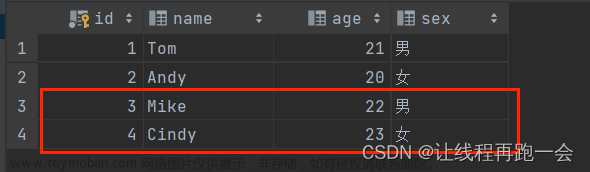

执行基本的 SQL 查询,选择数据中的特定列并过滤数据。文章来源地址https://www.toymoban.com/news/detail-698828.html

// 创建 SparkSession

SparkSession spark = SparkSession.builder()

.appName("SQLAPIExample")

.master(<到了这里,关于15 | Spark SQL 的 SQL API 操作的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!