Python操作HDFS文件的实用方法

Apache Hadoop是一个开源的分布式计算系统,它提供了一种高效的方式来存储和处理大规模数据集。Hadoop的核心组件之一是Hadoop分布式文件系统(HDFS),它提供了可扩展的存储和高效的数据访问。

在Python中,我们可以使用hdfs库来连接和操作HDFS。在本文中,我们将介绍如何使用Python读写HDFS文件的实用解决方案。

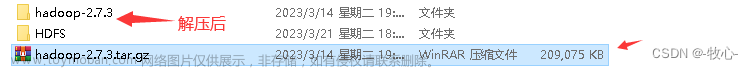

安装与配置hdfs库

首先,我们需要安装hdfs库。使用以下命令来安装:

pip install hdfs

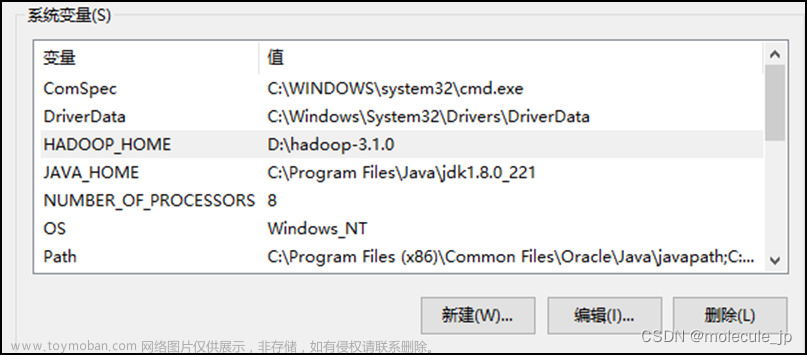

接下来,我们需要配置hdfs连接信息。在Python中,我们可以通过创建一个hdfs客户端对象来连接到HDFS。在这之前,我们需要先检查HDFS连接端口是否正确。默认情况下,HDFS的端口是8020。文章来源:https://www.toymoban.com/news/detail-698901.html

from hdfs import InsecureClient

client = InsecureClient('http://localhost:8020')

创建目录

在HDFS上创建目录非常容易,我们只需要调用FileSystem的mkdirs()方法即可。文章来源地址https://www.toymoban.com/news/detail-698901.html

到了这里,关于Python操作HDFS文件的实用方法的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![【Hadoop】-HDFS的Shell操作[3]](https://imgs.yssmx.com/Uploads/2024/04/858304-1.png)