yolov7结构图

方法:直接在common里改,在相关的后面加上就行

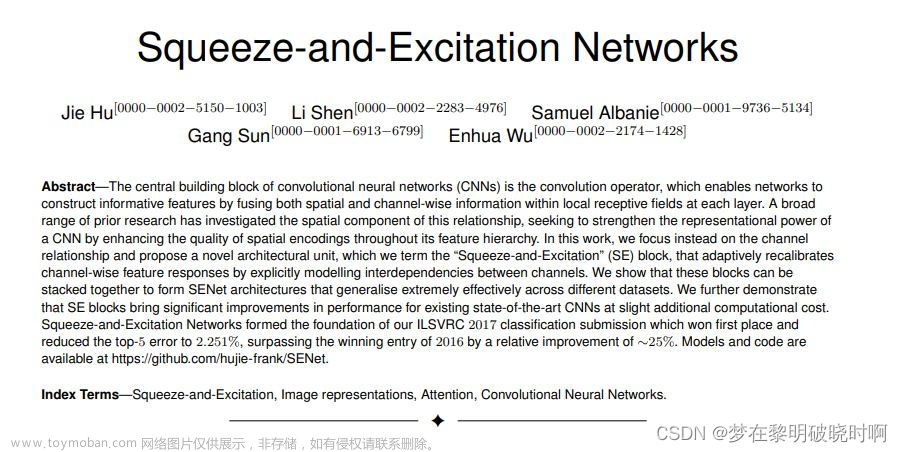

1、接受通道数的注意力机制

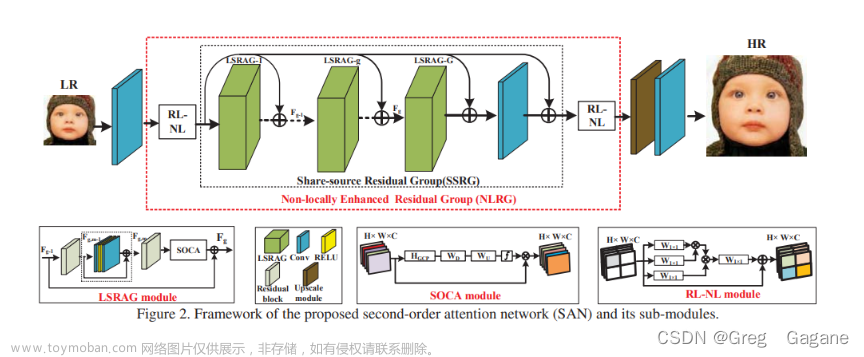

1、目的:在三个输出地方添加注意力

yolov7.yaml文件,换成其他模块

注意力链接

2、models下建SE.py

3、common.py下,先找class Conv,再复制一份修改,把模块导进来

4、yolo.py文件,导入进来,添加

5、yolov7.yaml,修改模块名字

6、全都变成conv_ATT,倒时候换的时候只用换common.py的这里

7、还有第三个地方没加

8、common.py找到sppcspc,复制一份在下面

9、yolo.py添加名字

2、不接受通道的注意力机制

比如说simAm

1、models下建立文件夹,放进去

2、common.py导入模块名

3、common.py下改,默认的可以不用动 文章来源:https://www.toymoban.com/news/detail-698976.html

文章来源:https://www.toymoban.com/news/detail-698976.html

3、加在连接之后

四个连接之后加

1、common.py找到Concat类,复制一份,加一个参数channel

不用接受通道数的可以不加channel参数

2、yolo.py,加这些 文章来源地址https://www.toymoban.com/news/detail-698976.html

文章来源地址https://www.toymoban.com/news/detail-698976.html

到了这里,关于yolov7添加注意力机制的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[YOLOv7/YOLOv5系列算法改进NO.33]引入GAMAttention注意力机制](https://imgs.yssmx.com/Uploads/2024/02/742094-1.png)