在Unity游戏开发中,优化CPU和GPU的性能是非常重要的,可以提高游戏的运行效率、降低功耗和延迟,并提高用户体验。以下是一些优化CPU和GPU性能的方法:

1.优化游戏逻辑和算法

减少不必要的计算和内存操作,例如避免频繁的分配和释放内存,减少不必要的数据结构和循环。

使用更高效的算法和数据结构,例如使用合适的数据结构来存储游戏对象和碰撞信息,使用动态规划来优化复杂的算法。

在游戏逻辑中避免重复计算和渲染,例如在多个游戏对象中共享相同的碰撞检测器或渲染器。

2.优化Unity引擎和编辑器

关闭不必要的Unity编辑器功能和插件,例如不使用的游戏对象、组件和脚本。

减少Unity编辑器中的场景和游戏对象的数量,以减少内存占用和渲染时间。

优化Unity编辑器的场景加载和切换,例如使用预加载、异步加载和缓存等技术来减少加载时间和内存占用。

3.优化图形渲染

减少不必要的渲染调用,例如避免频繁的切换渲染状态。

使用更高效的渲染技术,例如使用混合着色器和GPU粒子系统来减少CPU和GPU的负载。

优化材质和纹理,例如使用压缩纹理、合并纹理和共享材质等技术来减少GPU内存占用。

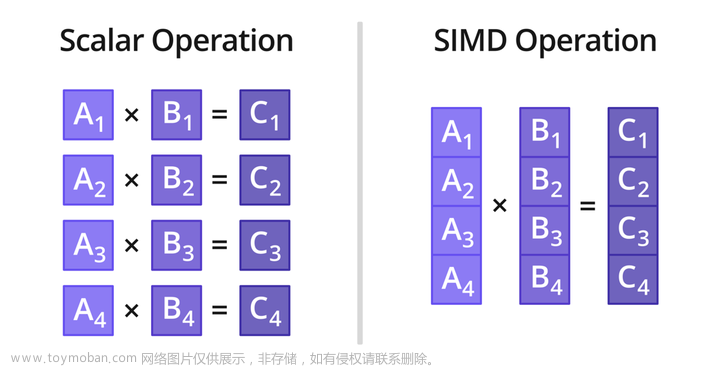

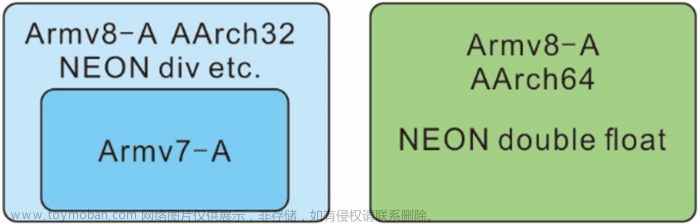

4.使用并行计算和多线程技术

将计算任务分配到多个CPU核心上,以实现并行计算,提高处理速度。

使用多线程技术来并行处理游戏逻辑和图形渲染任务,以充分利用多核CPU的计算能力。

5.使用Unity Profiler工具进行性能分析

使用Unity Profiler工具来分析游戏运行时的性能瓶颈,例如CPU使用率、GPU渲染时间和内存占用等。

根据分析结果进行针对性的优化,例如优化代码、调整渲染设置和优化游戏资源等。文章来源:https://www.toymoban.com/news/detail-699422.html

总之,优化CPU和GPU性能需要综合考虑多个方面,包括游戏逻辑、算法、Unity引擎和编辑器、图形渲染、并行计算和多线程技术等。通过不断优化,可以提高游戏的性能、降低功耗和延迟,并提高用户体验。文章来源地址https://www.toymoban.com/news/detail-699422.html

到了这里,关于CPU和GPU性能优化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!