Python和Selenium是很强大的爬虫工具,可以用于自动化地模拟浏览器行为,从网页中提取数据。下面是一个简单的使用Python和Selenium进行爬虫的案例。

入门:

1. 安装和配置:

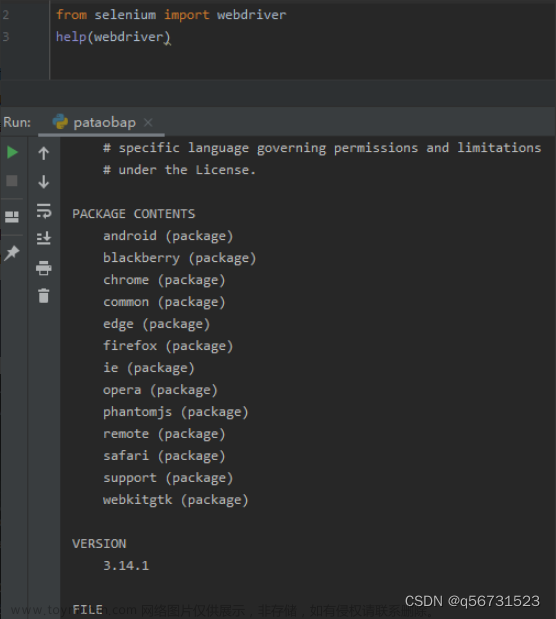

首先,你需要安装Python和Selenium。可以使用pip命令来安装Selenium库:pip install selenium。

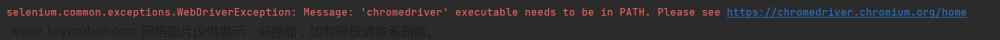

然后,你还需要下载对应浏览器的驱动,比如Chrome浏览器的驱动。可以通过访问 https://sites.google.com/a/chromium.org/chromedriver/ 下载,下载完成后,将驱动文件添加到系统环境变量中。

2. 编写代码:

from selenium import webdriver

# 创建一个浏览器驱动实例

driver = webdriver.Chrome()

# 打开网页

driver.get('https://www.example.com')

# 执行爬取操作

# ...

# 关闭浏览器

driver.quit()

3. 执行爬取操作:

使用Selenium的API,可以模拟浏览器的操作,例如点击按钮、填写表单、滚动页面等。下面是一些常用的操作示例:

- 查找元素:使用find_element方法根据元素的选择器查找页面元素。

element = driver.find_element_by_css_selector('.class_name')

- 点击元素:

element.click()

- 填写表单:

input_element = driver.find_element_by_css_selector('input[name="username"]')

input_element.send_keys('your username')

- 提取数据:

element_text = element.text

- 截屏保存网页:

driver.save_screenshot('screenshot.png')

4. 高级功能:

Selenium还提供了一些高级功能,例如切换窗口、处理弹窗、执行JavaScript等。你可以根据具体需求使用这些功能来完成更复杂的爬虫任务。

5. 异常处理:

在使用Selenium进行爬取时,可能会遇到一些异常,例如元素找不到、网络超时等。你可以使用try-except语句来进行异常处理,确保程序的健壮性。

以上是一个简单的使用Python和Selenium进行爬虫的案例。通过Selenium提供的API,我们可以方便地模拟浏览器行为,从网页中提取所需的数据。当然,爬虫的使用需要遵守相关法律法规,并尊重网站的爬取规则,以避免造成不必要的麻烦。

安全:

在使用Python和Selenium进行爬虫时,需要考虑一些安全问题,以确保爬虫的合法性和保护个人信息的安全。以下是一些安全分析的建议:

1. 合法性和隐私保护:

- 遵守网站的使用条款和隐私政策,确保你的爬虫行为是合法的。

- 不要爬取包含个人敏感信息的网站,如银行账号、密码等。

- 做好数据处理和存储安全,确保爬取的数据不会被滥用或泄露。

2. 爬取频率控制:

- 合理设置爬取间隔,避免对目标网站造成过大的负担和影响其正常运行。

- 避免过于频繁的请求,以免被认为是恶意爬虫而被封禁。

3. 反爬机制处理:

- 一些网站会设置反爬机制,如验证码、IP封锁等。使用Selenium可以处理一些简单的验证码,但对于复杂的验证码,可能需要其他技术或手动干预来解决。

- 使用代理IP来轮换请求,以避免被封禁IP。

- 随机化请求头信息,模拟真实用户的行为。

4. 异常处理和容错机制:

- 在代码中添加异常处理机制,对可能出现的异常进行捕获和处理,以保证程序的稳定性。

- 对于请求失败、元素找不到等情况,可以设置重试机制或跳过该条数据,提高爬虫的健壮性。

5. 日志记录和监控:

- 记录爬虫运行过程中的日志,方便排查问题和分析。

- 监控爬虫的运行状态,及时发现和处理异常情况。

6. 使用合法的API:

- 对于一些网站,可能提供了官方的API接口,可以优先使用这些接口进行爬取,以避免对网站造成不必要的负担。

使用Python和Selenium进行爬虫时,需要注意遵守法律法规,尊重网站的规则,并采取安全措施保护数据和个人信息的安全。合理设置爬取频率,处理反爬机制,添加异常处理和容错机制,记录日志和监控爬虫运行状态等,都是保证爬虫安全的重要措施。

案例:爬取商品价格信息

假设你是一个电商公司的数据分析师,需要爬取竞争对手的商品价格信息以进行市场分析。以下是一个案例分析,展示如何使用Python和Selenium进行安全的爬取。

1. 安装必要的库和工具:

- 安装Python和Selenium库。

- 下载并配置WebDriver,如ChromeDriver,以便与Selenium进行交互。

2. 设置爬虫参数:

- 确定要爬取的竞争对手网站的URL。

- 设置合理的爬取间隔,以避免给目标网站带来过大的负担。

3. 编写爬虫代码:

- 使用Selenium打开网页,并使用WebDriver API来查找和提取商品价格信息。

- 可以通过XPath或CSS选择器定位和提取目标元素。

- 设置合理的异常处理机制,例如捕获元素找不到的异常,并跳过该商品继续爬取下一个商品。

4. 添加反爬机制处理:

- 如果目标网站有反爬机制,可以使用Selenium来处理一些简单的验证码,如输入文本验证码。

- 对于复杂的验证码,可能需要其他技术或手动干预来解决。

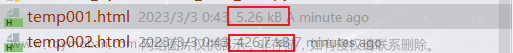

5. 存储和分析数据:

- 将爬取的商品价格信息存储到数据库或文件中,以便后续的数据分析。

- 对爬取的数据进行清洗和预处理,确保数据的准确性和完整性。

6. 日志记录和监控:

- 在代码中添加日志记录,记录爬虫运行过程中的重要信息和异常情况。

- 设置定期的监控任务,检查爬虫的运行状态,并及时发现和处理问题。

7. 合法性和隐私保护:

- 遵守目标网站的使用条款和隐私政策,确保你的爬虫行为是合法的。

- 不要爬取包含个人敏感信息的网站,如用户账号、密码等。

- 做好数据处理和存储安全,确保爬取的数据不会被滥用或泄露。

通过以上步骤,可以安全地使用Python和Selenium进行商品价格信息的爬取。然后可以对爬取的数据进行分析,比较竞争对手的价格,了解市场动态,并为公司的业务决策提供支持。

除了上述的案例分析,还有一些补充内容可以考虑:

- 爬虫的并发性:对于大规模的数据爬取,可以考虑使用多线程或异步请求来提高爬虫的并发性和效率。

- 反爬机制的处理:针对不同的反爬机制,可以使用代理IP、User-Agent轮换、请求头伪装等技术来规避反爬策略。

- 数据处理和分析:爬取的数据可能需要进行清洗和预处理,例如去除重复数据、填充缺失值等。然后可以使用数据分析工具如Pandas、NumPy等进行进一步的数据探索和分析。

- 定时任务和自动化:可以设置定时任务,定期运行爬虫并更新数据,以保持数据的实时性。也可以考虑将爬虫部署到云服务器上,实现自动化运行。

- 随机性和健壮性:为了降低被目标网站识别为爬虫的概率,可以在爬虫代码中添加一些随机性,如随机的等待时间、随机的浏览器窗口大小等。此外,要做好异常处理,防止程序崩溃或停止运行。

- 合法性和道德性:在进行任何爬虫活动之前,请确保你遵守相关法律法规和目标网站的使用条款。同时,要注意道德准则,不要滥用爬虫技术或对他人造成困扰。

- 安全性和隐私保护:在爬取过程中,要确保目标网站和用户的数据安全,不要进行非法的数据获取或侵犯用户的隐私。同时,要保护爬虫的机密信息,如登录凭证和API密钥。

通过综合考虑以上因素,可以开发出高效、稳定、安全的爬虫系统,为数据分析和业务决策提供有价值的支持。

练习题:

-

编写一个爬虫程序,爬取某度首页的标题和链接,并将结果保存到一个文本文件中。

-

编写一个爬虫程序,爬取某瓣电影Top250的电影名称、评分和链接,并将结果保存到一个Excel文件中。

-

编写一个爬虫程序,爬取某乎某个话题下的问题标题和链接,并将结果保存到一个CSV文件中。

-

编写一个爬虫程序,爬取某个电商网站的商品信息,包括商品名称、价格和销量,并将结果保存到一个MySQL数据库中。

-

编写一个爬虫程序,爬取某个新闻网站的新闻标题、时间和内容,并将结果保存到一个MongoDB数据库中。文章来源:https://www.toymoban.com/news/detail-702758.html

这些练习题可以帮助你巩固爬虫的基本知识和技能,并锻炼你的编程能力。你可以使用Python和相关的爬虫库(如Requests、BeautifulSoup、Scrapy等)来完成这些练习。文章来源地址https://www.toymoban.com/news/detail-702758.html

到了这里,关于python selenium 爬虫教程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!