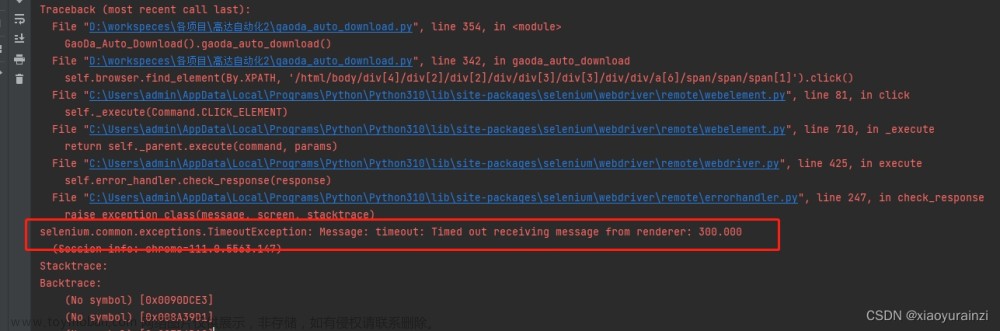

在进行网络爬虫项目时,我们经常需要发送大量的请求来获取所需的数据。然而,由于网络环境的不稳定性,请求可能会因为超时而失败。请求超时可能导致数据获取不完整,影响爬虫的效率和准确性。此外,频繁的请求超时可能会被目标网站视为恶意行为,导致IP被封禁或其他限制。为了确保数据的完整性和准确性,我们需要处理这些超时问题。

为了解决重试请求时出现的超时问题,我们可以采取以下方案:

- 设置适当的超时时间:在发送请求时,设置一个合理的超时时间,以避免等待时间过长。

- 使用重试机制:当请求超时时,我们可以使用重试机制来重新发送请求,以确保数据的完整性。

- 使用代理:通过使用代理服务器,我们可以改变请求的出口IP,从而减少请求超时的可能性。

案例分析和解决方案: 下面是一个案例分析,展示了如何处理重试请求时出现的超时问题的技巧,并提供了相应的代码示例:

在Python的requests库中,可以通过设置timeout参数来指定超时时间。例如,将超时时间设置为5秒:

python

Copy

import requests

url = "http://example.com"

response = requests.get(url, timeout=5)

使用Python的retrying库来实现重试机制。

python

Copy

from retrying import retry

import requests

@retry(stop_max_attempt_number=3, wait_fixed=2000)

def send_request(url):

response = requests.get(url, timeout=5)

return response

url = "http://example.com"

response = send_request(url)

如何使用代理来减少请求超时的可能性,这里我们使用Python的requests库来设置代理。下面是一个示例代码:文章来源:https://www.toymoban.com/news/detail-706537.html

python

Copy

import requests

#代理参数由亿牛云提供

proxyHost = "u6205.5.tp.16yun.cn"

proxyPort = "5445"

proxyUser = "16QMSOML"

proxyPass = "280651"

proxies = {

"http": f"http://{proxyUser}:{proxyPass}@{proxyHost}:{proxyPort}",

"https": f"https://{proxyUser}:{proxyPass}@{proxyHost}:{proxyPort}"

}

url = "http://example.com"

response = requests.get(url, proxies=proxies, timeout=5)

通过以上方案解决请求超时问题,可以保证爬取到的数据完整的避免,数据丢失或错误,可以提高爬虫的效率,减少等待时间,更快地获取所需数据。可以提升用户体验,确保用户能够顺利获取用户所需的数据。文章来源地址https://www.toymoban.com/news/detail-706537.html

到了这里,关于Python网页请求超时如何解决的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!