Low-Light Image Enhancement with Illumination-Aware Gamma Correction and Complete Image Modelling Network

-

这是一篇美团、旷视、深先院、华为诺亚方舟实验室、中国电子科技大学 五个单位合作的ICCV2023的暗图增强论文,不过没有开源代码。

-

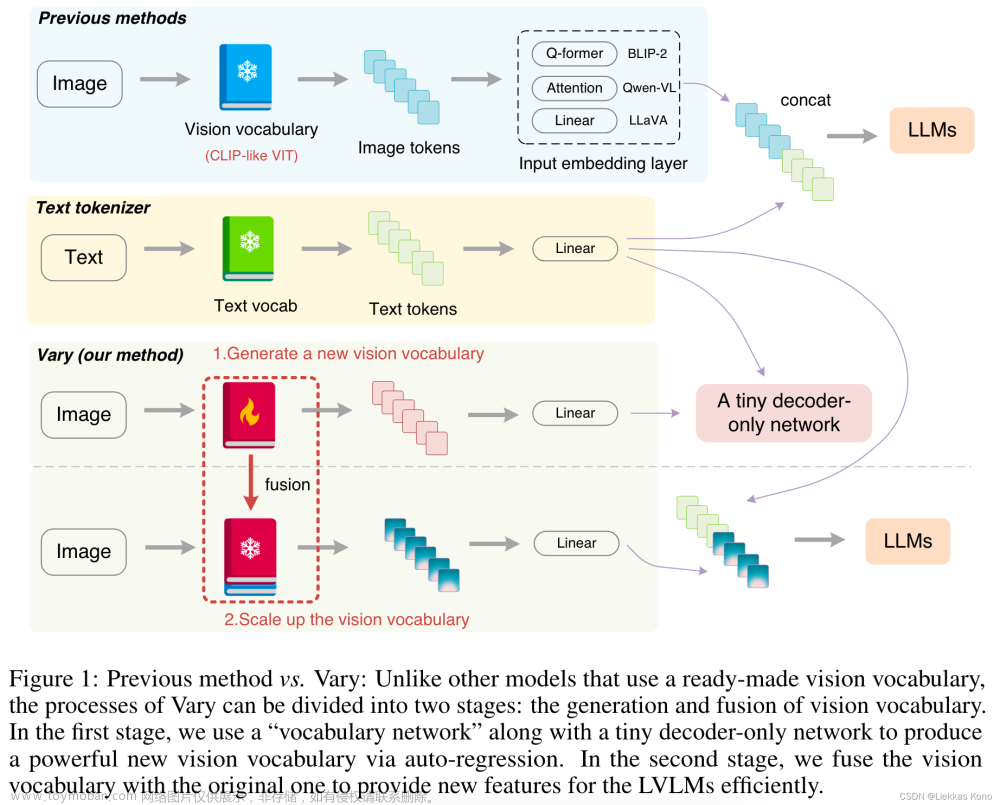

文章的贡献点一个是提出了Global Gamma Correction Module 和 Local Gamma Correction Module相结合的illumination adaptive gamma correction模块,一个是提出了COMO-ViT的网络结构。整体流程如下图所示

-

流程分为3个stage,首先是对暗图 I I I进行卷积pooling全连接sigmoid,产生进行全局gamma校正的参数实现gamma校正。这里把gamma校正展开成泰勒公式以加速运算

-

第二个stage则是把gamma校正后的图片和原图一起送进第二阶段的网络提取特征,并且用到了空间注意力机制,然后将两个特征加到一起作为融合后的特征送进第三阶段的网络。

-

第三阶段则两个分支,一个transformer分支进行non-overlapping window内部的self-attention,一个CNN分支补充transformer分支因为window之间没有交互的缺点,把CNN的特征和transformer的特征加在一起,再送进一个global的transformer做window之间的注意力,输出作为送进下一层的特征。多个这样的操作后,卷积sigmoid得到local gamma 校正的参数,进行local 的gamma校正:

-

损失函数如下:

文章来源:https://www.toymoban.com/news/detail-707614.html

文章来源:https://www.toymoban.com/news/detail-707614.html -

最后是在LOLv2-Real上达到了22.2的PSNR(没有和LLFlow比哈哈哈):

文章来源地址https://www.toymoban.com/news/detail-707614.html

文章来源地址https://www.toymoban.com/news/detail-707614.html

总结

- 个人感觉,泰勒展开应该是没有加速效果的,不仅没有开源,也没有给这个的消融实验;同时呢,只给PSNR和SSIM是很少见的,LPIPS LOE FID NIQE都没有给,比PSNR也没有和LLFlow(25.42的PSNR)比。感觉发ICCV有点。。。

到了这里,关于COMO-ViT论文阅读笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读笔记18] DiffusionDet论文笔记与代码解读](https://imgs.yssmx.com/Uploads/2024/01/401181-1.png)