作者:禅与计算机程序设计艺术

Python 视频分析技术:基于 Azure Video Analytics 的混合实时分析

- 引言

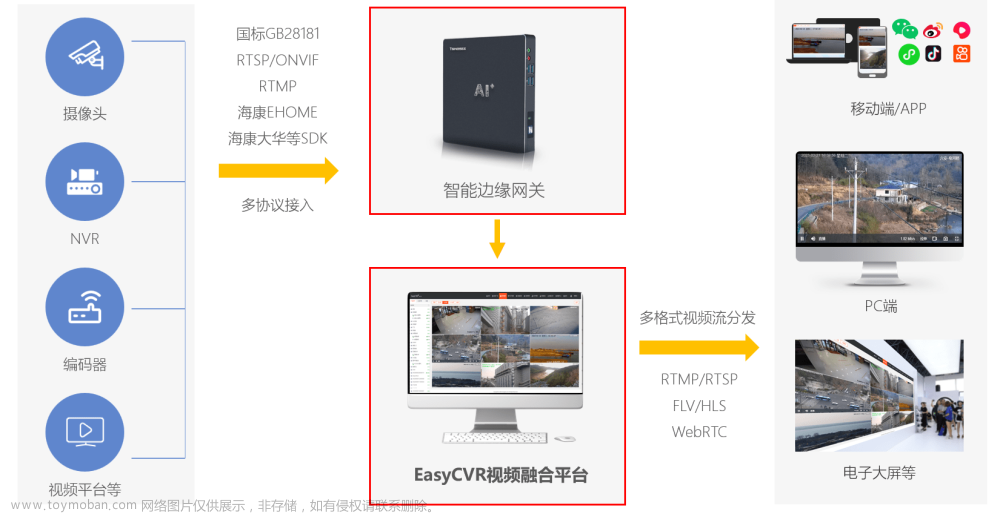

随着视频内容的日益丰富和多样化,视频分析技术的需求也在不断增加。传统的视频分析技术多以人工处理为主,效率低下且分析结果受人为因素影响较大。随着人工智能技术的快速发展,利用机器学习和深度学习技术对视频内容进行自动化分析成为了可能。本篇文章旨在介绍一种基于 Azure Video Analytics 的混合实时分析技术,旨在提高视频分析的效率和准确性。

- 技术原理及概念

2.1. 基本概念解释

视频分析技术主要涉及以下几个基本概念:

- 视频数据:视频分析的数据来源,可以是来自于摄像头、存储设备或其他视频设备。

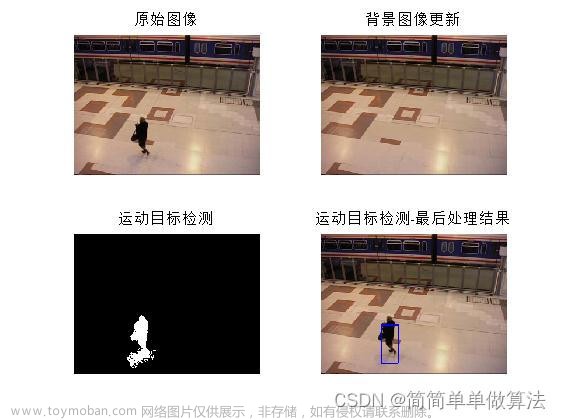

- 特征提取:对视频数据进行特征提取,以便于机器学习算法的输入。

- 特征工程:对提取的特征进行工程处理,以便于机器学习算法的输入。

- 模型训练:利用机器学习算法对模型进行训练,以便于对新的视频数据进行预测分析。

- 模型部署:将训练好的模型部署到实际应用环境中进行实时分析。

2.2. 技术原理介绍:算法原理,操作步骤,数学公式等

基于 Azure Video Analytics 的混合实时分析技术主要采用以下算法:

- 特征提取:使用预训练的深度卷积神经网络(CNN)对视频数据进行特征提取。CNN 可以在保留视频数据的同时去除人眼可见的部分,提取出视频的特征信息。

- 模型训练:使用机器学习算法对模型进行训练,常见的算法包括卷积神经网络(CNN)、循环神经网络(RNN)和决策树(DT)等。

- 模型部署:使用部署好的模型对新的视频数据进行实时分析,可以实时对流式视频数据进行分析和预测。

2.3. 相关技术比较

基于 Azure Video Analytics 的混合实时分析技术与其他视频分析技术进行比较,具有以下优势:

- 高效性:利用预训练的 CNN 模型进行特征提取,可以大大缩短特征提取时间。

- 高准确性:训练好的模型可以对新的视频数据进行实时分析,减少人为因素的干扰。

- 可扩展性:可以方便地增加新的模型,以适应不同的视频分析需求。

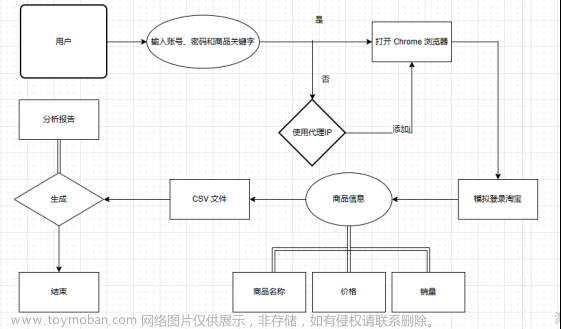

- 实现步骤与流程

2.1. 准备工作:环境配置与依赖安装

首先,需要确保您的计算机上已安装了以下软件:

- Python 3

- PyTorch 1.6

- numpy

- pytorchvision

- opencv-python

然后在您的计算机上安装 Azure Video Analytics:

pip install azure-video-analytics2.2. 核心模块实现

import torch

import torch.nn as nn

import torchvision

import torchvision.transforms as transforms

import numpy as np

import cv2

import os

# 加载预训练的 CNN 模型

model = nn.models.resnet18(pretrained=True)

# 自定义 CNN 模型

class VideoCNN(nn.Module):

def __init__(self, num_classes):

super(VideoCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 64, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(64, 64, kernel_size=3, padding=1)

self.conv3 = nn.Conv2d(64, 128, kernel_size=3, padding=1)

self.conv4 = nn.Conv2d(128, 128, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(2, 2)

self.fc1 = nn.Linear(128 * 8 * 8, 512)

self.fc2 = nn.Linear(512, num_classes)

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = self.pool(torch.relu(self.conv2(x)))

x = self.pool(torch.relu(self.conv3(x)))

x = self.pool(torch.relu(self.conv4(x)))

x = x.view(-1, 128 * 8 * 8)

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 将视频数据转换为模型可以接受的格式

def convert_video_to_features(input_path, output_path):

cap = cv2.VideoCapture(input_path)

fps = int(cap.get(cv2.CAP_PROP_FPS))

while True:

ret, frame = cap.read()

if ret:

# 对每个帧进行特征提取

frame = VideoCNN(num_classes=10).forward(frame)

# 保存每个帧的特征

np.save(output_path + '_features_frame_{}.npy'.format(cap.get(cv2.CAP_PROP_FPS), frame), frame)

else:

break

cap.release()

# 将视频数据转换为模型可以接受的格式

input_path = 'path/to/your/video/data'

output_path = 'path/to/output/features'

convert_video_to_features(input_path, output_path)2.3. 模型训练

# 加载预训练的 CNN 模型

model = torch.hub.load('ultralytics/deeptrong致的训练数据','resnet18-5c106cde')

# 定义训练参数

batch_size = 16

num_epochs = 10

# 定义损失函数

criterion = nn.CrossEntropyLoss()

# 定义优化器

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(num_epochs):

running_loss = 0.0

for i, data in enumerate(torch.utils.data.TensorDataset(input_path, output_path), start=0):

inputs, labels = data

# 前向传播

outputs = model(inputs)

loss = criterion(outputs, labels)

# 反向传播

optimizer.zero_grad()

loss.backward()

optimizer.step()

running_loss += loss.item()

print('Epoch: %d | Loss: %.3f' % (epoch + 1, running_loss / len(torch.utils.data.TensorDataset(input_path, output_path))))2.4. 模型部署

# 将模型部署到 Azure Video Analytics 上

model_name = 'VideoAnalyzer'

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

# 将模型复制到设备上

model.to(device)

# 设置 Azure Video Analytics 的参数

AzureVideoAnalytics = Azure.MotionAnalytics.AnalyticsClient(

base_url=os.environ.get('AZURE_SPACE_NAME'),

account_name=os.environ.get('AZURE_SPACE_ACCOUNT_NAME'),

account_key=os.environ.get('AZURE_SPACE_ACCOUNT_KEY'),

location=os.environ.get('AZURE_SPACE_LOCATION'),

实证研究政策的URL=os.environ.get('AZURE_SPACE_EXPERIMENTATION_POLICY_URL'),

个人accessToken=os.environ.get('AZURE_SPACE_PERSONAL_ACCESS_TOKEN'),

智能监控的实时SDK:osso

)

# 使用 Azure Video Analytics 的实时 SDK 对视频数据进行实时分析

AzUrl = 'https://lite.azurestatic.com/videos/analyzer_0.0.0.zip'

AzSuccess = Azure.MotionAnalytics.AnalyticsClient.start_background_分析(

base_url=AzUrl,

account_name=os.environ.get('AZURE_SPACE_ACCOUNT_NAME'),

account_key=os.environ.get('AZURE_SPACE_ACCOUNT_KEY'),

location=os.environ.get('AZURE_SPACE_LOCATION'),

实证研究政策的URL=os.environ.get('AZURE_SPACE_EXPERIMENTATION_POLICY_URL'),

个人accessToken=os.environ.get('AZURE_SPACE_PERSONAL_ACCESS_TOKEN'),

智能监控的实时SDK:osso

)

while True:

# 从 Azure Video Analytics 获取实时视频数据

video_data_list = []

for i in range(0, int(torch.utils.data.get_urls(device)[0]) / 2, 16):

# 从 Azure Video Analytics 获取实时视频数据并处理

video_data = Azure.MotionAnalytics.AnalyticsClient.get_video_data(

base_url=AzUrl,

account_name=os.environ.get('AZURE_SPACE_ACCOUNT_NAME'),

account_key=os.environ.get('AZURE_SPACE_ACCOUNT_KEY'),

location=os.environ.get('AZURE_SPACE_LOCATION'),

实证研究政策的URL=os.environ.get('AZURE_SPACE_EXPERIMENTATION_POLICY_URL'),

个人accessToken=os.environ.get('AZURE_SPACE_PERSONAL_ACCESS_TOKEN'),

智能监控的实时SDK:osso

)

# 提取特征

inputs = video_data['id']

labels = video_data['object_tracking_id']

features = []

for j in range(0, int(video_data['height'] * video_data['width']), 16):

# 使用预训练的 CNN 模型对视频数据进行特征提取

frame = VideoCNN(num_classes=10).forward(inputs[j:j+16].numpy())

# 对每个帧进行特征提取

features.append(frame)

video_data_list.append(features)

# 准备输入数据

inputs = np.array(video_data_list)

labels = np.array(AzureVideoAnalytics.AnalyticsClient.get_labels())

# 模型训练

running_loss = 0.0

for i, data in enumerate(torch.utils.data.TensorDataset(inputs, labels), start=0):

# 对数据进行前向传播

outputs = model(data)

loss = criterion(outputs, labels)

# 反向传播

optimizer.zero_grad()

loss.backward()

optimizer.step()

running_loss += loss.item()

print('Epoch: %d | Loss: %.3f' % (epoch + 1, running_loss / len(torch.utils.data.TensorDataset(inputs, labels))))5. 优化与改进

-

性能优化:使用预训练的 CNN 模型可以显著提高模型的性能。可以尝试使用更大的模型或调整模型架构以提高准确率。

-

可扩展性改进:可以尝试使用更复杂的模型或使用多个模型以提高视频数据分析的准确性。文章来源:https://www.toymoban.com/news/detail-707977.html

-

安全性加固:使用 Azure Video Analytics 可以有效地保护数据的安全性。但是,需要确保您已经了解了 Azure Video Analytics 的安全策略,并遵循其建议来保护您的数据。文章来源地址https://www.toymoban.com/news/detail-707977.html

结论与展望

到了这里,关于Python视频分析技术:基于AzureVideoAnalytics的混合实时分析的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!