首先hadoop和jdk都已经装好了的,如下:

然后相应的这五个配置文件也配好了:

然后格式化了:

cd /opt/hadoop/bin/

sudo ./hdfs namenode -format

(显示这个就为成功,很长的,慢慢找)

==========以上为前提,然后开始遇见问题===========

问题1:输入jps的时候说找不到?按理来说有jdk应该就能够使用这个命令的,找了很久都没找到。

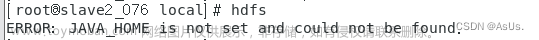

报错如下:

Command 'jps' not found, but can be installed with:

apt install openjdk-11-jdk-headless # version 11.0.20+8-1ubuntu1~20.04, or

apt install openjdk-13-jdk-headless # version 13.0.7+5-0ubuntu1~20.04

apt install openjdk-16-jdk-headless # version 16.0.1+9-1~20.04

apt install openjdk-17-jdk-headless # version 17.0.8+7-1~20.04.2

apt install openjdk-8-jdk-headless # version 8u382-ga-1~20.04.1

解决方案:按照报错提示我下了一个openjdk-11-jdk-headless,然后再使用jps就没问题了

问题2:start-all.sh的时候,我发现我少了两个,于是我重新格式化看看能不能行,不仅不能行,还导致我原先有namenode的,然后jps又不见namenode了?

原因:找了许多原因,最后我认为是因为多次格式化后所导致的。

解决方案参考:hadoop 多次格式化format namenode 导致节点不能启动解决_hadoop多次格式化导致节点缺失_qq_41059374的博客-CSDN博客1. 具体配置 我用的是vmware配的虚拟机,一个master,2个slave2. 遇到的问题hadoop 多次格式化format namenode 导致节点不能启动,出现这个问题的原因是多次格式化会导致节点的clusterID不一致3. 解决方法 我是参考的stackoverflow的方法,有一些不同 https://stackoverflow.com/qu..._hadoop多次格式化导致节点缺失https://blog.csdn.net/qq_41059374/article/details/80695581?spm=1001.2014.3001.5502

实际步骤(顺序真的很重要):

①把haadoop停掉:stop-all.sh

②把/opt/haadoop/tmp删掉:rm-rf

③删掉之后再重新格式化,再重新启动start-all.sh就有了

问题3:我真的快烦躁死了(小声bb),跟上述图一样,缺了两个有关yarn的。

原因:看了日志文件,大概是java版本不兼容的原因。

解决方案参考:yarn启动后用jps查看没有resourcemanager_jps没有resourcemanager_川川菜鸟的博客-CSDN博客yarn启动后用jps查看没有resourcemanager_jps没有resourcemanagerhttps://blog.csdn.net/weixin_46211269/article/details/126558775

实际步骤:

在/opt/Hadoop/etc/Hadoop/yarn-env.sh中添加

export YARN_RESOURCEMANAGER_OPTS="--add-opens java.base/java.lang=ALL-UNNAMED"

export YARN_NODEMANAGER_OPTS="--add-opens java.base/java.lang=ALL-UNNAMED"

重新启动就好啦然后就终于能看到我想要的了(除jps以为的五个进程)

最后打开一下网址验证一下:

localhost:9870

localhost:8088

文章来源:https://www.toymoban.com/news/detail-708492.html

文章来源:https://www.toymoban.com/news/detail-708492.html

一晚上在解决问题出现新的问题之间来回捣鼓,最后总算搞好了!不容易!记录一下!文章来源地址https://www.toymoban.com/news/detail-708492.html

到了这里,关于启动hadoop并测试问题合集的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!