前言

本节内容我们主要介绍一下Flume数据流的监控工具Ganglia。Ganglia是一个开源的分布式系统性能监控工具。它被设计用于监视大规模的计算机群集(包括集群、网格和云环境),以便收集和展示系统和应用程序的性能数据。Ganglia 可以轻松地扩展到数千台计算机节点,并支持跨多个数据中心进行分布式监控。Ganglia 使用高效的多播通信协议和紧凑的数据格式,以最小化对网络和系统资源的影响。Ganglia 提供实时监控和报告功能,可以显示关键指标(如 CPU 使用率、内存使用率、网络流量等)的实时数据和历史趋势。Ganglia 提供直观的 Web 界面,可以通过图表和图形方式展示系统性能数据,方便用户进行可视化分析。Ganglia 支持插件机制,可以扩展其功能并与其他工具和服务集成。

正文

-

服务规划

| hadoop101 | hadoop102 | hadoop103 |

|---|---|---|

| gweb | ||

| gmetad | ||

| gmod | gmod | gmod |

- Ganglia组件说明

gmond(Ganglia Monitoring Daemon):是一种轻量级服务,安装在每台需要收集指标数据的节点主机上。使用 gmond,你可以很容易收集很多系统指标数据,如 CPU、内存、磁盘、 网络和活跃进程的数据等。

gmetad(Ganglia Meta Daemon):整合所有信息,并将其以 RRD 格式存储至磁盘的服务。

gweb(Ganglia Web)Ganglia :可视化工具,gweb 是一种利用浏览器显示 gmetad 所存储数据的 PHP前端。在Web界面中以图表方式展现集群的运行状态下收集的多种不同指标数 据。

- 在hadoop101、hadoop102、hadoop103分别安装epel-release

- 命令:sudo yum -y install epel-release

- 在hadoop101上安装ganglia-gmetad、ganglia-web、ganglia-gmond

- 命令:

sudo yum -y install ganglia-gmetad

sudo yum -y install ganglia-gmond

sudo yum -y install ganglia-web

- 在hadoop102和hadoop103上安装ganglia-gmond

- 命令:

sudo yum -y install ganglia-gmond

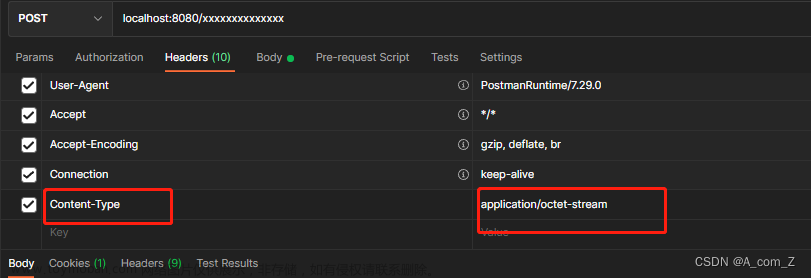

- 在hadoop101服务器修改/etc/httpd/conf.d/ganglia.conf配置文件

- 使得该网段地址192.168.10.0/24都能访问ganglia-web

- 在hadoop101服务器修改/etc/ganglia/gmetad.conf配置文件

- 修改元数据的存储位置

- 在hadoop101、hadoop102、hadoop 103 修改配置文件/etc/ganglia/gmond.conf

- 修改hadoop101的gmond.conf 配置

- 同步配置到hadoop102和hadoop103

- 将hadoop101配置文件/etc/selinux/config中的SELINUX修改为disabled

- 启动ganglia的监控服务

- 在hadoop101、hadoop02、hadoop103启动gmond服务:sudo systemctl start gmond

- 在hadoop101启动httpd和gmetad服务

- 访问ganglia的web端页面

- 开启一个flume监控任务,查看ganglia的web端页面查看监控指标

- 在hadoop101服务器上启动一个flume监控任务

bin/flume-ng agent \ -c conf/ \ -n a1 \ -f job/job-netcat-flume-console.conf \ -Dflume.root.logger=INFO,console \ -Dflume.monitoring.type=ganglia \ -Dflume.monitoring.hosts=hadoop101:8649

文章来源:https://www.toymoban.com/news/detail-709656.html

- 图例说明

| EventPutAttemptCount | source 尝试写入 channel 的事件总数量 |

| EventPutSuccessCount | 成功写入 channel 且提交的事件总数量 |

| EventTakeAttemptCount | sink 尝试从 channel 拉取事件的总数量。 |

| EventTakeSuccessCount | sink 成功读取的事件的总数量 |

| StartTime | channel 启动的时间(毫秒) |

| StopTime | channel 停止的时间(毫秒) |

| ChannelSize | 目前 channel 中事件的总数量 |

| ChannelFillPercentage | channel 占用百分比 |

| ChannelCapacity | channel 的容量 |

结语

关于Flume数据流监控之Ganglia的安装与部署内容到这里就结束了,我们下期见。。。。。。文章来源地址https://www.toymoban.com/news/detail-709656.html

到了这里,关于(二十四)大数据实战——Flume数据流监控之Ganglia的安装与部署的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!