前言

本文是该专栏的第58篇,后面会持续分享python爬虫干货知识,记得关注。

做过爬虫项目的同学,可能或多或少爬取过文档数据,比如说“政务网站,新闻网站,小说网站”等平台的文档数据。爬取文档数据,笔者这里就不过多详述,而本文,笔者将主要介绍在爬取文档数据的过程中,遇到文档的正文内容含有表格的情况要怎么去除掉表格,并将正文保存。

具体实现思路,跟着笔者直接往下看正文详细内容。(附带完整代码)

正文

地址:aHR0cDovL2Znay5tb2YuZ292LmNuL3VpL3NyYy92aWV3cy9sYXdfaHRtbC82NDU0Ny5odG1s

目标:将正文中的表格去除,将正文内容保存到本地

1. 问题说明

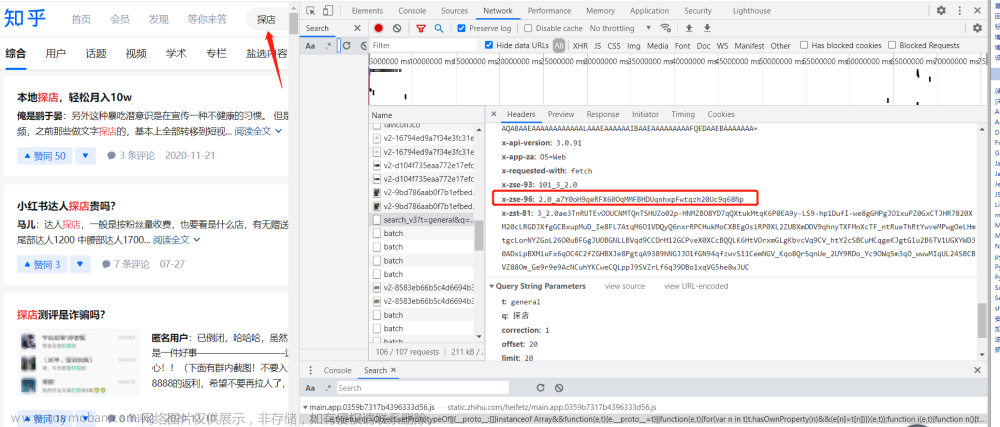

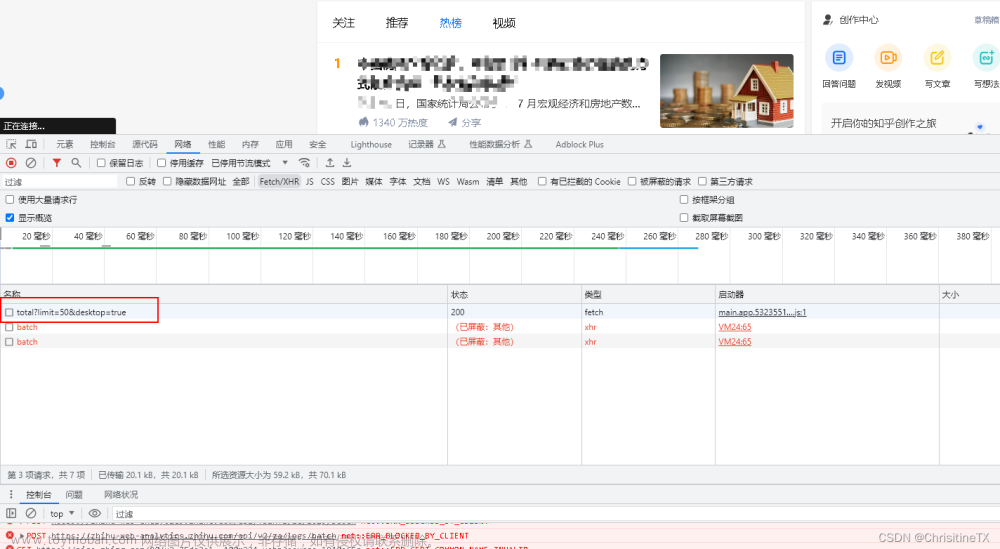

如下图所示:文章来源:https://www.toymoban.com/news/detail-709693.html

文章来源地址https://www.toymoban.com/news/detail-709693.html

文章来源地址https://www.toymoban.com/news/detail-709693.html

到了这里,关于Python爬虫-爬取文档内容,如何去掉文档中的表格,并保存正文内容的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!