注:文章的原文有11个章节,分别是:

- 摘要 (Abstract)

- 引言(Introduction)

- 概述(Overview)

- 大语言模型资源( Resources of LLMs)

- 预训练(Pre-trainng)

- 大语言模型的适配微调( Adaptation of LLMs)

- 使用(Utilization)

- 能力评价(Capacity and Evaluation)

- 快速设计实用指南(A practical guidebook of prompt design)

- 应用(Applications)

- 结论和未来方向(Conclusion and future directions)

按照文章的顺序讲的话,太长(英文版的文章有97页,最新版的中文版本也有60页)而且和直接翻译一遍文章没有什么区别。

所以我准备按照自己对于文章的理解来展开对于这篇文章的分享。有不足的地方希望大家及时指出!

大语言模型综述A Survey of Large Language Models

文章基本信息如下

- 文章名字:A Survey of Large Language Models

- 发表时间:2023年3月

- 发表期刊:arxiv(预印版)

- 发表机构:中国人民大学 - AI Box小组 (ruc.edu.cn)

0 摘要 (Abstract)

时代背景:

- 自从20世纪50年代图灵测试被提出以来,人类一直在探索如何用机器掌握语言智能。

- 近年来,通过在大规模语料库上对Transformer 模型进行预训练,人们提出了预训练语言模型(Pre-training Language Model, PLM),其在解决各种自然语言处理(Natural Language Processing, NLP)任务方面表现出强大的能力。

- 近年来,学术界和工业界极大地 推进了针对LLM的研究,其中一个显著的进展是推出了ChatGPT(一种基于LLM开发的强大AI聊天机器人),它引起了社会的广泛 关注。

研究发现:

- 研究人员发现扩展模型规模可以提高模型能力,因此他们通过将参数增加到更大的 尺寸来进一步研究该效应。

- 有趣的是,当参数规模超过一定水平时,这些规模更大的语言模型的性能不仅得到了显著提升,而且还表现出 一些小规模语言模型(例如BERT)所不具备的特殊能力(例如上下文学习)。

文章讲了什么?

- 通过介绍大语言模型(large Language Model)的背景、主要发现和主流技术来回顾近年来的进展。

- 主要关注大语言模型(large Language Model)以下四个主要方面:①预训练,②适配微调,③使用,④能力评估

- 总结了开发LLM的可用资源,并讨论了LLM现有的问题和未来的发展方向。

- 提供了关于 LLM 的最新文献综述。

1 大语言模型近年来的发展

1.1 大语言模型的背景

自从20世纪50年代图灵测试被提出以来,人类一直在探索如何用机器掌握语言智能。机器除非配备了强大的人工智能算法,否则不能自然地掌握以人类语言形式理解和交流的能力。实现让机器像人类一样阅读、写作和交流的目标, 一直是一个长期的研究挑战。作为一种主要的语言理解和生成方法,语言建模在过去的二十年中得到了广泛的研究,并从统计语言模型逐步发展为神经语言模型。

1.1.1 语言建模的四个主要发展阶段:

-

统计语言模型(SLM)

- 20世纪90年代,学术界对于统计语言模型(SLM)的研究开始兴起。

- 统计语言模型(SLM)基于统计学习方法开发,其基本思想是基于马尔可夫假设建立词预测模型,例如根据最近的上下文预测下一个词。

- 具有固定上下文长度n的统计语言模型(SLM)也称为n元语言模型,例如 bi-gram 和 tri-gram 语言模型。

- bi-gram语言模型:当前词出现的概率只与上一个词出现的概率相关

- tri-gram语言模型:当前词出现的概率只与上两个词出现的概率相关

- 统计语言模型(SLM)已被广泛应用于提高信息检索(IR)和自然语言处理(NLP)的任务性能。

-

神经语言模型(NLM)

- 神经语言模型(NLM)通过神经网络, 如循环神经网络(RNN),来描述单词序列的概率。

- word2vec提出了构建一个简化的浅层神经网络来学习分布式单词表示的方法,这些表示在各种 NLP 任务中被证明非常有效。

- 这些研究开创了将语言模型用于表示学习(超越词序列建模)的应用,对NLP领域产生了 重要影响。

-

预训练语言模型(PLM)

- ELMo被提出来通过预训练一个双向LSTM(bi-LSTM)网络来捕捉上下文感知的词表示,然后根据 特定的下游任务微调bi-LSTM网络。

- 基于自注意力机制的高度并行化Transformer架构,BERT作为双向语言模型,在大规模无标签语料库上使用专门设计的预训练任务。这些预训练的上下文感知词表示作为通用语义特征非常有效,其极大地提高了NLP任务的性能。

-

大语言模型(LLM)

- 扩展PLM(例如 扩展模型大小或数据大小)通常会提高下游任务的模型性能。许多研究通过训练越来越大的PLM (例如175B参数的GPT-3,40B参数的PaLM和2200B参数的GPT4)来探索性能极限。

- 尽管扩展主要在模型大小方面进行(使用类似的架构和预训练任务),但这些大规模的PLM与较小的PLM (例如0.3B参数的BERT和1.5B参数的GPT-2)表现出不同的行为,并在解决一系列复杂任务中展示了惊人的能力(称 为涌现能力)。例如,GPT-3可以通过上下文学习(in-context learning, ICL)来解决小样本任务,而GPT-2则表现不佳。

1.1.2 研究热度统计:

- (a)图显示了包含关键词

Language Model的arXiv文章累计数量统计(自2018年6月起)- (b)图显示了包含关键词

Large Language Model的arXiv文章累计数量统计(自2019年10月起)通过按月份查询标题或摘要中的关键词,使用精确匹配计算统计数据。(b)图中可以看出,ChatGPT发布后急剧在标题或摘要中包含“大型语言模型”的已发表arXiv论文的平均数量增加,从每天0.40篇增加到每天8.58篇

1.2 主要发现

问题一:多大的模型才能算是大语言模型呢?

- Bing AI:The definition of “large” is fuzzy, but “large” has been used to describe BERT (110M parameters) as well as PaLM 2 (up to 340B parameters. Parameters are the weights the model learned during training, used to predict the next token in the sequence.

- wikipedia:大语言模型 (英语:large language model,LLM) 是一种语言模型,由具有许多参数(通常数十亿个权重或更多)的人工神经网络组成,使用自监督学习或半监督学习对大量未标记文本进行训练。大型语言模型在2018年左右出现,并在各种任务中表现出色。

- 本综述的观点:大语言模型是指包含数千亿(或更多)参数的Transformer语言模型,这些模型是在大规模文本数据上进行训练的,例如GPT-3,PaLM,Galactica 和 LLaMA。

-

我的理解:

- 通过上面的回答我们可以看出,现在的研究中并没有对于多大的模型才能算作大语言模型有一个确切的定义。通常大语言模型一般拥有数十亿或者更多的参数。

- 对于本综述的观点我并不是非常的认可。因为我们知道 LLaMA 2 拥有三个版本,参数量分别是7B、13B和70B,没有达到综述中的千亿参数的规模,但是 LLaMA 2 还是被大家公认为是一个预训练的大语言模型。

问题二:LLM和PLM有什么区别呢?

- LLM表现出一些令人惊讶的涌现能力,这些能力可能在以前较小的PLM中没有观察到。这些能力是LM在复杂任务上表现的关键,它使得人工智能算法具有前所未有的强大和有效性。

- LLM将彻底改变人类开发和使用人工智能算法的方式。与小型PLM不同,访问LLM的主要方法是通过提示接口(例如GPT-4API)。人们必须了解LLM 的工作原理,并以LLM能够遵循的方式形式化他们的任务。

- LLM的发展不再明确区分研究和工程。训练LLM需要在大规模数据处理和分布式并行训练方面具有丰富的实践经验。为了开发出有能力的LLM,研究人员必须解决复杂的工程问题,他们需要与工程师合作或成为工程师。

我的理解:

-

大语言模型(LLM)指的是的参数量非常庞大的语言模型,而预训练语言模型(PLM)指的是在一些通用的语料库上预先训练过的语言模型。

-

例如:前面提到的“ELMo被提出来通过预训练一个双向LSTM(bi-LSTM)”,它是预训练语言模型(PLM)但是不能算作大语言模型(LLM),因为它的参数量没有达到大语言模型的标准(虽然这个标准很模糊),但是它在一些语料库中进行过训练,所以能够称为预训练语言模型(PLM)。

-

所以,大语言模型(LLM)和预训练语言模型(PLM)之间存在交集,但不是被包含与包含的关系

1.3 大语言模型的扩展法则

1.3.1 KM扩展法则

-

Kaplan 等人(OpenAI 团队)于2023年首次提出了神经语言模型的性能与模型规模(N)、数据集规模(D)和训练计算量(C)之间的幂律关系。

-

计算公式如下

\[L(N) = \bigg(\frac{N_c}{N}\bigg)^{\alpha_N}, ~~ \alpha_N \sim 0.076, N_c \sim 8.8\times 10^{13} \\ L(D) = \bigg(\frac{D_c }{D}\bigg)^{\alpha_D}, ~~ \alpha_D \sim 0.095, D_c \sim 5.4\times 10^{13} \\ L(C) = \bigg(\frac{C_c}{C}\bigg)^{\alpha_C}, ~~ \alpha_C \sim 0.050, C_c \sim 3.1\times 10^{8} \] -

这三个规律是通过拟合模型在不同数据大小、模型大小和训练计算量下的性能得出的。结果表明,模型性能与这三个因素存在着强依赖关系。

1.3.2 Chinchilla 扩展法则

- Hoffmann 等人(Google DeepMind 团队)提出了一种扩展法则的替代形式来指导大语言模型最优计算量的训练。

- 他们通过变化更大范围的模型大小和数据大小进行了严格的实验,并拟合了一个类似的扩展法则。

KM扩展法则更偏向于将更大的预算分配给模型大小,而Chinchilla 扩展法则认为模型大小和数据大小应该以相同的比例增加。

1.4 大语言模型的涌现能力

大语言模型的涌现能力的定义:在小型模型中不存在但在大型模型中产生的能力

解释:当规模达到一定水平时,性能显著提高,超出随机水平。

大语言模型的三种典型涌现能力和具备这种能力的代表性模型:

- 上下文学习,代表模型:GPT-3(175B的GPT-3模型在一般情况下表现出强大的上下文学习能力,但GPT-1和GPT-2模型则没有)

- 指令遵循(指令微调),代表模型:LaMDA-PT(当模型大小达到68B时,经过指令微调的LaMDA-PT开始在未见过的任务上显著优于未微调的模型,但对于8B或更小的模型大小则不会如此。)

- 逐步推理,代表模型:PaLM(当思维链提示应用于模型大小大于60B的PaLM变体时,可以提高模型在算术推理基准任务上的性能,而当模型大小超过100B时,其相 对于标准提示的优势更加明显。)

1.3 大语言模型的关键技术

大语言模型能够成功的几个可能的关键技术:

- 扩展:Transformer语言模型存在明显的扩展效应:更大的模型,更大的数据规模和更多的训练计算通常会导致模型能力的提升。

- 训练:由于巨大的模型规模,成功训练一种能力强的大语言模型(LLM)是非常具有挑战性的。大语言模型(LLM)一般使用分布式训练,搭配一些正对行的优化策略来进行训练。

- 能力引导:大语言模型在一些特定的任务上表现并不是很好,但是可以通过一些手段引导大模型以激发这些能力。例如:通过设计合适的任务指令或具体的上下文学习(ICL)策略或者使用自然语言表达的任务描述对大语言模型(LLM)进行指令微调,以提高LLM在未见任务上的泛化能力。

- 对齐微调:由于大语言模型(LLM)被训练用来捕捉预训练语料库的数据特征,它们可能会为人类 生成有毒、偏见甚至有害的内容。因此,有必要使大语言模型(LLM)与 人类价值观保持一致,例如有用性、诚实性和无害性。

- 工具操作:大语言模型(LLM)在一些不适合以纯文本形式表达的任务上表现不佳,为了解决这些问题可以利用外部工具来弥补大语言模型(LLM)的不足。例如:GPT4已经能够使用外部插件来扩展它的能力范围。

1.4 大模型的发展史

1.4.1 各种大模型的发布时间

最近几年现有的大语言模型(参数量超过10B)发布的时间。黄色标记的是具有公开可用模型检查点的大语言模型。

1.4.2 GPT 系列模型的发展

GPT 系列模型的发展史:

- GPT-1于2018年6月发布,是一个只有编码器架构的生成预训练语言模型。

- GPT-2于2019年2月发布,是一个无监督多任务学习器模型。拥有4个模型版本:分别是Small(117M),Medium(345M),Large(762M),Extra Large(1542M)

- GPT-3于2020年5月发布,是一个拥有上下文学习能力的大语言模型。拥有8个模型版本,最小的参数规模为125M,最大的参数规模为175B

- Codex于2020年7月发布,是GPT-3添加了代码生成的能力,在代码的数据集上进行了预训练。

- GPT-3.5于2022年3月发布,是一个综合的大语言模型,拥有对话生成,文本阅读和理解等功能。参数规模为175B。

- GPT-4于2023年3月发布,是一个多模态大模型,拥有较强的综合推理能力。

1.4.3 LLaMA 系列模型的发展

两张可爱的关于 LLaMA 的漫画:

LLaMA 的发展和演变:

图中展示的是

LLaMA的演变过程。

- 虚线部分部分代表使用其他数据

继续预训练,实线部分代表指令微调- 图中没有背景颜色的表示

有效参数微调,黄色背景颜色的表示全参数微调- 从图中可以看出,

LLaMA有三个主要的分支,分别是:

- 使用中文数据预训练后的

Chinese LLaMA- 使用合成数据进行微调的

Alpaca- 使用对话数据进行微调的

Vicuna- 在这三个主要的分支的基础上,又发展出了许多其他的模型,涵盖了数学,金融,医疗,法律,双语,教育等方面。其中有很多我们耳熟能详的模型,例如:

MiniGPT-4、PandaGPT、TaoLi等

2 大语言模型四个主要方面

2.1 预训练

2.1.1 为什么要进行预训练?

预培训奠定了大语言模型(LLM)能力的基础。通过对大规模语料库的预训练,大语言模型(LLM)可以获得基本的语言理解和生成技能。预训练语料库的规模和质量是大语言模型(LLM)获得强大功能的关键。此外,为了有效地预训练大语言模型(LLM),模型架构,加速方法和优化技术需要很好地设计。

2.1.2 预训练包括哪些过程?

预训练通常包括:数据的收集和处理,模型的结构设计和模型训练的优化技术三个部分。不同的模型预训练可能存在一些特殊的情况,但是普遍的情况都会包含上述的三个部分。

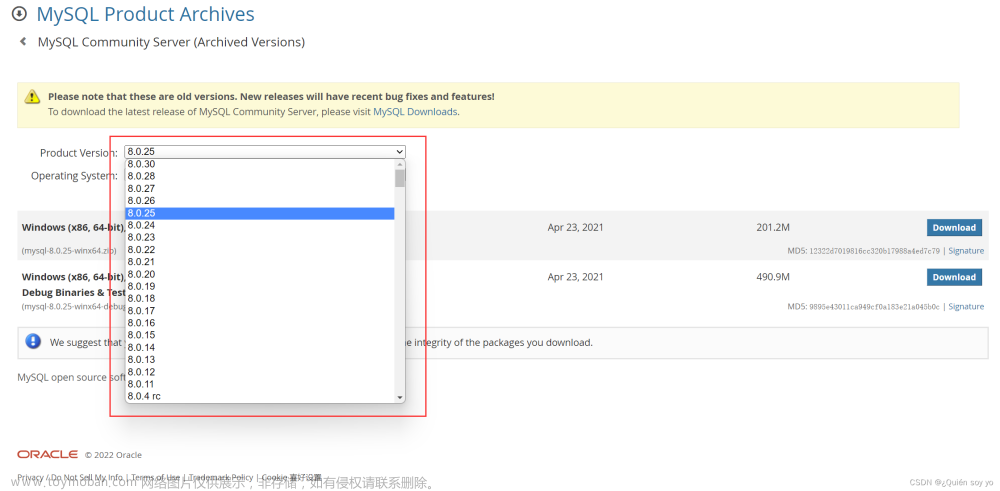

数据预处理

上图中显示的是数据预处理的过程:

- 原始语料(Raw Corpus)输入到质量过滤器(Quality Filtering)进行一些过滤操作,例如:语言过滤,度量过滤,统计过滤,关键词过滤等。

- 过滤后的数据输入到重复过滤器中,去除句子,文档,集合中的重复部分。

- 去重之后的数据输入到隐私过滤器中,检测并去除一些包含个人隐私的信息。

- 去除隐私后的数据输入到分词其中,得到词汇表和数据对应的向量表示。

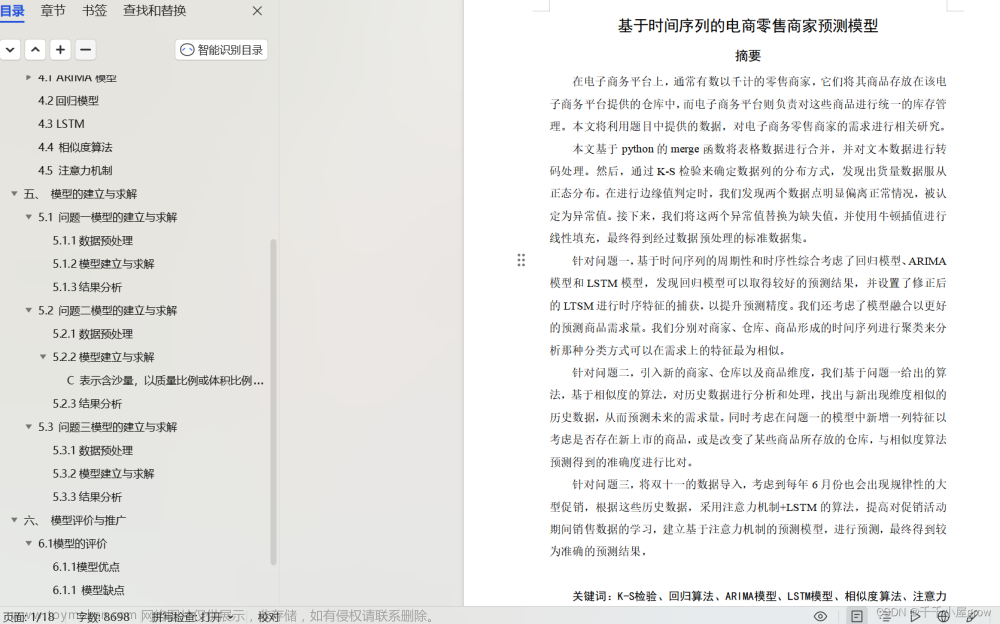

模型训练时各种数据来源的占比

上图中现实的是在预训练过程中各种数据来源的占比.

- 图中可以看出,大部分大语言模型(LLM)都或多或少的使用了网页,书籍和新闻等数据

- 一些特殊的大语言模型(LLM)可能有针对性的使用了一些数据集进行训练或者微调

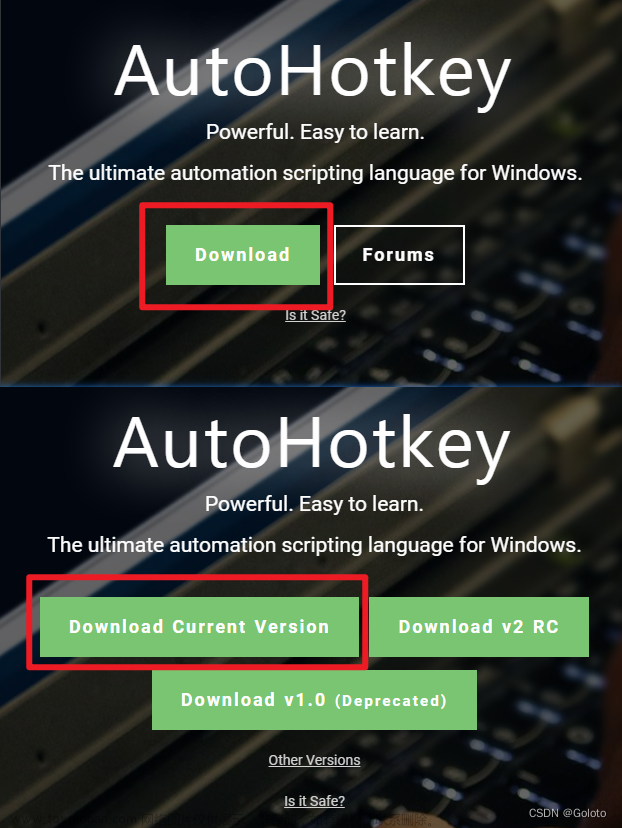

主流的大语言模型架构

主流的大语言模型的架构如上图所示,分别是:因果解码器架构,前缀解码器架构和编码器-解码器架构。

图中蓝色的方块表示前缀token之间的注意力,绿色的方块表示前缀token和目标token之间的注意力,黄色的方块表示目标token之间的注意力,灰色的方块表示掩码注意力。

-

Encoder-Decoder架构: 普通的 Transformer 模型建立在

Encoder-Decoder架构之上,它由两个 Transformer 块组成,分别作为编码器和解码器。编码器采用堆叠的多头自注意层对输入序列进行编码以生成其潜在表示,而解码器对这些表示进行交叉注意并自回归生成目标序列。Encoder-Decoder架构的预训练语言模型(例如 T5 和 BART)已在各种 NLP 任务中显示出有效性。到目前为止,只有少量的大语言模型是基于Encoder-Decoder架构构建的,例如 Flan-T5。 -

Causal Decoder架构:

Causal Decoder架构结合了单向注意掩码,以保证每个输入token只能关注过去的token和它自己。输入和输出token通过解码器以相同的方式处理。作为该架构的代表性语言模型,GPT 系列模型是基于因果解码器架构开发的。特别是,GPT-3 已经成功地证明了这种架构的有效性,也展示了大语言模型惊人的上下文学习能力。有趣的是,GPT-1 和 GPT-2 并没有表现出像 GPT-3 那样优越的能力,而且似乎缩放在增加该模型架构的模型容量方面起着重要作用。到目前为止,Causal Decoder已被各种现有的大语言模型广泛采用作为 大语言模型的体系结构,例如 OPT、BLOOM和 Gopher。请注意,接下来讨论的因果解码器和前缀解码器都属于Decoder-only architecture架构。而在提到Decoder-only architecture时,除非特别说明,否则主要指的是现有文献中的Causal decoder architecture。 -

Prefix Decoder架构(又名,非因果解码器)修改了

Causal Decoder的掩码机制,以实现对前缀token的双向关注和仅对生成的token的单向关注。这样,与Encoder-Decoder架构一样,前缀解码器可以对前缀序列进行双向编码,并自回归地逐个预测输出token,其中在编码和解码期间共享相同的参数。与其从头开始预训练,一个实用的建议是不断训练因果解码器,然后将它们转换为前缀解码器以加速收敛,例如,U-PaLM 源自 PaLM。现有的基于前缀解码器的代表性 LLM 包括 ChatGLM和 U-PaLM。

2.2 适配微调

大语言模型(LLM)可以获得解决各种任务的通用能力,但是研究表明,可以通过进一步的适配是的大模型能够更好的解决特定的问题。

综述中主要谈及了两种常见的大语言模型的微调方法,分别是指令微调(instruction tuning)和对齐微调(alignment tuning)

2.2.1 指令微调(instruction tuning)

指令微调是在自然语言格式的实例集合上微调预训练后的LLM的方法。这种发方法与有监督微调和多任务提示训练密切相关,旨在增强(或解锁) LLM的能力。

2.2.2 对齐微调(alignment tuning)

对齐微调旨在将LLM的行为与人类的价值观或偏好对齐。减少大语言模型生成一些有毒,有攻击性,有种族或者性别歧视等多种有悖于人类价值观的结果。

2.3 使用

经过预训练或适配微调之后,使用LLM的主要方法是为解决各种任务设计适当的提示策略。本综述介绍了两种典型的提示策略,分别是:上下文学习(in-contextlearning, ICL)和思维链提示(chain-of-thought prompting)。

2.3.1 上下文学习(in-context learning, ICL)

上下文学习(ICL)是典型的提示方法是将任务描述以自然语言文本的形式表达的上下文学习。上下文学习(ICL)使用一种由任务描述和作为示范的几个任务样例构成的自然语言提示。

我的理解:简单来说,上下文学习(ICL)就是给一段上下文,然后给一个问题,让大模型回答这个问题。没有中间的推理过程,只是回答给出的问题。

2.3.2 思维链提示(chain-of-thought prompting)

思维链提示(chain-of-thought prompting)可以通过将一系列中间推理步骤加入提示中来增强上下文学习(ICL)。

思维链(CoT)是一种改进的提示策略,旨在提高大语言模型(LLM)在复杂推理任务中的性能,例如算术推理,常识推理和符号推理。

不同于上下文学习(ICL)中仅使用输入输出对来构造提示,思维链(CoT)将可以导出最终输出的中间推理步骤纳入提示中。

我的理解:思维链提示(chain-of-thought prompting)是一种特殊的上下文学习(ICL)。思维链将中间的推理过程也用于提示,可以提高大语言模型在复杂推理任务中的性能。

上下文学习(ICL)和思维链(CoT)提示的比较说明。ICL用自然语言描述、几个演示和一个测试查询来提示LLM,而CoT提示涉及提示中的一系列中间推理步骤。

- 绿色部分表示任务的描述

- 浅蓝色部分表示问题的示例

- 蓝色部分表示中间推理的步骤(思维链)

- 黄色部分表示需要回答的问题

2.4 能力评估

为了检验LLM的有效性和优越性,已有研究采用了大量的任 务和基准数据集来进行实证评估和分析。综述中介绍了大语言模型(LLM)在

语言生成和语言理解方面的三种基本评估任务。

2.4.1 语言生成

现有语言生成的任务主要可以分为语言建模、 条件文本生成和代码合成任务。需要注意的是,代码合成不 是典型的自然语言处理任务,但可以直接地用(经过代码数 据训练的)LLM以类似自然语言文本生成的方法解决。

- 语言建模:语言建模是大语言模型(LLM)的基本能力,旨在基于前一个 token 预测下一个 token,主要关注基本的语言理解和生 成能力。

- 条件文本生成:条件文本生成旨在基于给定的条件生成满足特定任务需求的文本, 通常包括机器翻译、文本摘要和问答系统等。

- 代码合成:除了生成高质量的自然语言外,现有的大语言模型(LLM)还表现出强大的生成形式语言的能力,尤其是满足特定条件的计算机程序,这种能力被称为代码合成。

2.4.2 知识利用

知识利用是一种智能系统基于事实证据的支撑,完成知识密集型任务的重要能力(例如常识问题回答和事实补全)。具体而言,它要求大语言模型(LLM)适当地利用来自预训练语料库的丰富事实知识,或在必要的时候检索外部数据。现有的知识利用任务分为三种类型,即闭卷问答,开卷问答和知识补全。

- 闭卷问答:闭卷问答任务测试大语言模型(LLM)从预训练语料库中习得的事实知识。大语言模型(LLM)只能基于给定的上下文回答问题, 而不能使用外部资源。

- 开卷问答:与闭卷问答不同,在开卷问答任务中,大语言模型大语言模型(LLM)可以从外部知识库或文档集合中提取有用的证据,然后基于提取的证据回答问题。

- 知识补全:在知识补全任务中,大语言模型(LLM)可以被视为一个知识库,补全或预测知识单元的缺失部分。这种任务可以探索和评估大语言模型(LLM)从预训 练数据中学习到的知识的数量和种类。

2.4.3 复杂推理

复杂推理是指理解和利用相关的证据或逻辑来推导结论或做出决策的能力。根据推理过程中涉及的逻辑和证据类型,我们考虑将现有的评估任务分为三个主要类别,即知识推理、符号推理和数学推理。

- 知识推理:知识推理任务依赖于逻辑关系和事实知识的证据来回答给定的问题。

- 符号推理:符号推理任务主要关注于在形式化规则设定中操作符号以实现某些特定目标,且这些操作和规则可能在大语言模型(LLM)预训练期间从未被看到过。

- 数学推理:数学推理任务需要综合利用数学知识、逻辑和计算来解决问题或生成证明过程。

大语言模型(LLM)的基础评测任务和相应的代表性数据集

| Level | Ability | Task | Dataset |

|---|---|---|---|

| Basic | Language Generation | Language Modeling | Penn Treebank, WikiText-103, the Pile, LAMBADA |

| Conditional Text Generation | WMT’14,16,19,20,21,22, Flores-101, DiaBLa, CNN/DailyMail, XSum, WikiLingua OpenDialKG | ||

| Code Synthesis | APPS, HumanEval, MBPP, CodeContest, MTPB, DS-1000, ODEX | ||

| Knowledge Utilization | Closed-Book QA | Natural Questions, ARC, TruthfulQA, Web Questions, TriviaQA, PIQA, LC-quad2.0, GrailQA, KQApro, CWQ, MKQA, ScienceQA | |

| Open-Book QA | Natural Questions, OpenBookQA, ARC, TriviaQA, Web Questions, MS MARCO, QASC, SQuAD, WikiMovies | ||

| Knowledge Completion | WikiFact, FB15k-237, Freebase, WN18RR, WordNet, LAMA, YAGO3-10,YAGO | ||

| Complex Reasoning | Knowledge Reasoning | CSQA, StrategyQA, HotpotQA, ARC, BoolQ, PIQA, SIQA, HellaSwag, WinoGrande, COPA, OpenBookQA, ScienceQA, proScript, ProPara, ExplaGraphs, ProofWriter, EntailmentBank, ProOntoQA | |

| Symbolic Reasoning | CoinFlip, ReverseList, LastLetter, Boolean Assignment, Parity, Colored Object, Penguins in a Table, Repeat Copy, Object Counting | ||

| Mathematical Reasoning | MATH, GSM8k, SVAMP, MultiArith, ASDiv, MathQA, AQUA-RAT, MAWPS, DROP, NaturalProofs, PISA, miniF2F, ProofNet | ||

| Advanced | Human Alignment | Honestness | TruthfulQA, HaluEval |

| Helpfulness | HH-RLHF | ||

| Harmlessness | HH-RLHF, Crows-Pairs WinoGender, RealToxicityPrompts | ||

| Interaction with External Environment | Household | VirtualHome, BEHAVIOR, ALFRED ,ALFWorld | |

| Website Environment | WebShop, Mind2Web | ||

| Open World | MineRL, MineDojo | ||

| Tool Manipulation | Search Engine | HotpotQA, TriviaQA, Natural Questions | |

| Code Executor | GSM8k, TabMWP, Date Understanding | ||

| Calculator | GSM8k, MATH, CARP | ||

| Model Interface | GPT4Tools, Gorilla | ||

| Data Interface | WebQSP, MetaQA, WTQ WikiSQL, TabFact, Spider |

3 总结与未来方向

3.1 总结

本文的主要贡献:

- 本文综述了大语言模型(LLM)的最新进展,并介绍了大语言模型(LLM)的主要概念、研究成果以及理解和利用大语言模型(LLM)的技术。

- 本文主要介绍了大小超过10B的大语言模型,没有考虑早期的预训练语言模型,例如:Bert、GPT-2等。

- 本文讨论了大语言模型(LLM)的四个重要方面,分别是:预训练、适配微调、使用和能力评估。

- 本文总结了开发大语言模型(LLM)的可用资源,并讨论了实现大语言模型(LLM)的重要技术以便复现大语言模型(LLM)。

- 本文的目标是涵盖关于大语言模型(LLM)的最新文献,并为研究人员和工程师提供一份有关这个主题的优质参考资料。

3.2 未来方向

本文最后在一下几个方面,介绍了大语言模型(LLM)的挑战和未来方向:文章来源:https://www.toymoban.com/news/detail-711372.html

- 理论和原理:

- 挑战:

- 大语言模型(LLM)的运行机制目前还不是非常的明朗,例如:大模型的涌现能力出现的原因。

- 大语言模型(LLM)如何通过非常大且深的神经网络分配、组织和利用信息。

- 理解、描述和解释大语言模型(LLM)的能力或行为的正式理论和原理仍然缺失。

- 未来方向:

- 对于大语言模型(LLM)的涌现能力的解释和研究。

- 对于大语言模型(LLM)对于信息的利用、分配、组织方式进行研究。

- 建立和完善理解、描述和解释大语言模型(LLM)的能力或行为的理论和原理。

- 挑战:

- 模型架构:

- 挑战:

- 减少标准自注意力机制所带来的时间复杂度是一个实际应用时重要的考虑因素。

-

灾难性遗忘一直是神经网络的长期挑战,其对大语言模型(LLM)也有负面影响。

- 未来方向:

- 研究如何构建大语言模型(LLM)中更高效的

Transformer变体十分重要,例如 GPT-3 中已经使用了稀疏注意力。 - 考虑将现有架构扩展到更具灵活性的机制或模块,以有效支持数据更新和任务专用化。

- 研究如何构建大语言模型(LLM)中更高效的

- 挑战:

- 模型训练:

- 挑战:

- 预训练强大的大语言模型(LLM)需要消耗巨大的算力,并且对

数据质量和训练技巧要求很高。

- 预训练强大的大语言模型(LLM)需要消耗巨大的算力,并且对

- 未来方向:

- 开发更系统、经济的预训练方法以优化大语言模型(LLM)变得尤为重要,同时考虑到模型有效性、效率优化和训练稳定性等因素。

- 挑战:

- 模型应用:

- 挑战:

- 由于在实际应用中微调的成本非常高,提示已成 为使用大语言模型(LLM)的主要方法,但是提示设计时需要大量人力。

- 一些复杂任务(例如形式证明和数值计算)需要特定的知识或逻辑规则,这些规则可能无法用自然语言很好地表达或通过示例演示。

- 未来方向:

- 研究如何自动生成有用且高校的提示以解决各种任务。

- 开发更具信息量和灵活性的任务格式化方法以进行提示非常重要。

- 挑战:

- 安全与对齐:

- 挑战:

- 大语言模型(LLM)倾向于产生幻觉, 这些文本看似合理,但可能在事实上是错误的。例如:ChatGPT 刚发布的时候存在"一本正经的胡说八道"的情况。

- 现有的方法避免大语言模型(LLM)产生幻觉或者生成一些有毒,有害,有偏见的文本主要是讲人工纳入训练循环 来开发良好对齐的大语言模型(LLM),并使用人类反馈强化学习(RLHF)。但是这严重依赖专业标注者的高质量人类反馈数据,这使得它在实践中难以适当实施。

- 未来方向:

- 研究如何避免大语言模型(LLM)产生幻觉或者生成一些有毒,有害,有偏见的文本。

- 有必要改进人类反馈强化学习(RLHF)框架以减少人类标注者的工作量,并寻求更高效的、具有保证数据质量的标注方法,例如LLM可以用于辅助标注工作。

- 挑战:

4 关于大语言模型的最新文献综述

4.1 大语言模型列表:

| 分类 | 模型 | 发表时间 | 大小(B) | 链接 |

|---|---|---|---|---|

| 开源 大模型 |

T5 | 2019/10 | 11 | 论文链接 |

| mT5 | 2021/03 | 13 | 论文链接 | |

| PanGu-α | 2021/05 | 13 | 论文链接 | |

| CPM-2 | 2021/05 | 198 | 论文链接 | |

| T0 | 2021/10 | 11 | 论文链接 | |

| GPT-NeoX-20B | 2022/02 | 20 | 论文链接 | |

| CodeGen | 2022/03 | 16 | 论文链接 | |

| Tk-Instruct | 2022/04 | 11 | 论文链接 | |

| UL2 | 2022/02 | 20 | 论文链接 | |

| OPT | 2022/05 | 175 | 论文链接 | |

| YaLM | 2022/06 | 100 | GitHub | |

| NLLB | 2022/07 | 55 | 论文链接 | |

| BLOOM | 2022/07 | 176 | 论文链接 | |

| GLM | 2022/08 | 130 | 论文链接 | |

| Flan-T5 | 2022/10 | 11 | 论文链接 | |

| mT0 | 2022/11 | 13 | 论文链接 | |

| Galatica | 2022/11 | 120 | 论文链接 | |

| BLOOMZ | 2022/11 | 176 | 论文链接 | |

| OPT-IML | 2022/12 | 175 | 论文链接 | |

| Pythia | 2023/01 | 12 | 论文链接 | |

| LLaMA | 2023/02 | 65 | 论文链接 | |

| Vicuna | 2023/03 | 13 | Blog | |

| ChatGLM | 2023/03 | 6 | GitHub | |

| CodeGeeX | 2023/03 | 13 | 论文链接 | |

| Koala | 2023/04 | 13 | Blog | |

| 不开源 大模型 |

GShard | 2020/01 | 600 | 论文链接 |

| GPT-3 | 2020/05 | 175 | 论文链接 | |

| LaMDA | 2021/05 | 137 | 论文链接 | |

| HyperCLOVA | 2021/06 | 82 | 论文链接 | |

| Codex | 2021/07 | 12 | 论文链接 | |

| ERNIE 3.0 | 2021/07 | 10 | 论文链接 | |

| Jurassic-1 | 2021/08 | 178 | 论文链接 | |

| FLAN | 2021/10 | 137 | 论文链接 | |

| MT-NLG | 2021/10 | 530 | 论文链接 | |

| Yuan 1.0 | 2021/10 | 245 | 论文链接 | |

| Anthropic | 2021/12 | 52 | 论文链接 | |

| WebGPT | 2021/12 | 175 | 论文链接 | |

| Gopher | 2021/12 | 280 | 论文链接 | |

| ERNIE 3.0 Titan | 2021/12 | 260 | 论文链接 | |

| GLaM | 2021/12 | 1200 | 论文链接 | |

| InstructGPT | 2022/01 | 175 | 论文链接 | |

| AlphaCode | 2022/02 | 41 | 论文链接 | |

| Chinchilla | 2022/03 | 70 | 论文链接 | |

| PaLM | 2022/04 | 540 | 论文链接 | |

| Cohere | 2022/06 | 54 | Homepage | |

| AlexaTM | 2022/08 | 20 | 论文链接 | |

| Luminous | 2022/09 | 70 | Docs | |

| Sparrow | 2022/09 | 70 | 论文链接 | |

| WeLM | 2022/09 | 10 | 论文链接 | |

| U-PaLM | 2022/10 | 540 | 论文链接 | |

| Flan-PaLM | 2022/10 | 540 | 论文链接 | |

| Flan-U-PaLM | 2022/10 | 540 | 论文链接 | |

| Alpaca | 2023/03 | 7 | Blog | |

| GPT-4 | 2023/3 | - | 论文链接 | |

| PanGU-Σ | 2023/3 | 1085 | 论文链接 |

4.2 大模型相关论文

4.2.1 开源大模型论文:

- T5: "Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer". Colin Raffel et al. JMLR 2019. [Paper] [Checkpoint]

- mT5: "mT5: A massively multilingual pre-trained text-to-text transformer". Linting Xue et al. NAACL 2021. [Paper] [Checkpoint]

- PanGu-α: "PanGu-α: Large-scale Autoregressive Pretrained Chinese Language Models with Auto-parallel Computation". Wei Zeng et al. arXiv 2021. [Paper] [Checkpoint]

- CPM-2: "CPM-2: Large-scale Cost-effective Pre-trained Language Models". Zhengyan Zhang et al. arXiv 2021. [Paper] [Checkpoint]

- T0: "Multitask Prompted Training Enables Zero-Shot Task Generalization". Victor Sanh et al. ICLR 2022. [Paper] [Checkpoint]

- GPT-NeoX-20B: "GPT-NeoX-20B: An Open-Source Autoregressive Language Model". Sid Black et al. arXiv 2022. [Paper] [Checkpoint]

- CodeGen: "CodeGen: An Open Large Language Model for Code with Multi-Turn Program Synthesis". Erik Nijkamp et al. arXiv 2022. [Paper] [Checkpoint]

- Tk-Instruct: "Super-NaturalInstructions: Generalization via Declarative Instructions on 1600+ NLP Tasks". Yizhong Wang et al. EMNLP 2022. [Paper] [Checkpoint]

- UL2: "UL2: Unifying Language Learning Paradigms". Yi Tay et al. arXiv 2022. [Paper] [Checkpoint]

- OPT: "OPT: Open Pre-trained Transformer Language Models". Susan Zhang et al. arXiv 2022. [Paper] [Checkpoint]

- NLLB: "No Language Left Behind: Scaling Human-Centered Machine Translation". NLLB Team. arXiv 2022. [Paper] [Checkpoint]

- BLOOM: "BLOOM: A 176B-Parameter Open-Access Multilingual Language Model". BigScience Workshop. arXiv 2022. [Paper] [Checkpoint]

- GLM: "GLM-130B: An Open Bilingual Pre-trained Model". Aohan Zeng et al. arXiv 2022. [Paper] [Checkpoint]

- Flan-T5: "Scaling Instruction-Finetuned Language Models". Hyung Won Chung et al. arXiv 2022. [Paper] [Checkpoint]

- mT0 && BLOOMZ: "Crosslingual Generalization through Multitask Finetuning". Niklas Muennighoff et al. arXiv 2022. [Paper] [Checkpoint]

- Galactica: "Galactica: A Large Language Model for Science". Ross Taylor et al. arXiv 2022. [Paper] [Checkpoint]

- OPT-IML: "OPT-IML: Scaling Language Model Instruction Meta Learning through the Lens of Generalization". Srinivasan et al. . arXiv 2022. [Paper] [Checkpoint]

- CodeGeeX: "CodeGeeX: A Pre-Trained Model for Code Generation with Multilingual Evaluations on HumanEval-X". Qinkai Zheng et al. . arXiv 2023. [Paper] [Checkpoint]

- Pythia: "Pythia: A Suite for Analyzing Large Language Models Across Training and Scaling". Stella Biderman et al. . arXiv 2023. [Paper] [Checkpoint]

- LLaMA: "LLaMA: Open and Efficient Foundation Language Models". Hugo Touvron et al. arXiv 2023. [Paper] [Checkpoint]

4.2.2 不开源大模型论文:

- GShard: "GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding". Dmitry Lepikhin et al. ICLR 2021. [Paper]

- GPT-3: "Language Models are Few-Shot Learners". Tom B. Brown et al. NeurIPS 2020. [Paper]

- LaMDA: "LaMDA: Language Models for Dialog Applications". Romal Thoppilan et al. arXiv 2021. [Paper]

- HyperCLOVA: "What Changes Can Large-scale Language Models Bring? Intensive Study on HyperCLOVA: Billions-scale Korean Generative Pretrained Transformers". Boseop Kim et al. EMNLP 2021. [Paper]

- CodeX: "Evaluating Large Language Models Trained on Code". Mark Chen et al. arXiv 2021. [Paper]

- ERNIE 3.0: "ERNIE 3.0: Large-scale Knowledge Enhanced Pre-training for Language Understanding and Generation". Yu Sun et al. arXiv 2021. [Paper]

- Jurassic-1: "Jurassic-1: Technical details and evaluation". Opher Lieber et al. 2021. [Paper]

- FLAN: "Finetuned Language Models Are Zero-Shot Learners". Jason Wei et al. ICLR 2021. [Paper]

- MT-NLG: "Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, A Large-Scale Generative Language Model". Shaden Smith et al. arXiv 2021. [Paper]

- Yuan 1.0: "Yuan 1.0: Large-Scale Pre-trained Language Model in Zero-Shot and Few-Shot Learning". Shaohua Wu et al. arXiv 2021. [Paper]

- Anthropic: "A General Language Assistant as a Laboratory for Alignment" . Amanda Askell et al. arXiv 2021. [Paper]

- WebGPT: "WebGPT: Browser-assisted question-answering with human feedback" . Reiichiro Nakano et al. arXiv 2021. [Paper]

- Gopher: "Scaling Language Models: Methods, Analysis & Insights from Training Gopher". Jack W. Rae et al. arXiv 2021. [Paper]

- ERNIE 3.0 Titan: "ERNIE 3.0 Titan: Exploring Larger-scale Knowledge Enhanced Pre-training for Language Understanding and Generation". *Shuohuan Wang et al. *arXiv 2021. [Paper]

- GLaM: "GLaM: Efficient Scaling of Language Models with Mixture-of-Experts". Nan Du et al. ICML 2022. [Paper]

- InstructGPT: "Training language models to follow instructions with human feedback". Long Ouyang et al. arXiv 2022. [Paper]

- AlphaCode: "Competition-Level Code Generation with AlphaCode". Yujia Li et al. arXiv 2022. [Paper]

- Chinchilla: "Training Compute-Optimal Large Language Models". Jordan Hoffmann et al. arXiv. [Paper]

- PaLM: "PaLM: Scaling Language Modeling with Pathways". Aakanksha Chowdhery et al. arXiv 2022. [Paper]

- AlexaTM: "AlexaTM 20B: Few-Shot Learning Using a Large-Scale Multilingual Seq2Seq Model". Saleh Soltan et al. arXiv 2022. [Paper]

- Sparrow: "Improving alignment of dialogue agents via targeted human judgements". Amelia Glaese et al. . arXiv 2022. [Paper]

- WeLM: "WeLM: A Well-Read Pre-trained Language Model for Chinese". Hui Su et al. . arXiv 2022. [Paper]

- U-PaLM: "Transcending Scaling Laws with 0.1% Extra Compute". Yi Tay et al. arXiv 2022. [Paper]

- Flan-PaLM && Flan-U-PaLM: "Scaling Instruction-Finetuned Language Models". Hyung Won Chung et al. arXiv. [Paper]

- GPT-4: "GPT-4 Technical Report". OpenAI. arXiv 2023. [Paper]

- PanGu-Σ: "PanGu-Σ: Towards Trillion Parameter Language Model with Sparse Heterogeneous Computing". Xiaozhe Ren et al. arXiv 2023. [Paper]

4.2.3 常用语料库

- BookCorpus: "Aligning Books and Movies: Towards Story-like Visual Explanations by Watching Movies and Reading Books". Yukun Zhu et al. ICCV 2015. [Paper] [Source]

- Guntenburg: [Source]

- CommonCrawl: [Source]

- C4: "Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer". Colin Raffel et al. JMLR 2019. [Paper] [Source]

- CC-stories-R: "A Simple Method for Commonsense Reasoning". Trieu H. Trinh el al. arXiv 2018. [Paper] [Source]

- CC-NEWS: "RoBERTa: A Robustly Optimized BERT Pretraining Approach". Yinhan Liu et al. arXiv 2019. [Paper] [Source]

- REALNEWs: "Defending Against Neural Fake News". Rowan Zellers et al. NeurIPS 2019. [Paper] [Source]

- OpenWebText: [Source]

- Pushshift.io: "The Pushshift Reddit Dataset". Jason Baumgartner et al. AAAI 2020. [Paper] [Source]

- Wikipedia: [Source]

- BigQuery: [Source]

- The Pile: "The Pile: An 800GB Dataset of Diverse Text for Language Modeling". Leo Gao et al. arxiv 2021. [Paper] [Source]

- ROOTS: "The BigScience ROOTS Corpus: A 1.6TB Composite Multilingual Dataset". Laurençon et al. NeurIPS 2022 Datasets and Benchmarks Track. [paper]

4.2.4 深度学习框架

- Pytorch: "PyTorch: An Imperative Style, High-Performance Deep Learning Library". Adam Paszke el al. NeurIPS 2019. [Paper] [Source]

- TensorFlow: "TensorFlow: A system for large-scale machine learning". Martín Abadi et al. OSDI 2016. [Paper] [Source]

- MXNet: "MXNet: A Flexible and Efficient Machine Learning Library for Heterogeneous Distributed Systems". Tianqi Chen et al. arXiv 2015. [Paper] [Source]

- PaddlePaddle: "PaddlePaddle: An Open-Source Deep Learning Platform from Industrial Practice" . Yanjun Ma et al. Frontiers of Data and Domputing 2019. [Paper] [Source]

- MindSpore: "Huawei MindSpore AI Development Framework" . Huawei Technologies Co., Ltd. Artificial Intelligence Technology 2022. [Paper] [Source]

- OneFlow: "OneFlow: Redesign the Distributed Deep Learning Framework from Scratch" . Jinhui Yuan et al. arXiv 2021. [Paper] [Source]

- 原文地址:A Survey of Large Language Models (arxiv.org)

- 知乎地址:大模型综述升级啦 (zhihu.com)

- Github link:A Survey of Large Language Models(github.com)

- 中文版本:LLM_Survey_Chinese.pdf (github.com)

如果觉得文章对你有帮助的话,欢迎引用文章的原文文章来源地址https://www.toymoban.com/news/detail-711372.html

@article{LLMSurvey,

title={A Survey of Large Language Models},

author={Zhao, Wayne Xin and Zhou, Kun and Li, Junyi and Tang, Tianyi and Wang, Xiaolei and Hou, Yupeng and Min, Yingqian and Zhang, Beichen and Zhang, Junjie and Dong, Zican and Du, Yifan and Yang, Chen and Chen, Yushuo and Chen, Zhipeng and Jiang, Jinhao and Ren, Ruiyang and Li, Yifan and Tang, Xinyu and Liu, Zikang and Liu, Peiyu and Nie, Jian-Yun and Wen, Ji-Rong},

year={2023},

journal={arXiv preprint arXiv:2303.18223},

url={http://arxiv.org/abs/2303.18223}

}

到了这里,关于1 2023-10-25 组会分享的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!