Ø练习 1:

//通过并行化生成 rdd

val rdd1 = sc.parallelize(List(5, 6, 4, 7, 3, 8, 2, 9, 1, 10))

//对 rdd1 里的每一个元素乘 2 然后排序

val rdd2 = rdd1.map(_ * 2).sortBy(x => x, true)

//过滤出大于等于十的元素

val rdd3 = rdd2.filter(_ >= 10)

//将元素以数组的方式在客户端显示

rdd3.collectØ 练习 2:

val rdd1 = sc.parallelize(Array("a b c", "d e f", "h i j"))

//将 rdd1 里面的每一个元素先切分在压平

val rdd2 = rdd1.flatMap(_.split(' '))

rdd2.collectØ 练习 3:

val rdd1 = sc.parallelize(List(5, 6, 4, 3))

val rdd2 = sc.parallelize(List(1, 2, 3, 4))

//求并集

val rdd3 = rdd1.union(rdd2)

//求交集

val rdd4 = rdd1.intersection(rdd2)

//去重

rdd3.distinct.collect

rdd4.collectØ 练习 4:

val rdd1 = sc.parallelize(List(("tom", 1), ("jerry", 3), ("kitty", 2)))

val rdd2 = sc.parallelize(List(("jerry", 2), ("tom", 1), ("shuke", 2)))

//求 jion

val rdd3 = rdd1.join(rdd2)

rdd3.collect

//求并集

val rdd4 = rdd1 union rdd2

//按 key 进行分组

val rdd5=rdd4.groupByKey

rdd5.collectØ 练习 5:

val rdd1 = sc.parallelize(List(("tom", 1), ("tom", 2), ("jerry", 3), ("kitty", 2)))

val rdd2 = sc.parallelize(List(("jerry", 2), ("tom", 1), ("shuke", 2)))

//cogroup

val rdd3 = rdd1.cogroup(rdd2)

//注意 cogroup 与 groupByKey 的区别groupByKey

groupByKey会将RDD[key,value]按照相同的key进行分组,形成RDD[key,iterable[value]]的形式,有点类似于sql中的groupby,例如类似于mysql中的group_contact

cogroup

groupByKey是对单个RDD的数据进行分组,还可以使用一个叫作cogroup()的函数对多个共享同一个键的RDD进行分组

例:RDD1.cogroup(RDD2)会将RDD1和RDD2按照相同的key进行分组,得到(key,RDD[key,Iterable[value1],Iterable[value2]])的形式

cogroup也可以多个进行分组

例:RDD1.cogroup(RDD2,RDD3,…RDDN),可以得到

(key,Iterable[value1],Iterable[value2],Iterable[value3],…,Iterable[valueN])

rdd3.collect

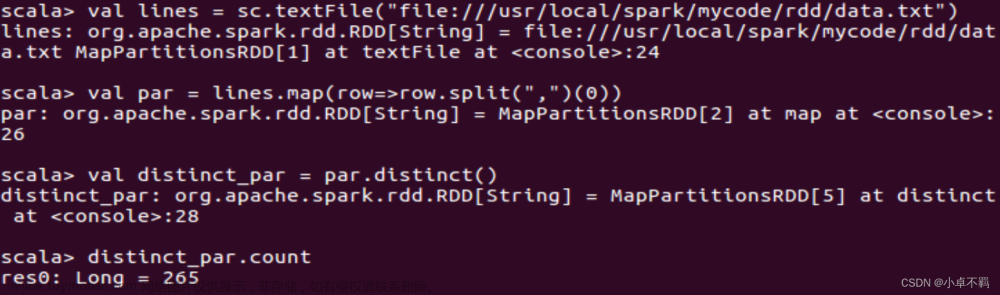

Ø 练习 6:文章来源:https://www.toymoban.com/news/detail-713149.html

val rdd1 = sc.parallelize(List(1, 2, 3, 4, 5,6,7,8,9,10))

//reduce 聚合

val rdd2 = rdd1.reduce(_ + _)

//rdd2.collectØ 练习 7:文章来源地址https://www.toymoban.com/news/detail-713149.html

val rdd1 = sc.parallelize(List(("tom", 1), ("jerry", 3), ("kitty", 2), ("shuke", 1)))

val rdd2 = sc.parallelize(List(("jerry", 2), ("tom", 3), ("shuke", 2), ("kitty", 5)))

val rdd3 = rdd1.union(rdd2)

//按 key 进行聚合

val rdd4 = rdd3.reduceByKey(_ + _)

rdd4.collect

//按 value 的降序排序

val rdd5 = rdd4.map(t => (t._2, t._1)).sortByKey(false).map(t => (t._2, t._1))

rdd5.collect到了这里,关于2023_Spark_实验十:RDD基础算子操作的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!