一、问题

现象

Spark 任务速度变慢,也不失败。

DataNode 内存足够 CPU 负载不高 GC 时间也不长。

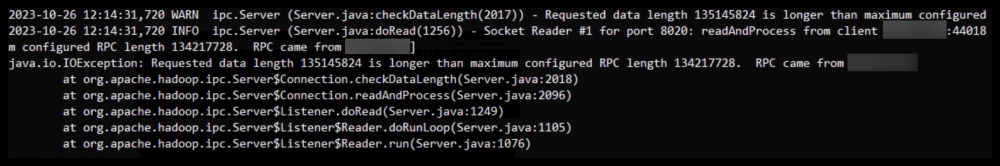

查看 DataNode 日志,发现有些日志出现很多 Netty RPC 超时。超时的 destination 是一个 NameNode 节点,然后查看 NameNode 节点的日志,报错如下:

二、解决方案

查找对应 Hadopo 源码

源码

org.apache.hadoop.ipc.Server.Connection#checkDataLength

private void checkDataLength(int dataLength) throws IOException {

if (dataLength < 0) {

String error = "Unexpected data length " + dataLength +

"!! from " + getHostAddress();

LOG.warn(error);

throw new IOException(error);

} else if (dataLength > maxDataLength) {

String error = "Requested data length " + dataLength +

" is longer than maximum configured RPC length " +

maxDataLength + ". RPC came from " + getHostAddress();

LOG.warn(error);

throw new IOException(error); // <-------------- 异常从此处抛出来

}

}

this.maxDataLength = conf.getInt(CommonConfigurationKeys.IPC_MAXIMUM_DATA_LENGTH,

CommonConfigurationKeys.IPC_MAXIMUM_DATA_LENGTH_DEFAULT);

/** Max request size a server will accept. */

public static final String IPC_MAXIMUM_DATA_LENGTH =

"ipc.maximum.data.length";

/** Default value for IPC_MAXIMUM_DATA_LENGTH. */

public static final int IPC_MAXIMUM_DATA_LENGTH_DEFAULT = 64 * 1024 * 1024;

修改NameNode的hdfs-site.xml配置文件,添加以下配置:

<property>

<name>ipc.maximum.data.length</name>

<value>67108864</value>

<description>This indicates the maximum IPC message length (bytes) that can be

accepted by the server. Messages larger than this value are rejected by the

immediately to avoid possible OOMs. This setting should rarely need to be

changed.

</description>

</property>

64M -> 256M

67108864 * 4 = 268435456

允许ipc通讯最大的数据包为256MB,默认配置为64MB。文章来源:https://www.toymoban.com/news/detail-714510.html

最后重启 NameNode,再重启 DataNode。文章来源地址https://www.toymoban.com/news/detail-714510.html

到了这里,关于Hadoop 请求数据长度 Requested Data length 超过配置的最大值的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!