作者:禅与计算机程序设计艺术

1.简介

数据流是一个连续不断的、产生、存储和处理数据的过程。传统上,数据流编程都是基于特定平台(比如:消息队列,数据仓库,事件溯源)的SDK或者API进行开发,但随着云计算和容器技术的发展,越来越多的企业选择使用开源工具实现自己的大数据处理系统。其中Apache Flink和Apache Kafka这两个开源项目提供了丰富的数据处理能力。

本文将从Flink和Kafka的基本用法出发,通过一个案例来介绍如何利用这两个框架构建一个实时的数据流管道。阅读本文后,读者应该能够理解并掌握以下知识点:

- Flink与Kafka的特点及区别

- 数据流编程模型:时间复杂度分析和异步计算

- 用Flink实现实时数据处理的基本流程

- 使用Flink进行批量和流数据处理的案例

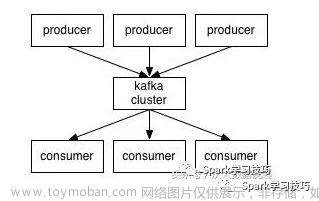

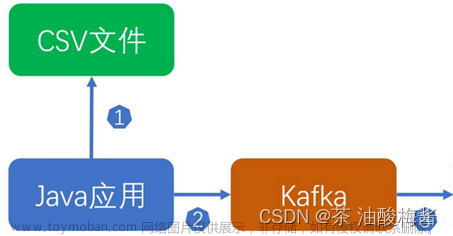

- 使用Kafka进行消息发布和订阅的基本用法

- 在Flink中如何消费和持久化Kafka中的数据

- Flink的数据分发模型

- 扩展阅读

2.背景介绍

2.1 数据流模型

数据流模型在实际应用中扮演着至关重要的角色。在过去的几年里,数据流的研究已经成为当今领域的一个热门话题。如今人们对数据处理效率和响应速度都要求极高,因此需要对数据流进行更精细的管理,包括:文章来源:https://www.toymoban.com/news/detail-714616.html

- 消息传递延迟的控制

- 流量控制

- 错误恢复

- 动态水平缩放

为了实现这些目标,数据流编程语言(DSL)逐渐成熟,其主要特征有:文章来源地址https://www.toymoban.com/news/detail-714616.html

- 提供了对数据流图的定义

- 通过异步计算提高吞吐量<

到了这里,关于2 Data Streaming Pipelines With Flink and Kafka的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!