hadoop集群启动jps后没有namenode

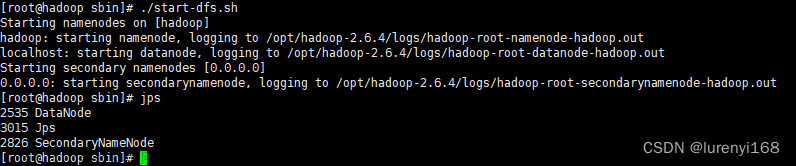

启动集群jps后出现:

1.关闭集群

stop-all.sh

2.切换到hadoop的目录下将logs与tmp文件与内容删除并创建新的logs

cd /usr/local/hadoop

rm -rf tmp

rm -rf logs

mkdir logs

3.重新格式化namenode

hdfs namenode -format

4.重新启动后集群文章来源:https://www.toymoban.com/news/detail-714990.html

start-all.sh

文章来源地址https://www.toymoban.com/news/detail-714990.html

文章来源地址https://www.toymoban.com/news/detail-714990.html

到了这里,关于hadoop集群启动master节点jps后没有namenode解决方案的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!