摘要:

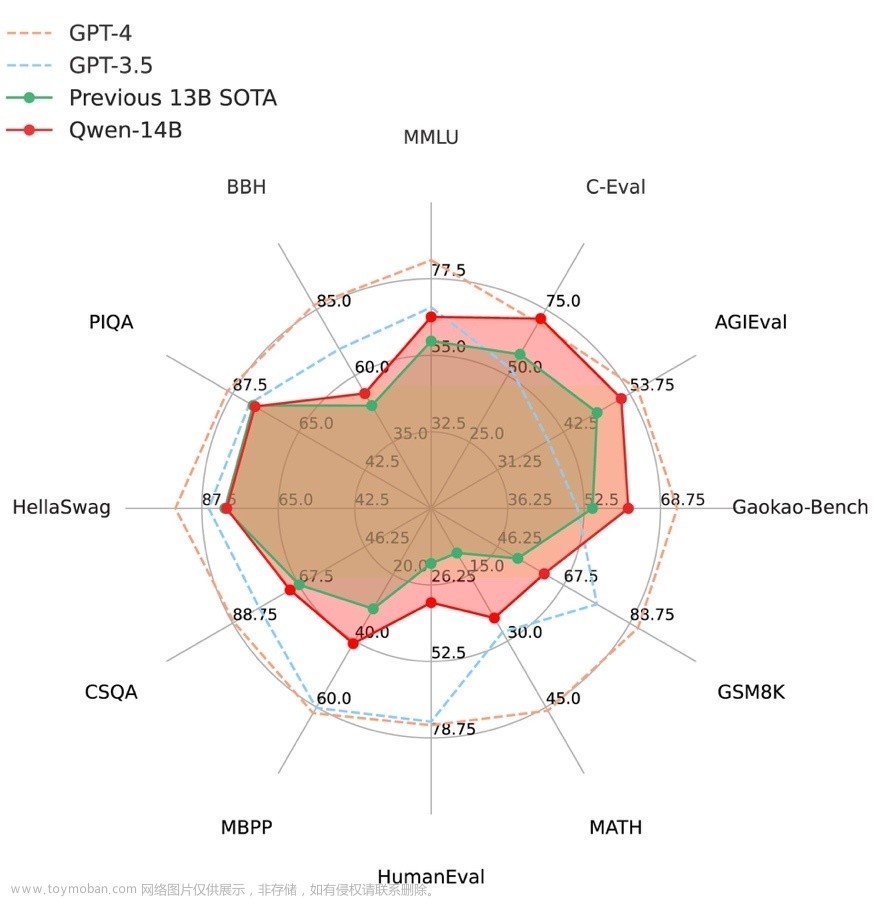

量化方案基于AutoGPTQ,提供了Int4量化模型,其中包括Qwen-7B-Chat和Qwen-14B-Chat。更新承诺在模型评估效果几乎没有损失的情况下,降低存储要求并提高推理速度。量化是指将模型权重和激活的精度降低以节省存储空间并提高推理速度的过程。AutoGPTQ是一种专有量化工具。Int4是指4位整数量化,与传统的8位量化相比,可以进一步减少存储要求。

如何使用Int4量化模型

在开始使用前,请先保证满足要求(如torch 2.0及以上,transformers版本为4.32.0及以上,等等),并安装所需安装包:

pip install auto-gptq optimum【Auto-GPT 】

AutoGPTQ将能够作为一个可扩展、灵活的量化后端,支持所有类似GPTQ的方法,并自动量化由Pytorch编写的LLM。说白了就是让模型能够轻量化。文章来源:https://www.toymoban.com/news/detail-716379.html

┏ (゜ω゜)=👉传送门==>GitHub - PanQiWei/AutoGPTQ: An easy-to-use LLMs quantization packa文章来源地址https://www.toymoban.com/news/detail-716379.html

到了这里,关于【通义千问】大模型Qwen GitHub开源工程学习笔记(4)-- 模型的量化与离线部署的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!